ELKstack 中文指南 Elk Stack Guide Cn

elk-stack-guide-cn

User Manual:

Open the PDF directly: View PDF ![]() .

.

Page Count: 647 [warning: Documents this large are best viewed by clicking the View PDF Link!]

1.1

1.2

1.2.1

1.2.1.1

1.2.1.2

1.2.1.3

1.2.1.4

1.2.1.5

1.2.2

1.2.2.1

1.2.2.1.1

1.2.2.1.2

1.2.2.1.3

1.2.2.1.4

1.2.2.2

1.2.2.2.1

1.2.2.2.2

1.2.2.2.3

1.2.2.2.4

1.2.2.3

1.2.2.3.1

1.2.2.3.2

1.2.2.3.3

1.2.2.3.4

1.2.2.3.5

1.2.2.3.6

1.2.2.3.7

目錄

前言

Logstash

入门示例

下载安装

helloworld

配置语法

plugin的安装

长期运行

插件配置

input配置

file

stdin

syslog

tcp

codec配置

json

multiline

collectd

netflow

filter配置

date

grok

dissect

geoip

json

kv

metrics

2

1.2.2.3.8

1.2.2.3.9

1.2.2.3.10

1.2.2.3.11

1.2.2.4

1.2.2.4.1

1.2.2.4.2

1.2.2.4.3

1.2.2.4.4

1.2.2.4.5

1.2.2.4.6

1.2.2.4.7

1.2.2.4.8

1.2.2.4.9

1.2.3

1.2.3.1

1.2.3.2

1.2.3.3

1.2.3.4

1.2.3.5

1.2.3.6

1.2.3.7

1.2.4

1.2.4.1

1.2.4.2

1.2.4.2.1

1.2.4.2.2

1.2.4.2.3

1.2.5

1.2.5.1

mutate

ruby

split

elapsed

output配置

elasticsearch

email

exec

file

nagios

statsd

stdout

tcp

hdfs

场景示例

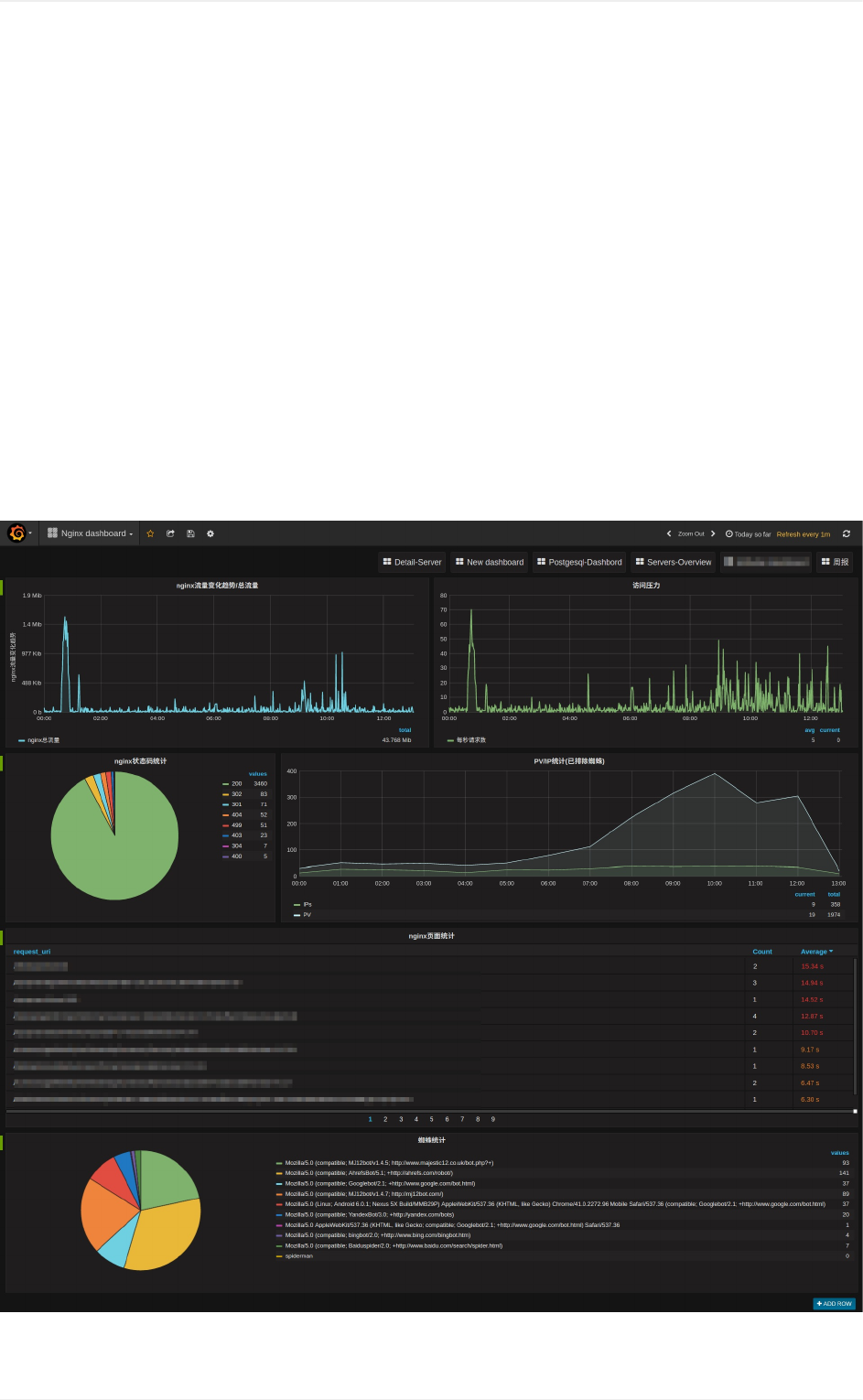

nginx访问日志

nginx错误日志

postfix日志

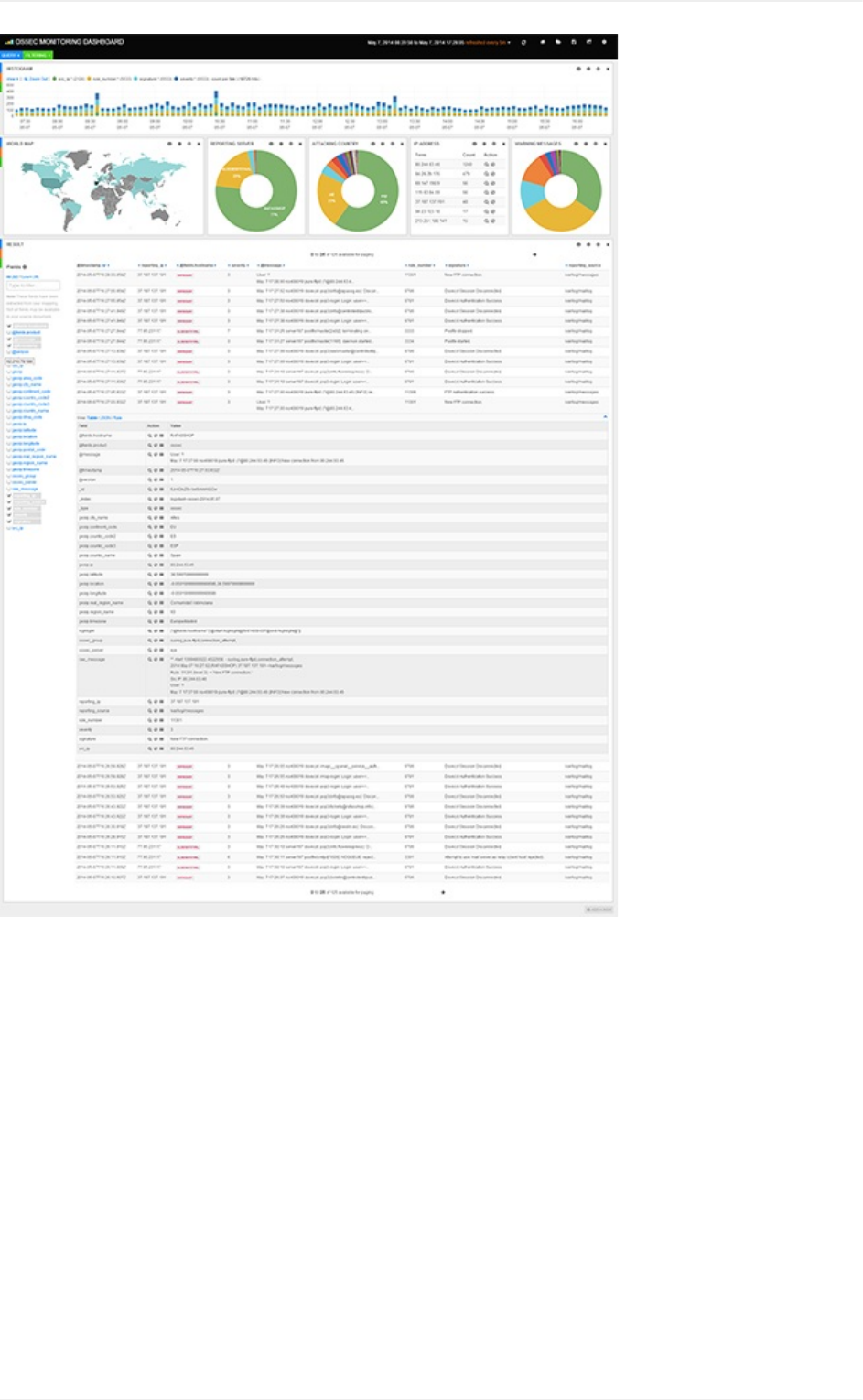

ossec日志

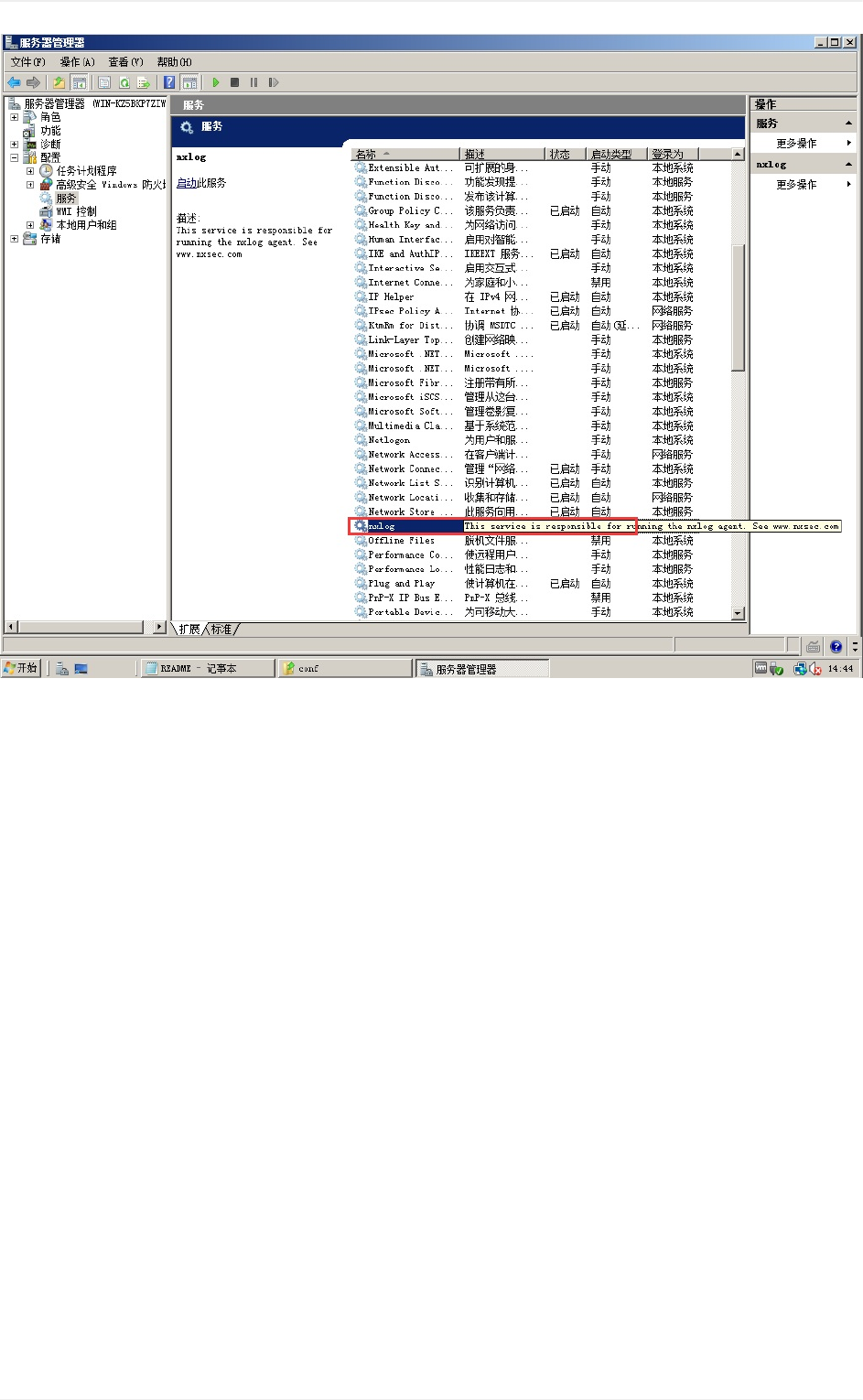

windows系统日志

Java日志

MySQL慢查询日志

性能与测试

generator方式

监控方案

logstash-input-heartbeat方式

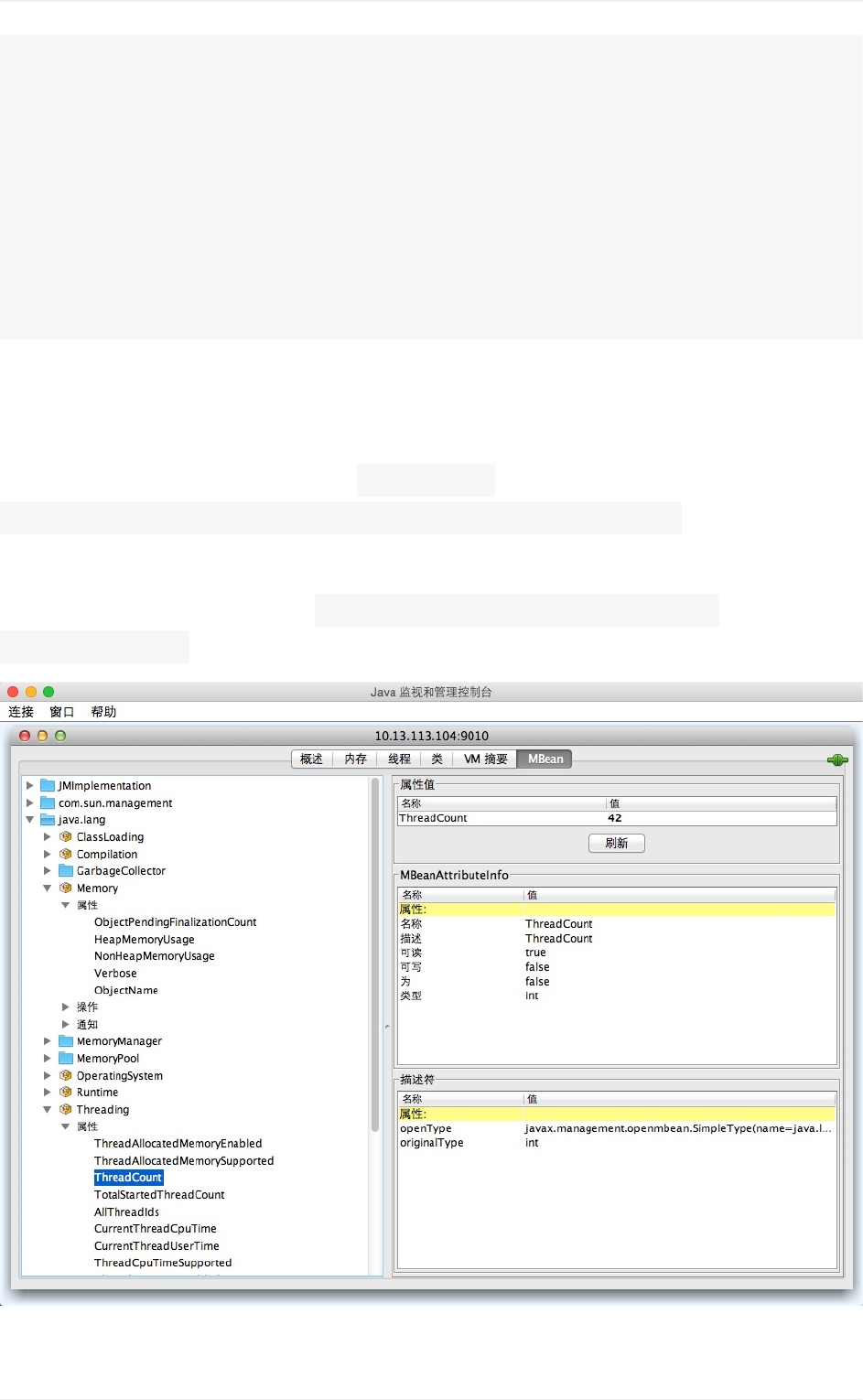

jmx启动参数方式

API方式

扩展方案

通过redis传输

3

1.2.5.2

1.2.5.3

1.2.5.4

1.2.5.5

1.2.5.6

1.2.5.7

1.2.5.8

1.2.6

1.2.6.1

1.2.6.2

1.2.7

1.2.7.1

1.3

1.3.1

1.3.2

1.3.3

1.3.4

1.4

1.4.1

1.4.1.1

1.4.1.2

1.4.1.3

1.4.1.4

1.4.1.5

1.4.2

1.4.2.1

1.4.2.2

1.4.2.3

1.4.2.4

1.4.3

通过kafka传输

AIX平台上的logstash-forwarder-java

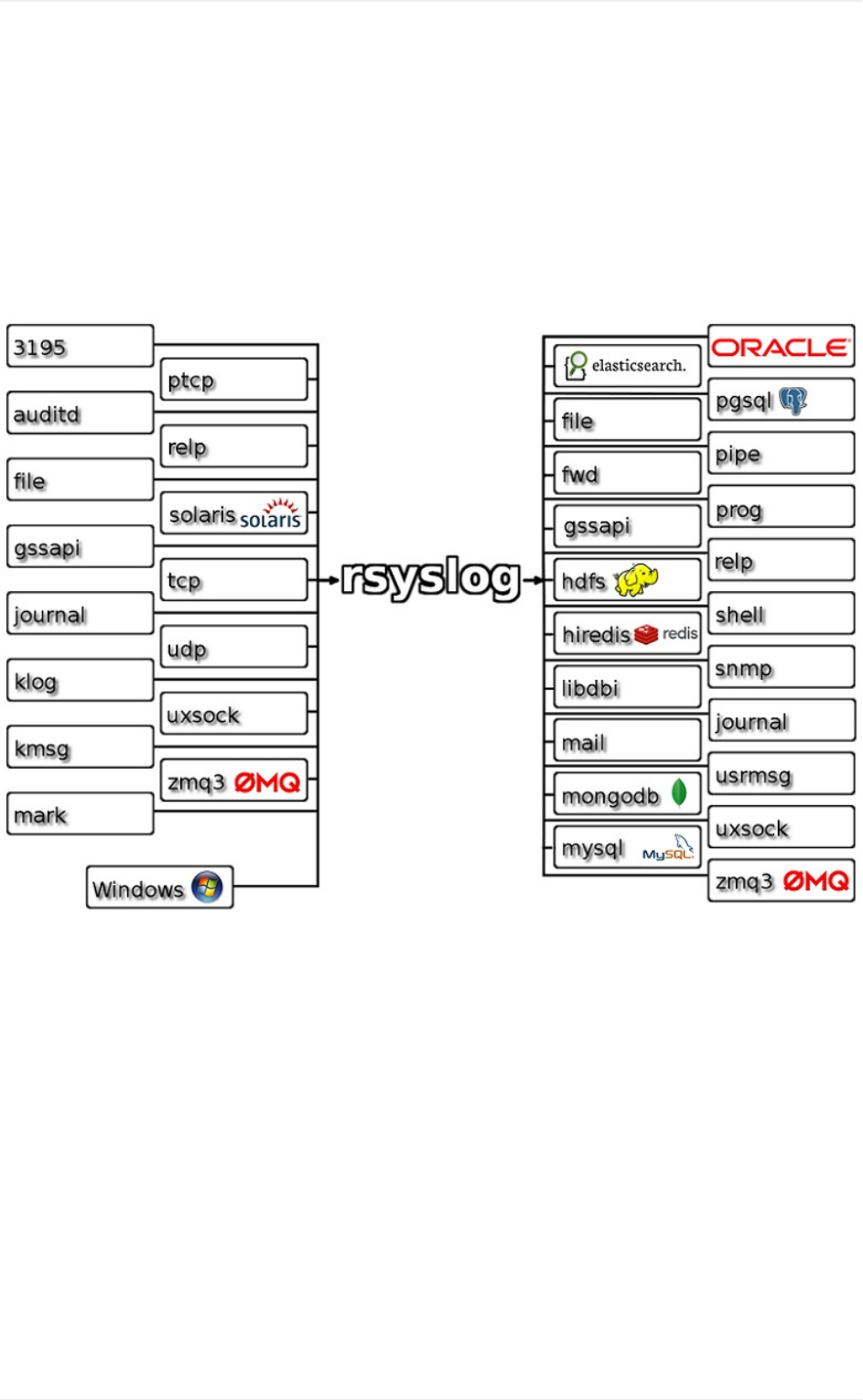

rsyslog

nxlog

heka

fluent

Message::Passing

源码解析

pipeline流程

Event的生成

插件开发

utmp插件示例

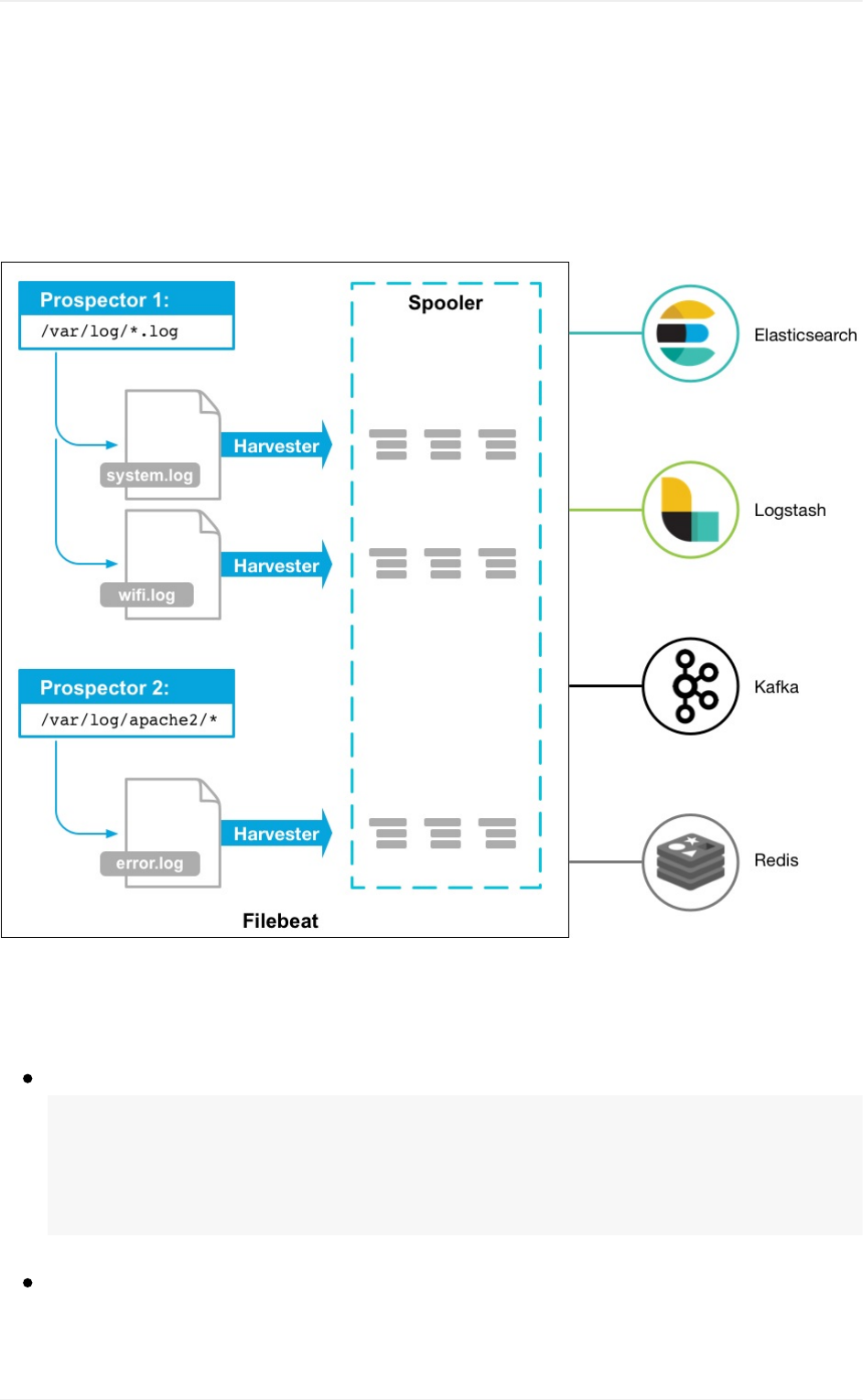

Beats

filebeat

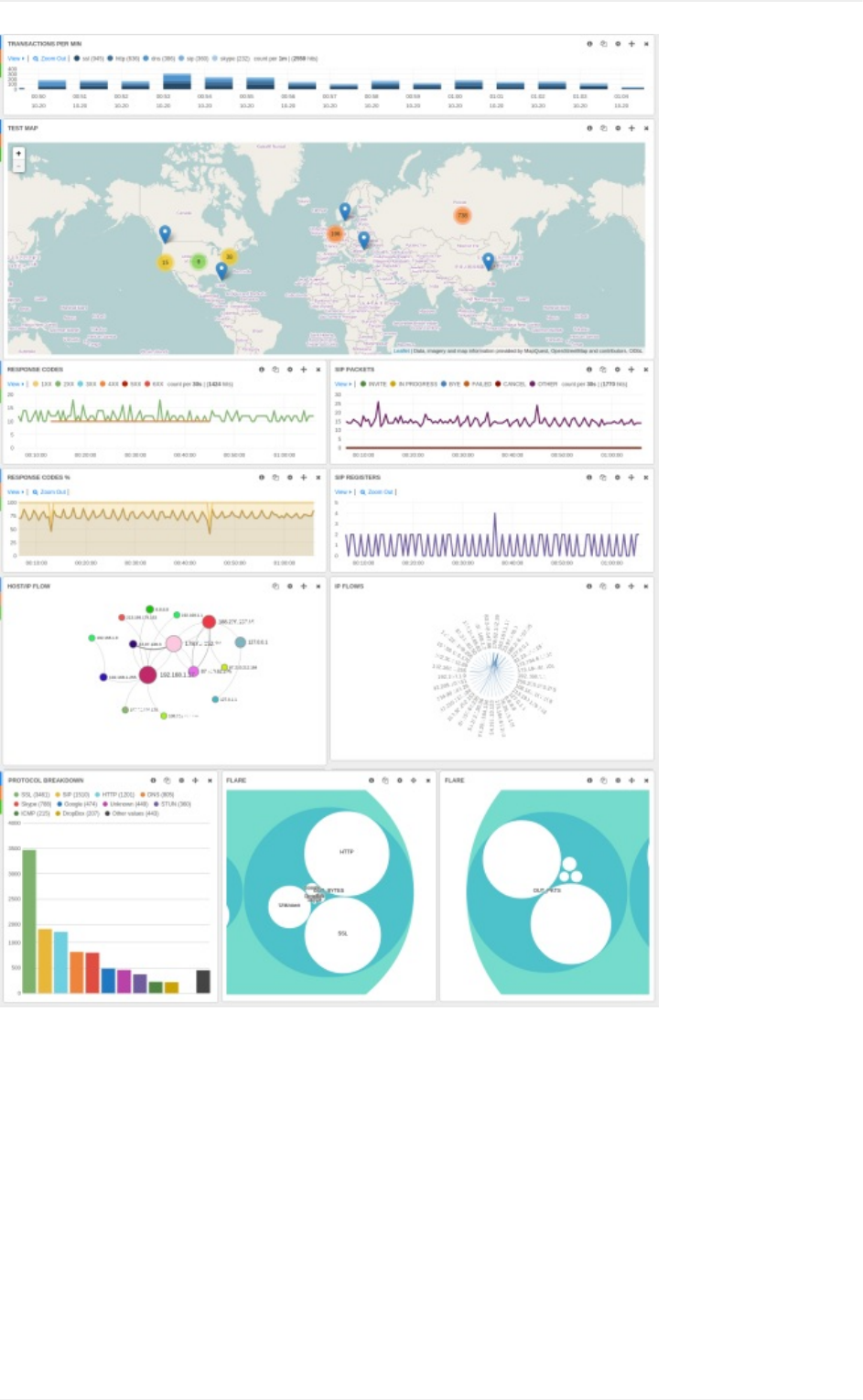

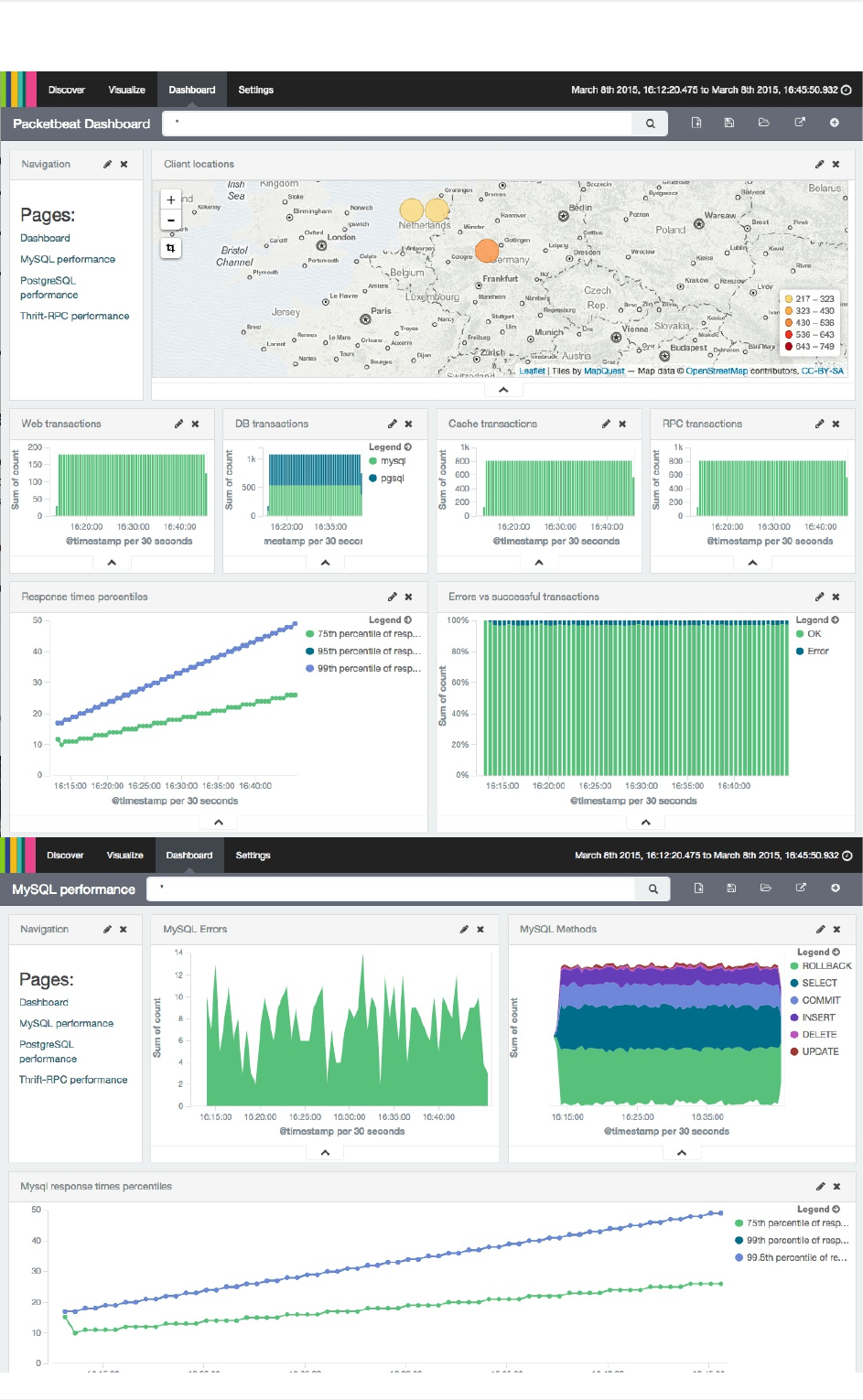

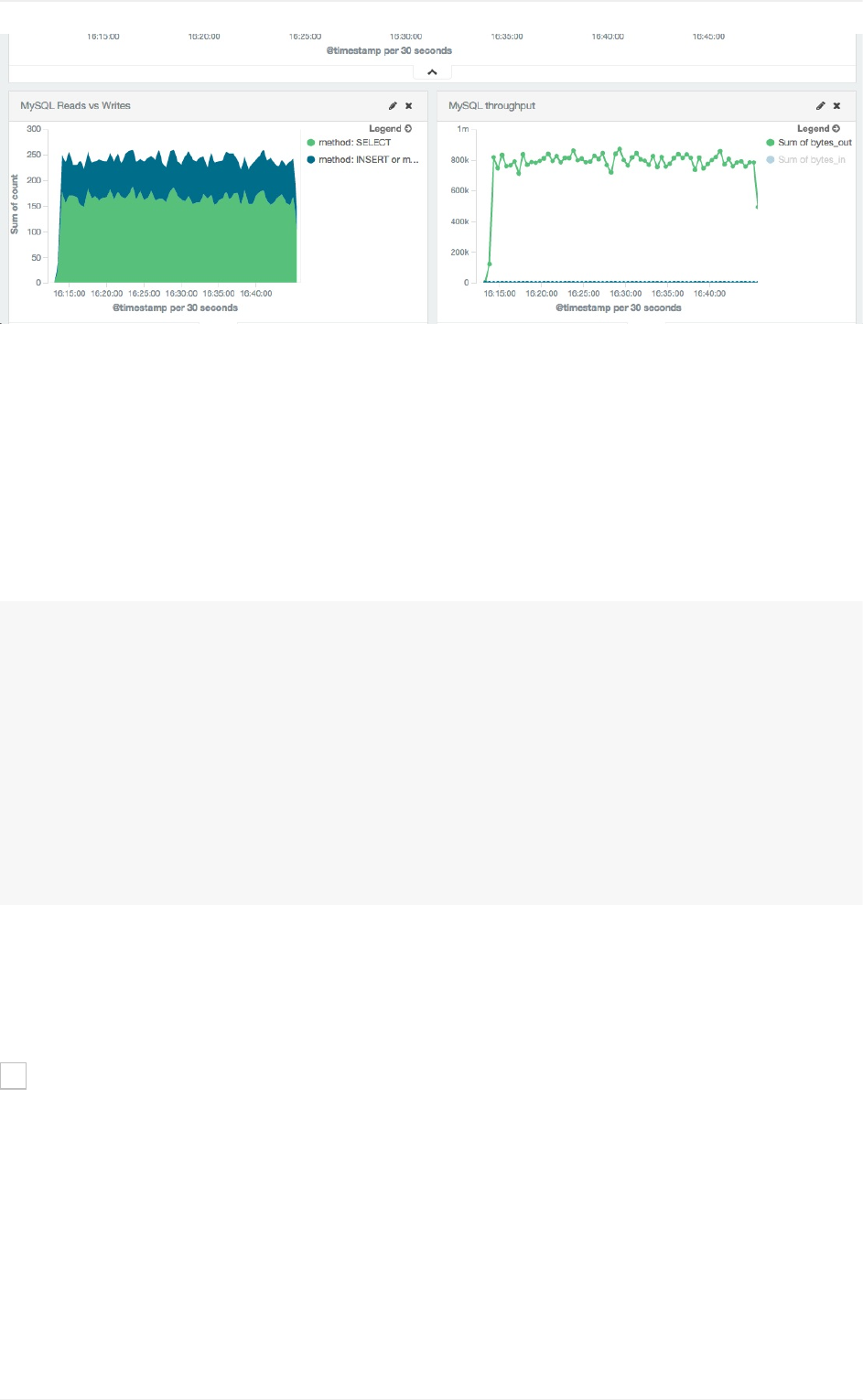

packetbeat网络流量分析

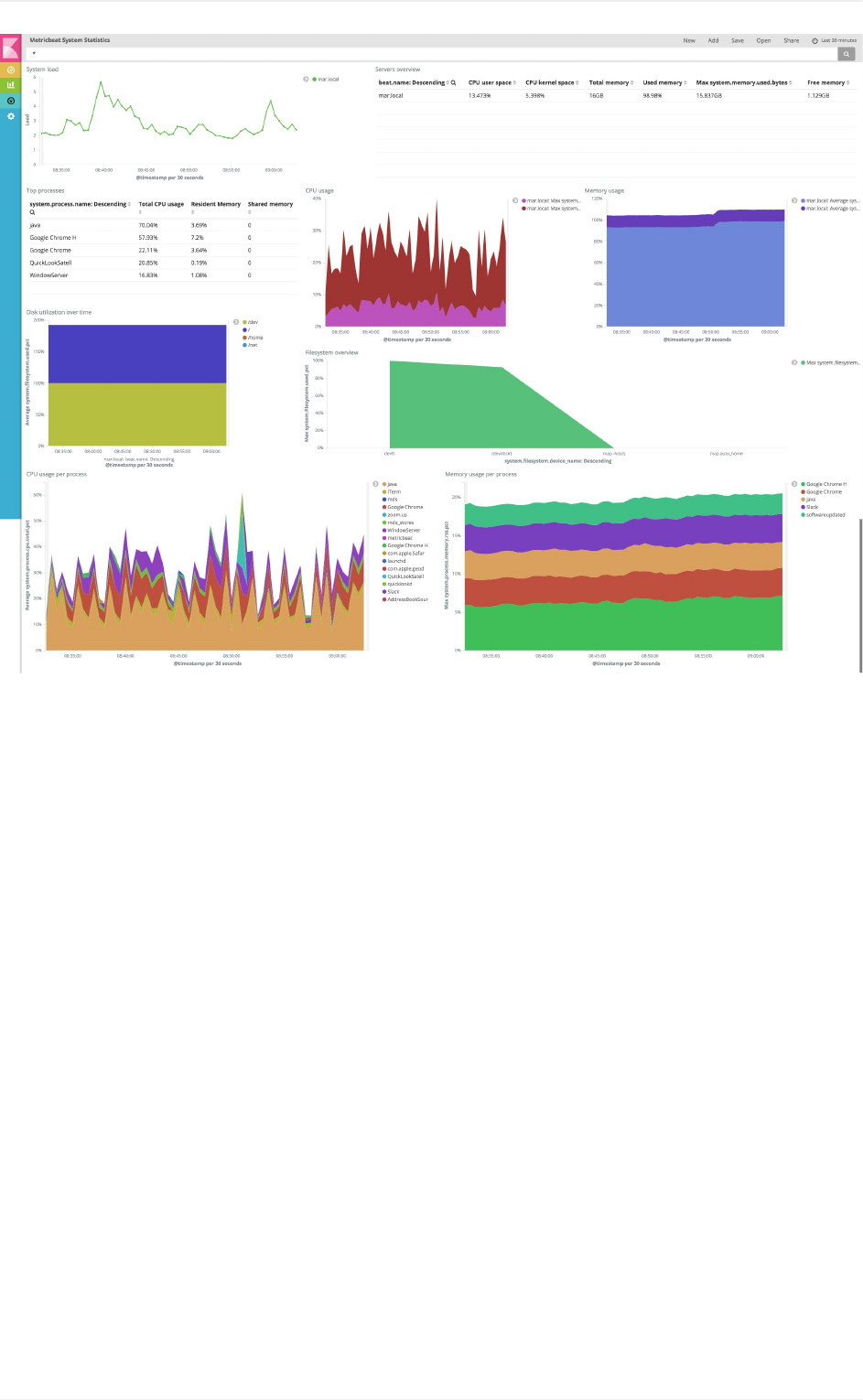

metricbeat

winlogbeat

ElasticSearch

架构原理

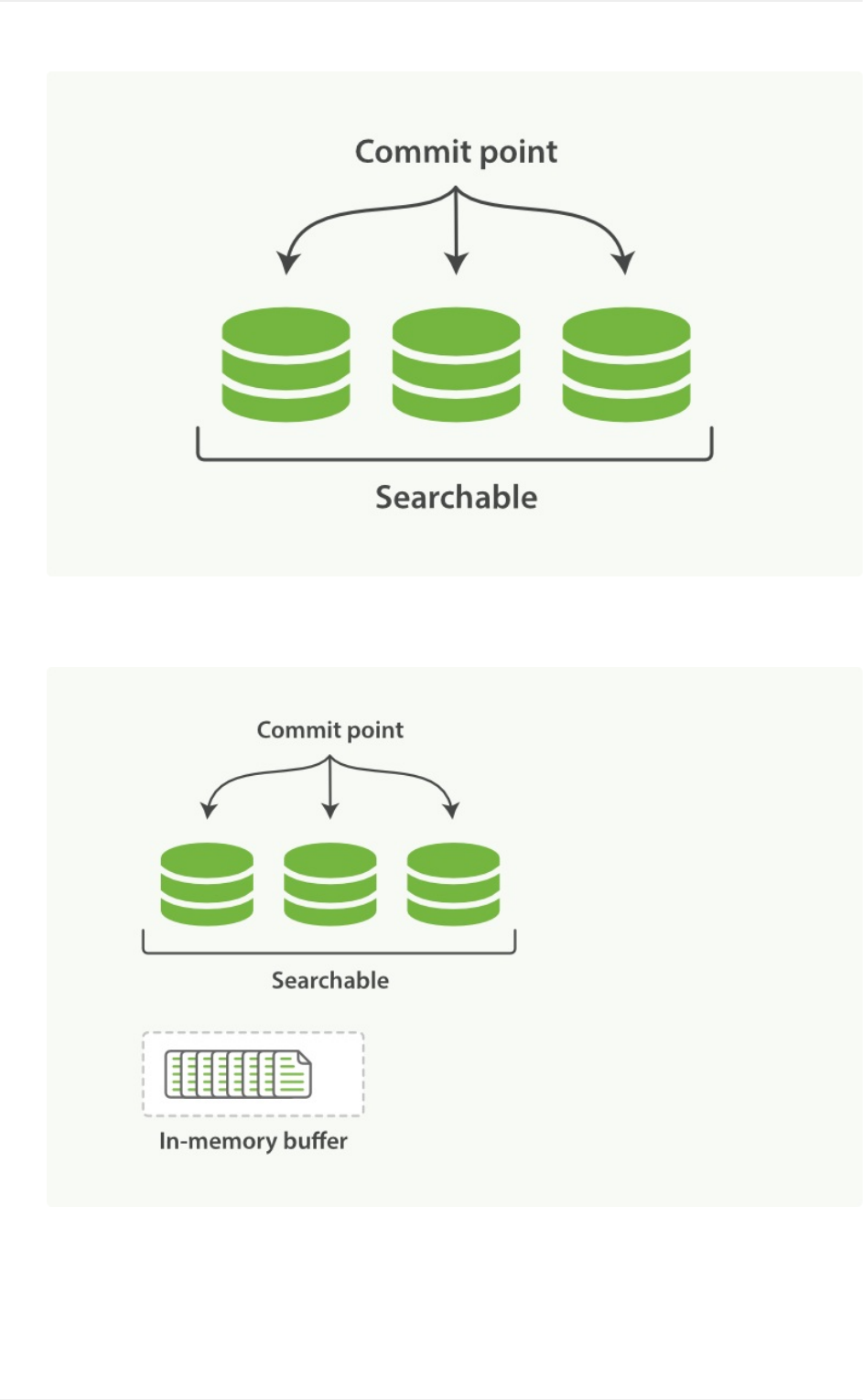

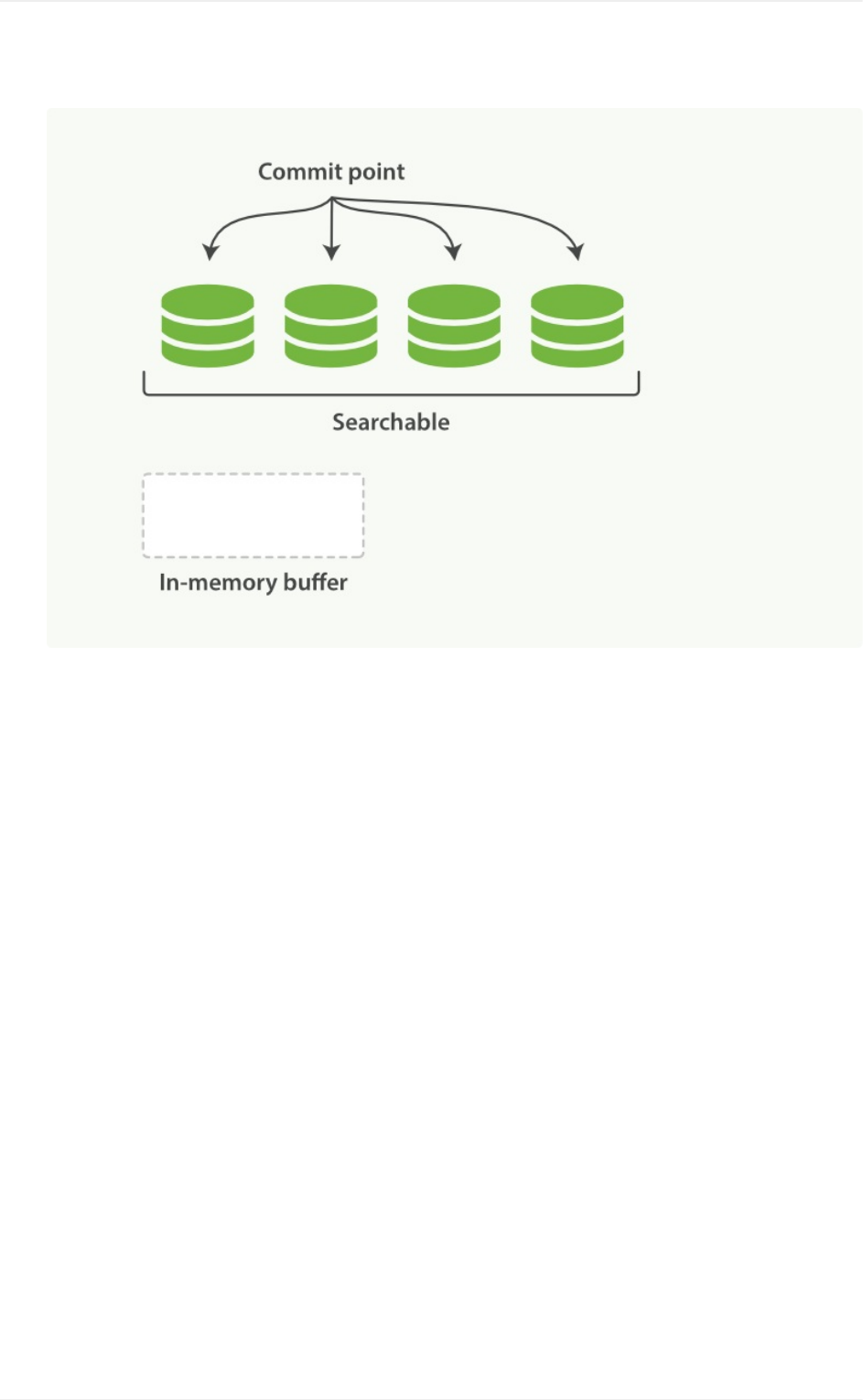

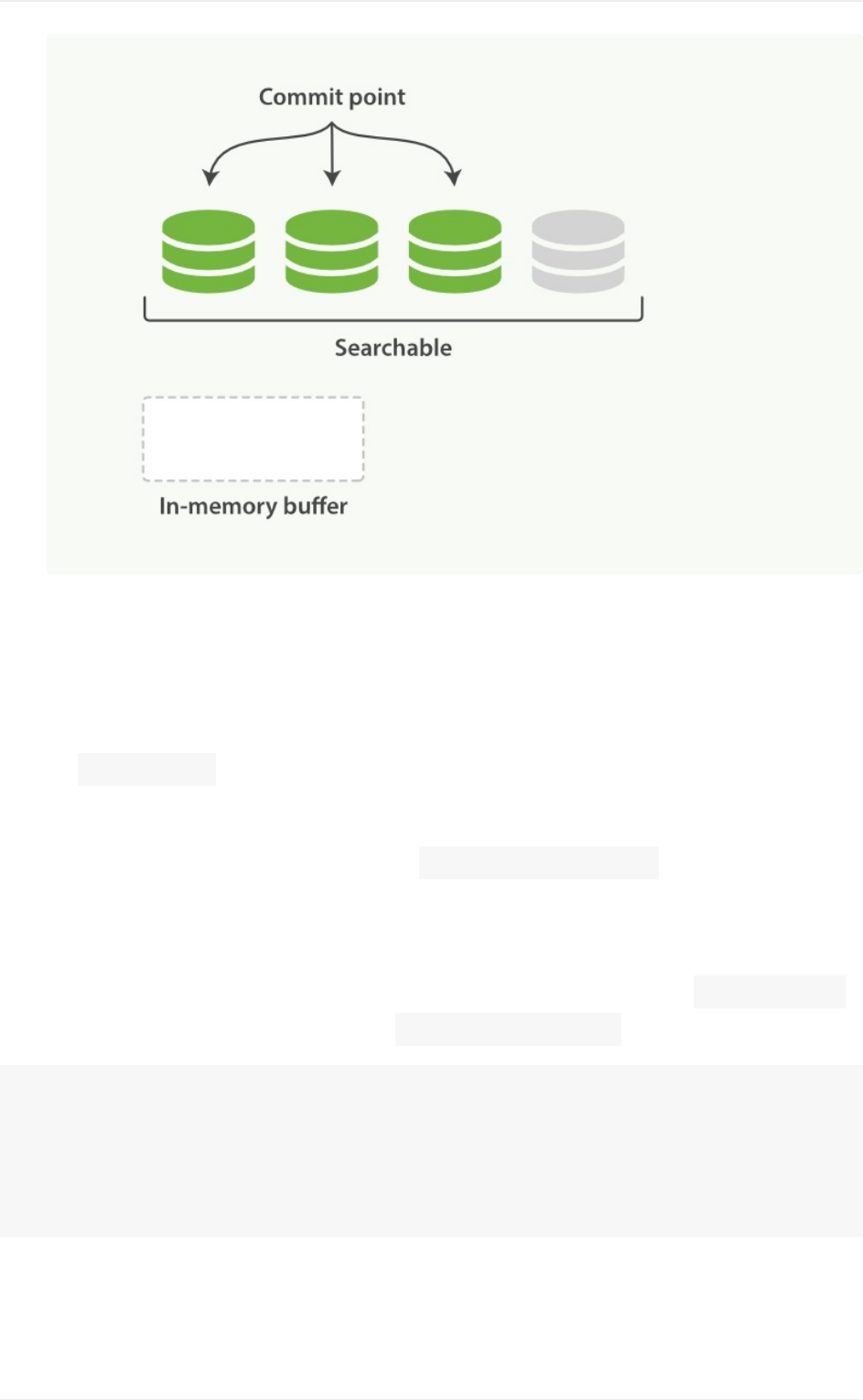

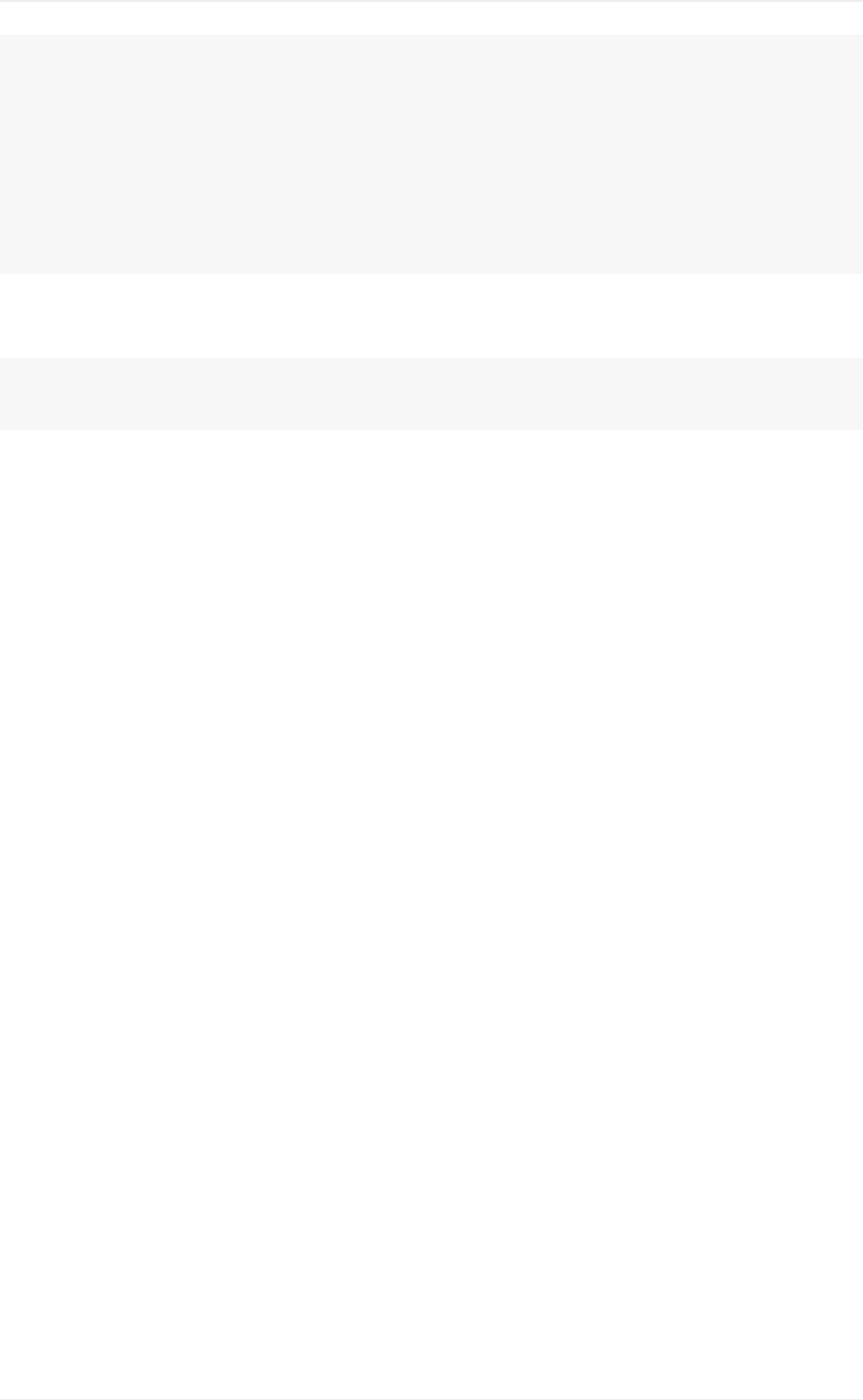

segment、buffer和translog对实时性的影响

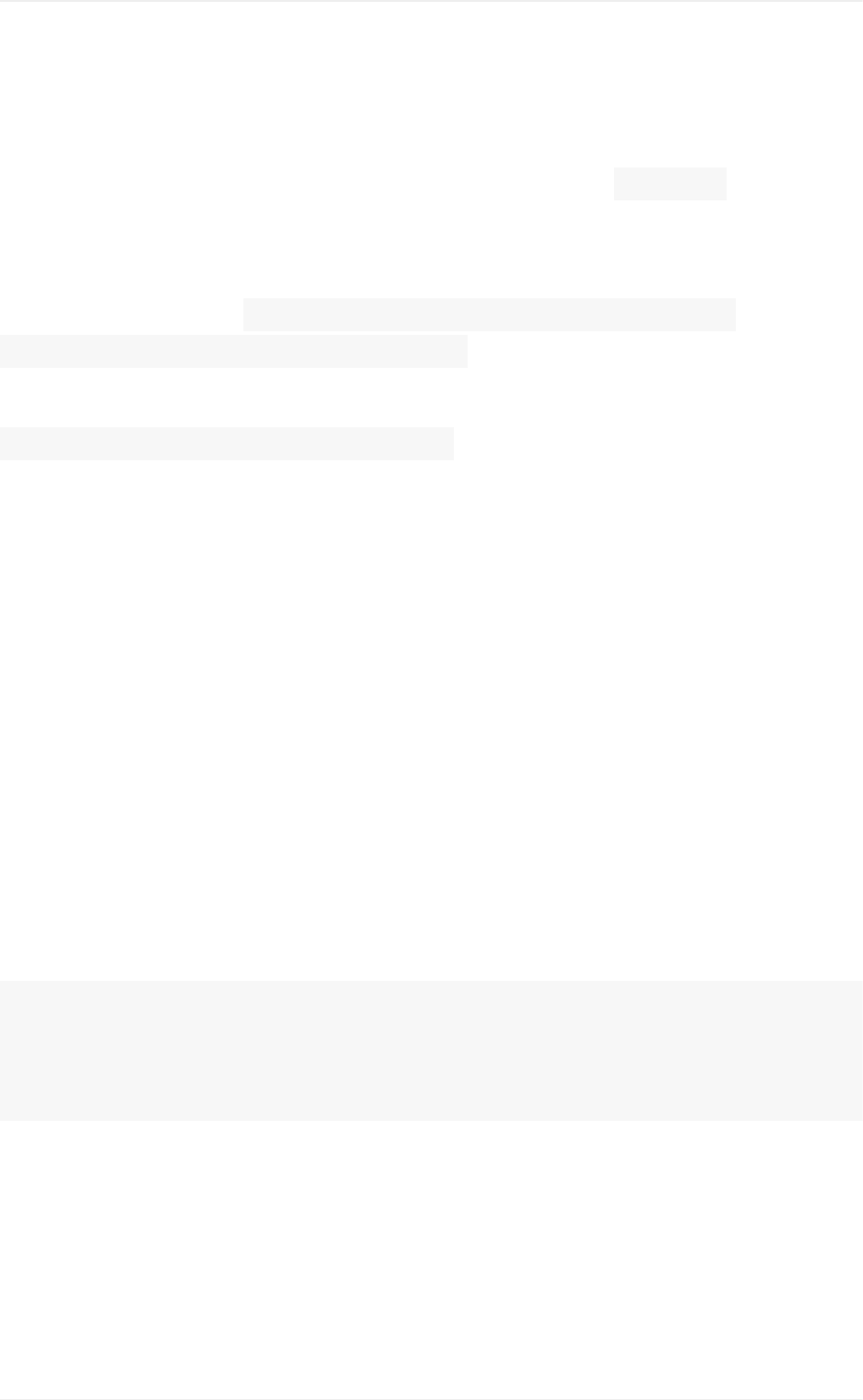

segmentmerge对写入性能的影响

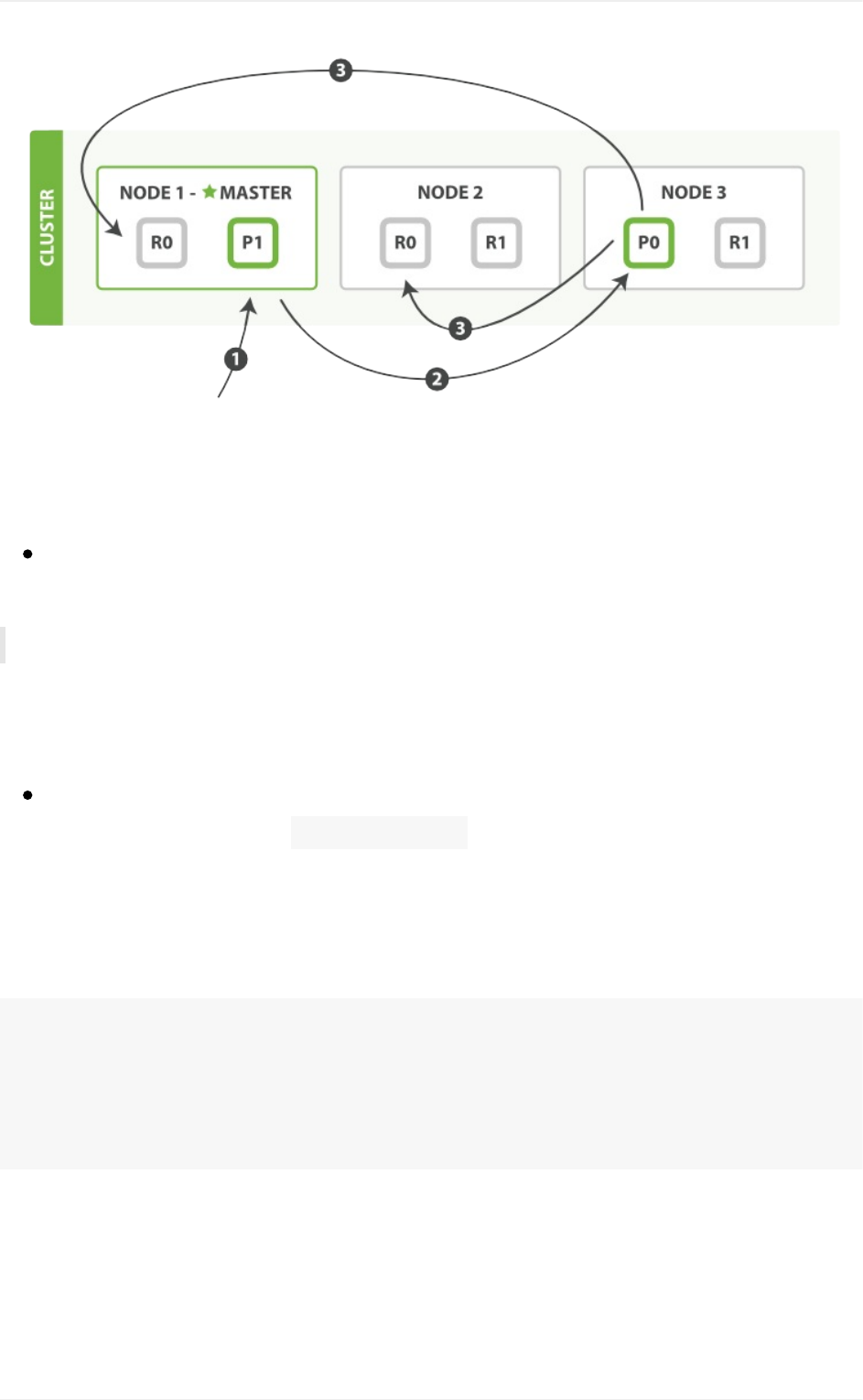

routing和replica的读写过程

shard的allocate控制

自动发现的配置

接口使用示例

增删改查操作

搜索请求

Painless脚本

reindex接口

性能优化

4

1.4.3.1

1.4.3.2

1.4.3.3

1.4.3.4

1.4.3.5

1.4.3.6

1.4.3.7

1.4.4

1.4.5

1.4.6

1.4.7

1.4.8

1.4.9

1.4.10

1.4.11

1.4.12

1.4.13

1.4.13.1

1.4.14

1.4.14.1

1.4.14.2

1.4.15

1.4.15.1

1.4.15.1.1

1.4.15.1.2

1.4.15.1.3

1.4.15.1.4

1.4.15.1.5

1.4.15.2

1.4.15.3

bulk提交

gateway配置

集群状态维护

缓存

fielddata

curator工具

profile接口

rally测试方案

多集群互联

别名的应用

映射与模板的定制

puppet-elasticsearch模块的使用

计划内停机升级的操作流程

镜像备份

rollover和shrink

Ingest节点

Hadoop集成

sparkstreaming交互

权限管理

Shield

Search-Guard在Elasticsearch2.x上的运用

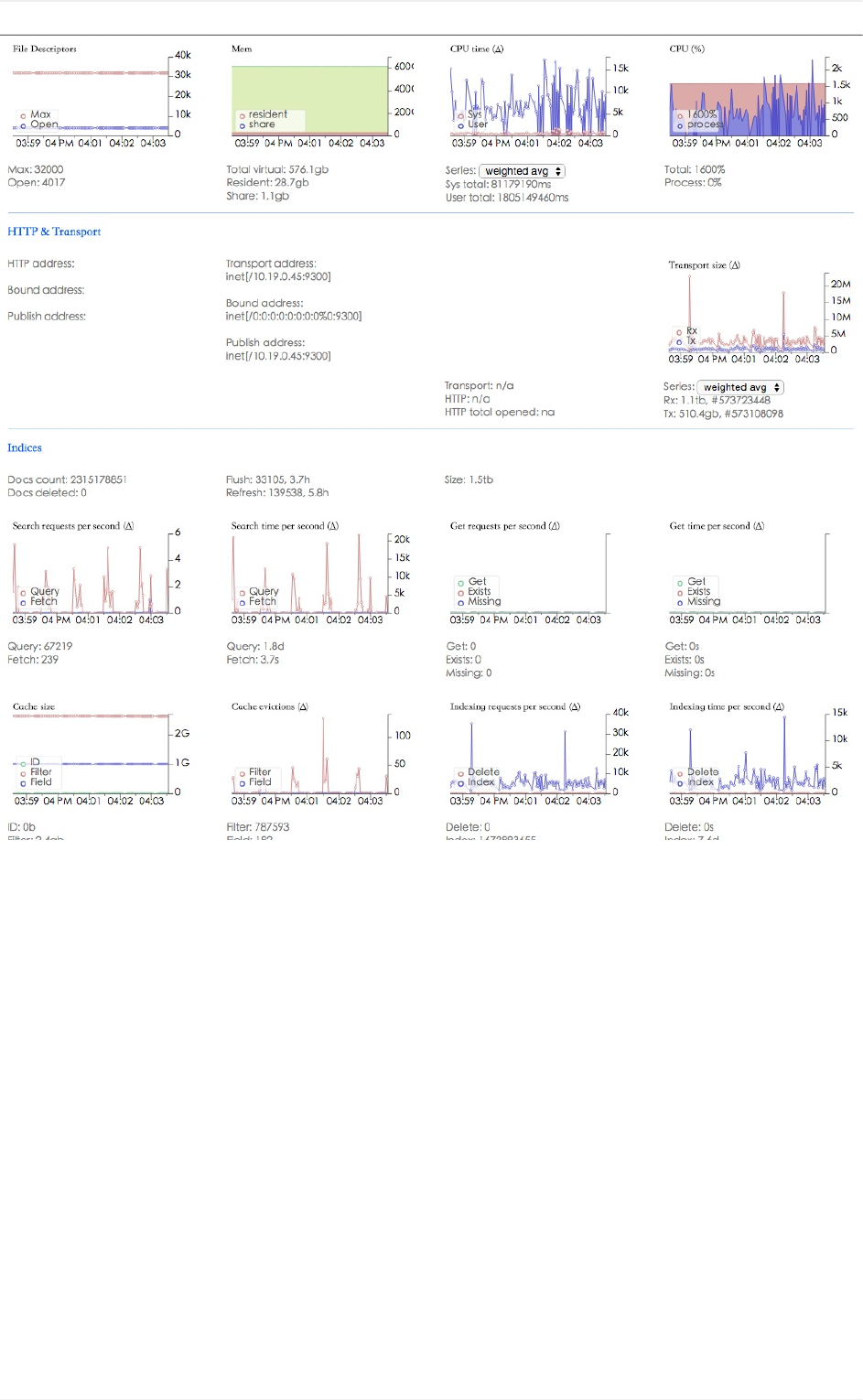

监控方案

监控相关接口

集群健康状态

节点状态

索引状态

任务管理

cat接口的命令行使用

日志记录

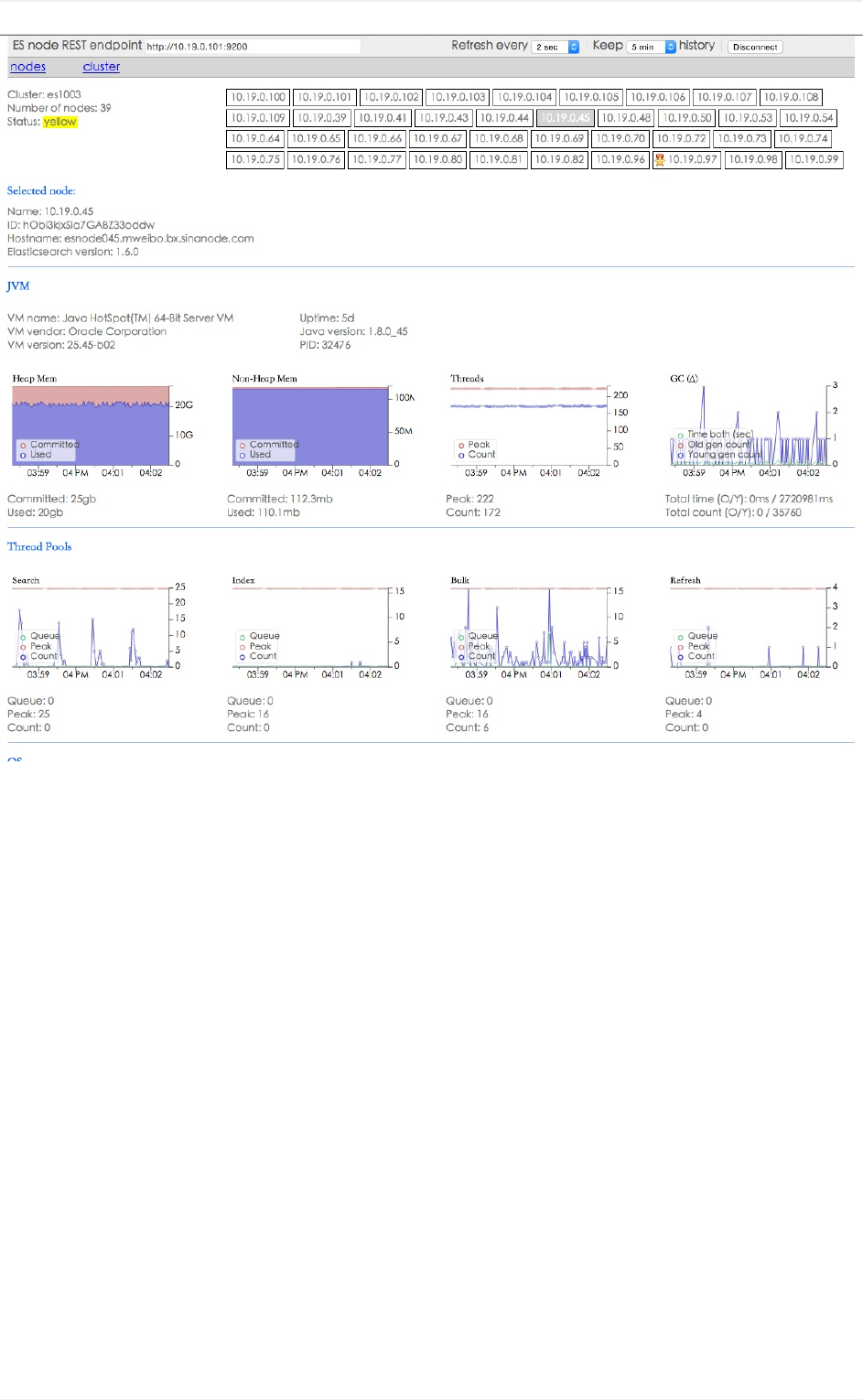

实时bigdesk方案

5

1.4.15.4

1.4.15.5

1.4.16

1.4.16.1

1.4.16.2

1.4.16.3

1.4.16.4

1.4.16.5

1.4.16.6

1.4.16.7

1.5

1.5.1

1.5.2

1.5.3

1.5.4

1.5.4.1

1.5.4.2

1.5.4.3

1.5.4.4

1.5.4.5

1.5.4.6

1.5.4.7

1.5.4.8

1.5.5

1.5.6

1.5.7

1.5.8

1.5.9

1.5.9.1

1.5.9.2

cerebro

zabbixtrapper方案

ES在运维监控领域的其他玩法

percolator接口

watcher报警

ElastAlert

时序数据库

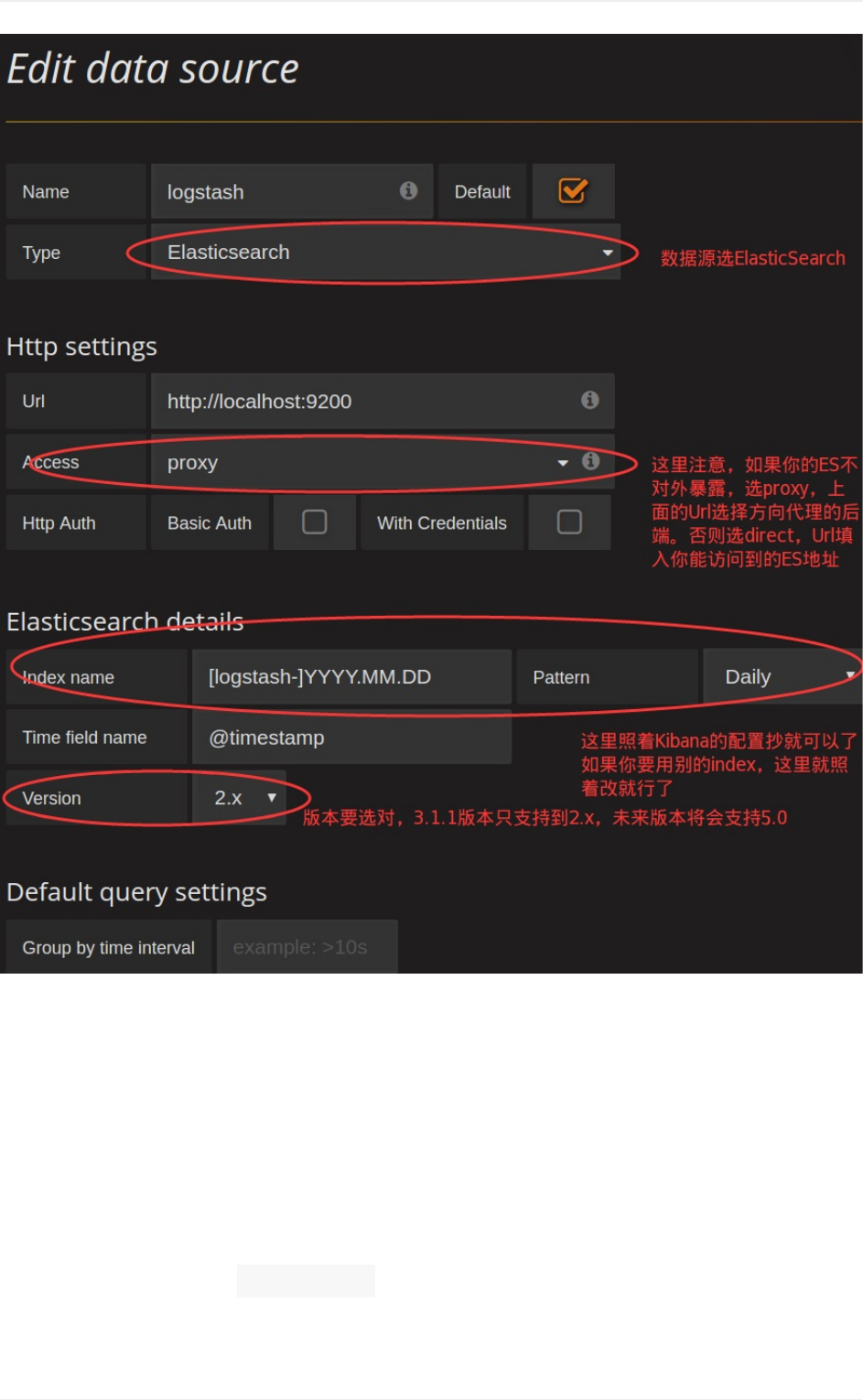

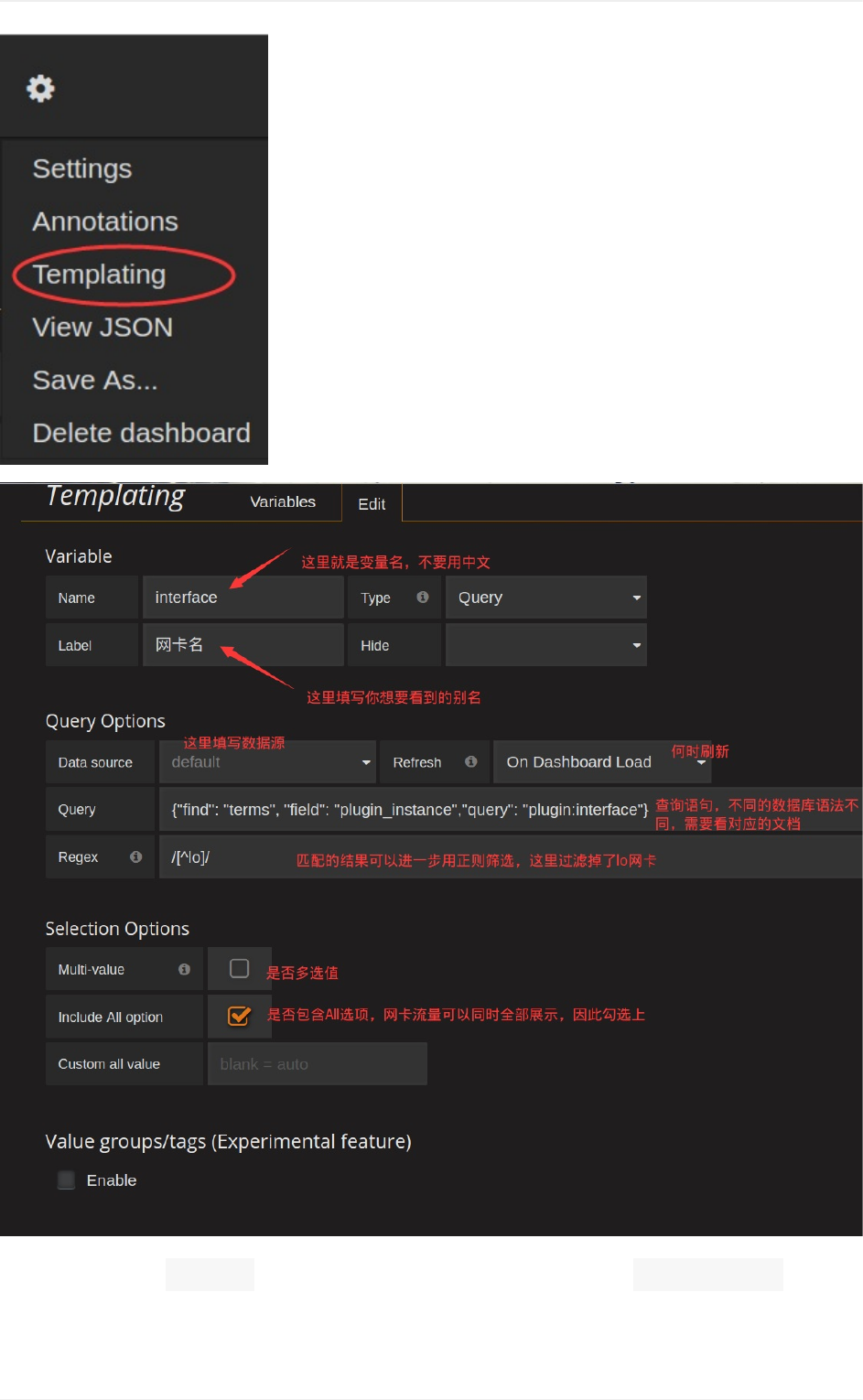

Grafana

juttle

Etsy的Kale异常检测

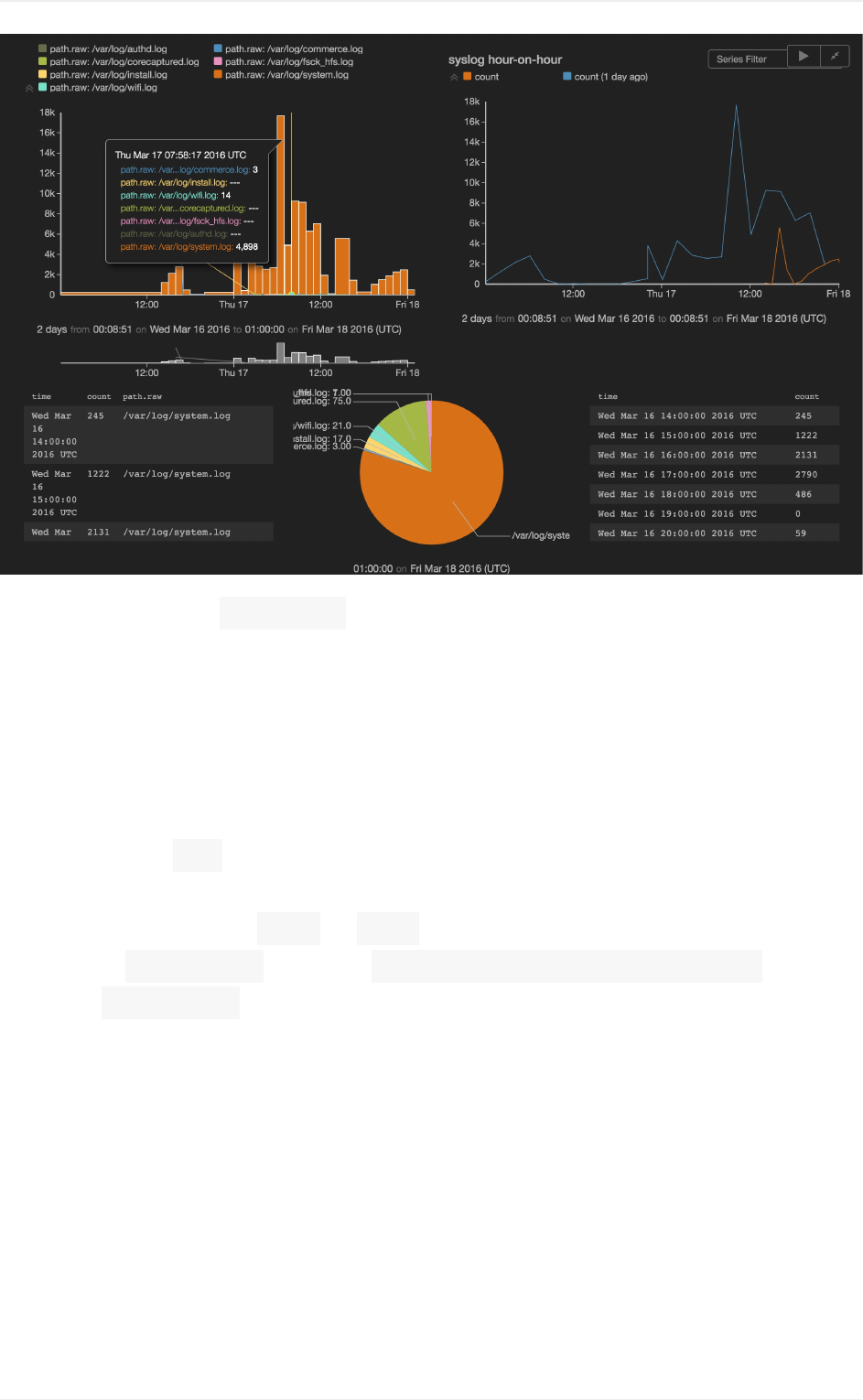

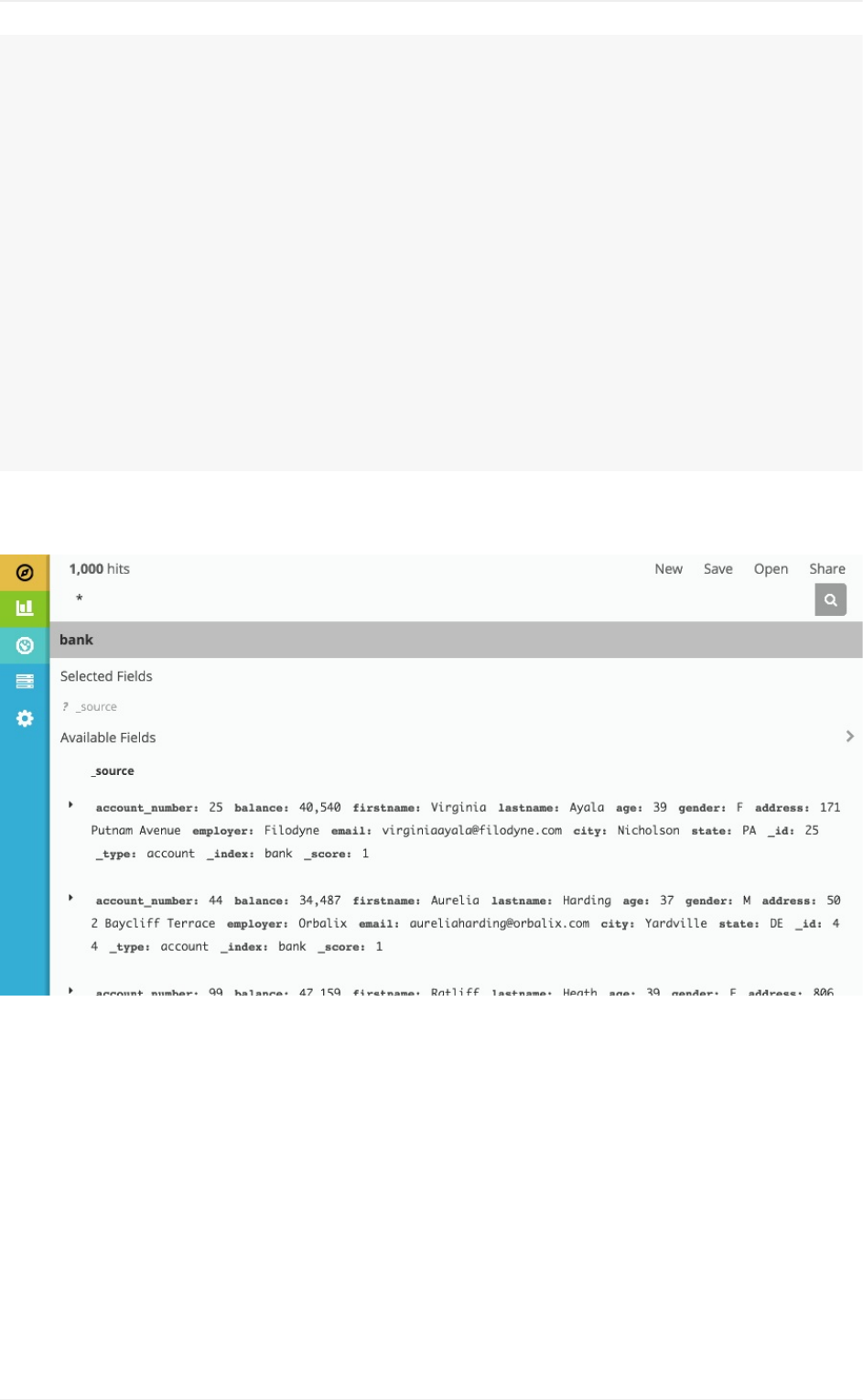

Kibana5

安装、配置和运行

生产环境部署

discover功能

各visualize功能

area

table

line

markdown

metric

pie

tilemap

verticalbar

dashboard功能

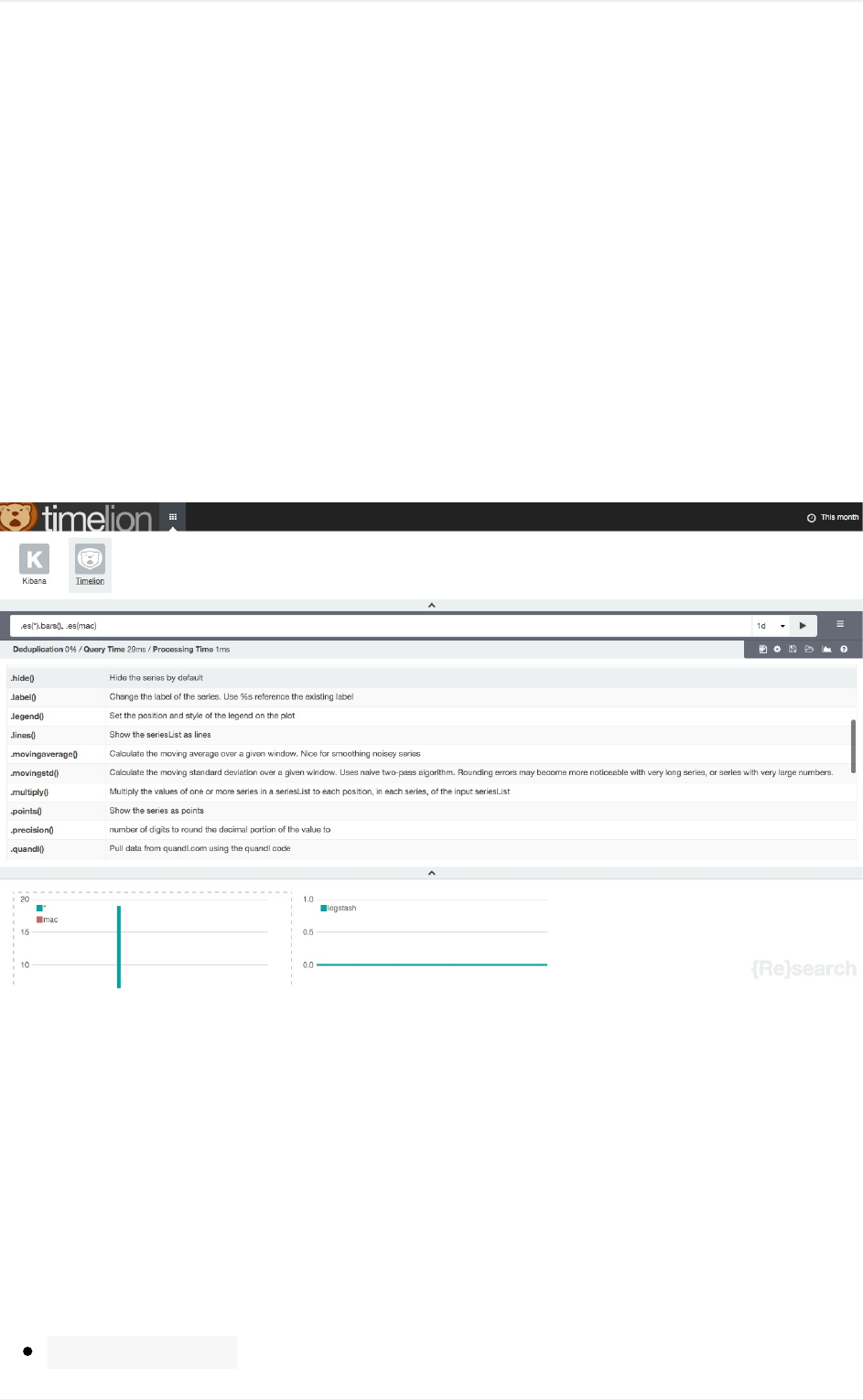

timelion介绍

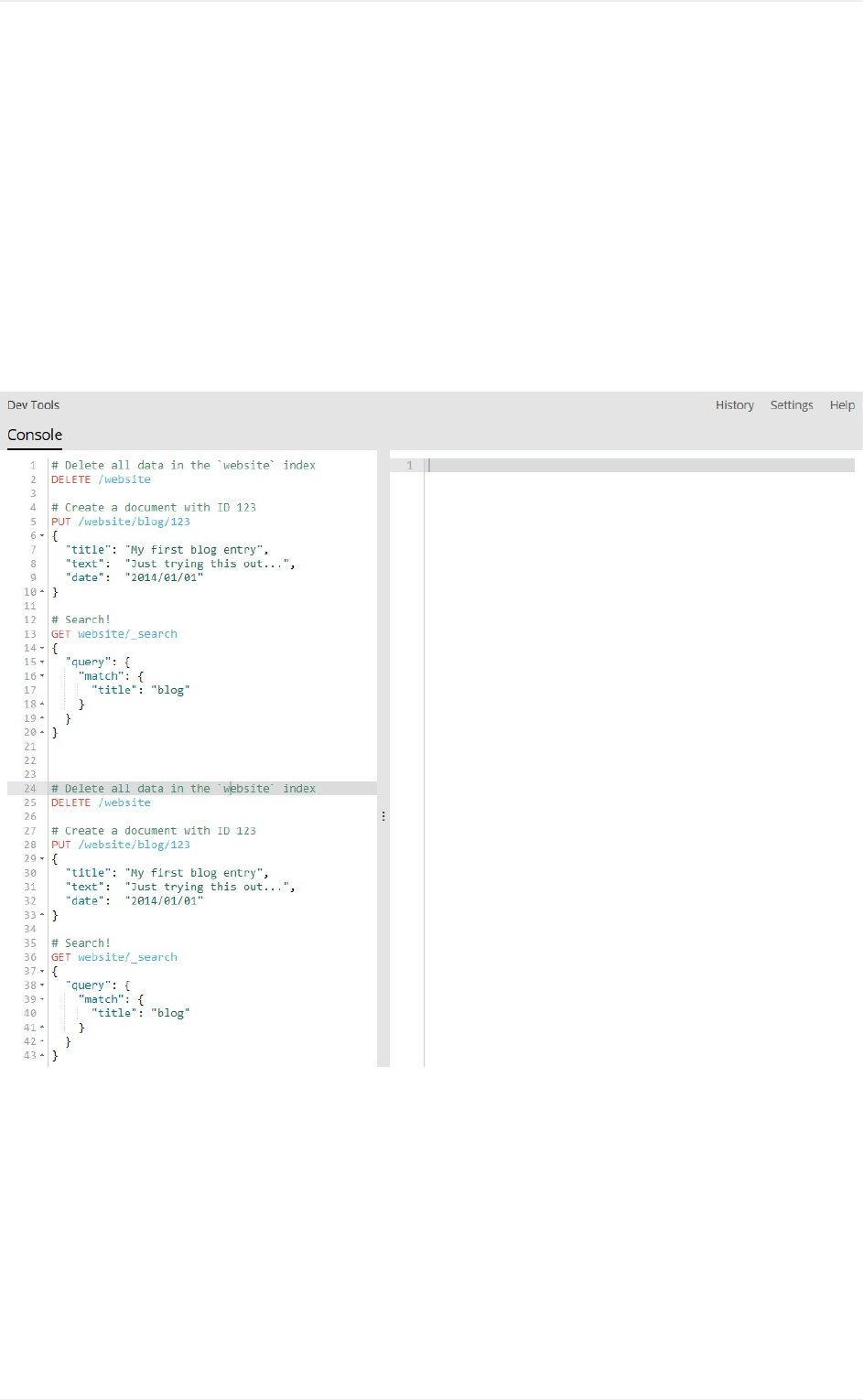

console介绍

setting功能

常用subagg示例

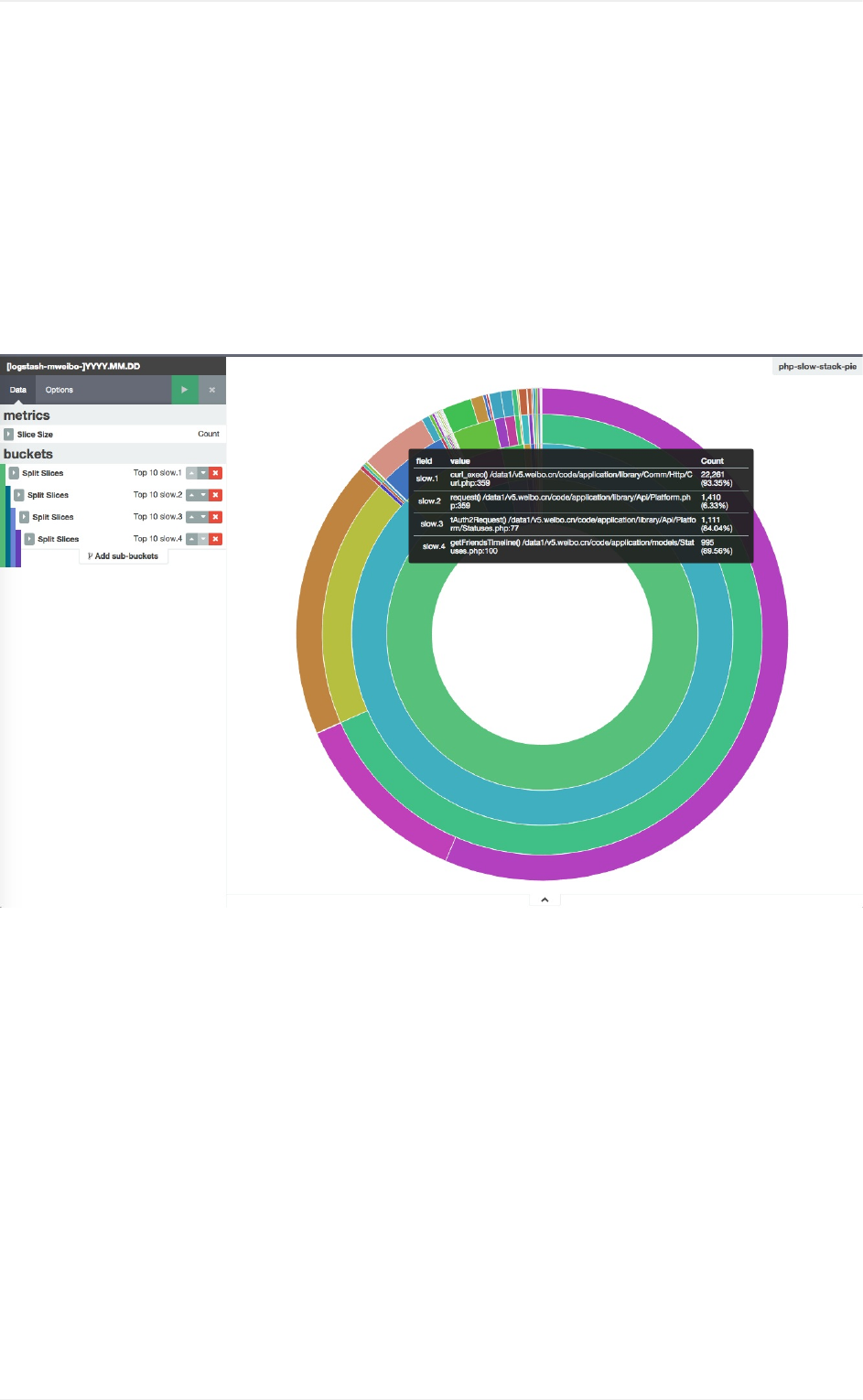

函数堆栈链分析

分图统计

6

前言

ElasticStack是原ELKStack在5.0版本加入Beats套件后的新称呼。

ElasticStack在最近两年迅速崛起,成为机器数据分析,或者说实时日志处理领

域,开源界的第一选择。和传统的日志处理方案相比,ElasticStack具有如下几个

优点:

处理方式灵活。Elasticsearch是实时全文索引,不需要像storm那样预先编程

才能使用;

配置简易上手。Elasticsearch全部采用JSON接口,Logstash是RubyDSL

设计,都是目前业界最通用的配置语法设计;

检索性能高效。虽然每次查询都是实时计算,但是优秀的设计和实现基本可以

达到全天数据查询的秒级响应;

集群线性扩展。不管是Elasticsearch集群还是Logstash集群都是可以线性扩

展的;

前端操作炫丽。Kibana界面上,只需要点击鼠标,就可以完成搜索、聚合功

能,生成炫丽的仪表板。

当然,ElasticStack也并不是实时数据分析界的灵丹妙药。在不恰当的场景,反而

会事倍功半。我自2014年初开QQ群交流ElasticStack,发现网友们对Elastic

Stack的原理概念,常有误解误用;对实现的效果,又多有不能理解或者过多期望

而失望之处。更令我惊奇的是,网友们广泛分布在传统企业和互联网公司、开发和

运维领域、Linux和Windows平台,大家对非专精领域的知识,一般都缺乏了解,

这也成为使用ElasticStack时的一个障碍。

为此,写一本ElasticStack技术指南,帮助大家厘清技术细节,分享一些实战案

例,成为我近半年一大心愿。本书大体完工之后,幸得机械工业出版社华章公司青

睐,以《ELKStack权威指南》之名重修完善并出版,有意收藏者欢迎购买。

本人于ElasticStack,虽然接触较早,但本身专于web和app应用数据方面,动

笔以来,得到诸多朋友的帮助,详细贡献名单见合作名单。此外,还要特别感谢曾

勇(medcl)同学,完成ES在国内的启蒙式分享,并主办ES中国用户大会;吴晓刚

(wood)同学,积极帮助新用户们,并最早分享了携程的ElasticStack日亿级规模的

实例。

欢迎加入ElasticStack交流QQ群:315428175。

前言

8

欢迎捐赠,作者支付宝账号:rao.chenlin@gmail.com

Version

2016-10-27发布了ElasticStack5.0版。由于变动较大,本书Git仓库将master

分支统一调整为基于5.0的状态。

想要查阅过去k3、k4、logstash-2.x等不同老版本资料的读者,请下载ELK

release:https://github.com/chenryn/ELKstack-guide-cn/releases/tag/ELK

TODO

限于个人经验、时间和场景,有部分ElasticStack社区比较常见的用法介绍未完

成,期待各位同好出手。罗列如下:

es-hadoop用例

beats开发

codec/netflow的详解

filter/elapsed的用例

zeppelin的es用例

kibana的filter交互用法

painless的date对象用法:同比环比图

significant_textaggs用例

catnodeattrs接口

timelion保存成panel的用法

regionmap用法

前言

9

TimeSeriesVisualBuilder用法

ViewingDocumentContext用法

DeadLetterQueues讲解

前言

10

第一部分Logstash

Logstashisatoolformanagingeventsandlogs.Youcanuseittocollect

logs,parsethem,andstorethemforlateruse(like,forsearching).--

http://logstash.net

Logstash项目诞生于2009年8月2日。其作者是世界著名的运维工程师乔丹西塞

(JordanSissel),乔丹西塞当时是著名虚拟主机托管商DreamHost的员工,还发布

过非常棒的软件打包工具fpm,并主办着一年一度的sysadminadvent

calendar(adventcalendar文化源自基督教氛围浓厚的Perl社区,在每年圣诞来临

的12月举办,从12月1日起至12月24日止,每天发布一篇小短文介绍主题相

关技术)。

小贴士:Logstash动手很早,对比一下,scribed诞生于2008年,flume诞生于

2010年,Graylog2诞生于2010年,Fluentd诞生于2011年。

scribed在2011年进入半死不活的状态,大大激发了其他各种开源日志收集处理框

架的蓬勃发展,Logstash也从2011年开始进入commit密集期并延续至今。

作为一个系出名门的产品,Logstash的身影多次出现在SysadminWeekly上,它

和它的小伙伴们Elasticsearch、Kibana直接成为了和商业产品Splunk做比较的开

源项目(乔丹西塞曾经在博客上承认设计想法来自AWS平台上最大的第三方日志服

务商Loggly,而Loggly两位创始人都曾是Splunk员工)。

2013年,Logstash被Elasticsearch公司收购,ELKStack正式成为官方用语(随

着beats的加入改名为ElasticStack)。Elasticsearch本身也是近两年最受关注的

大数据项目之一,三次融资已经超过一亿美元。在Elasticsearch开发人员的共同

努力下,Logstash的发布机制,插件架构也愈发科学和合理。

社区文化

日志收集处理框架这么多,像scribe是facebook出品,flume是apache基金会项

目,都算声名赫赫。但logstash因乔丹西塞的个人性格,形成了一套独特的社区文

化。每一个在googlegroups的logstash-users组里问答的人都会看到这么一句

话:

Remember:ifanewuserhasabadtime,it'sabuginlogstash.

Logstash

11

所以,logstash是一个开放的,极其互助和友好的大家庭。有任何问题,尽管在

githubissue,Googlegroups,Freenode#logstashchannel上发问就好!

Logstash

12

基础知识

什么是Logstash?为什么要用Logstash?怎么用Logstash?

本章正是来回答这个问题,或许不完整,但是足够讲述一些基础概念。跟着我们安

装章节一步步来,你就可以成功的运行起来自己的第一个logstash了。

我可能不会立刻来展示logstash配置细节或者运用场景。我认为基础原理和语法的

介绍应该更加重要,这些知识未来对你的帮助绝对更大!

所以,认真阅读他们吧!

入门示例

13

安装

下载

直接下载官方发布的二进制包的,可以访问

https://www.elastic.co/downloads/logstash页面找对应操作系统和版本,点击下载

即可。不过更推荐使用软件仓库完成安装。

安装

如果你必须得在一些很老的操作系统上运行Logstash,那你只能用源代码包部署

了,记住要自己提前安装好Java:

yuminstalljava-1.8.0-openjdk

exportJAVA_HOME=/usr/java

软件仓库的配置,主要两大平台如下:

Debian平台

wget-O-http://packages.elasticsearch.org/GPG-KEY-elasticsearc

h|apt-keyadd-

cat>>/etc/apt/sources.list<<EOF

debhttp://packages.elasticsearch.org/logstash/5.0/debianstable

main

EOF

apt-getupdate

apt-getinstalllogstash

Redhat平台

下载安装

14

rpm--importhttp://packages.elasticsearch.org/GPG-KEY-elasticse

arch

cat>/etc/yum.repos.d/logstash.repo<<EOF

[logstash-5.0]

name=logstashrepositoryfor5.0.xpackages

baseurl=http://packages.elasticsearch.org/logstash/5.0/centos

gpgcheck=1

gpgkey=http://packages.elasticsearch.org/GPG-KEY-elasticsearch

enabled=1

EOF

yumcleanall

yuminstalllogstash

下载安装

15

HelloWorld

和绝大多数IT技术介绍一样,我们以一个输出"helloworld"的形式开始我们的

logstash学习。

运行

在终端中,像下面这样运行命令来启动Logstash进程:

#bin/logstash-e'input{stdin{}}output{stdout{codec=>rubydebug}

}'

然后你会发现终端在等待你的输入。没问题,敲入HelloWorld,回车,然后看看

会返回什么结果!

结果

{

"message"=>"HelloWorld",

"@version"=>"1",

"@timestamp"=>"2014-08-07T10:30:59.937Z",

"host"=>"raochenlindeMacBook-Air.local",

}

没错!你搞定了!这就是全部你要做的。

解释

每位系统管理员都肯定写过很多类似这样的命令: catranddata|awk

'{print$2}'|sort|uniq-c|teesortdata。这个管道符|可以算是

Linux世界最伟大的发明之一(另一个是“一切皆文件”)。

Logstash就像管道符一样!

helloworld

16

你输入(就像命令行的cat)数据,然后处理过滤(就像awk或者uniq之类)

数据,最后输出(就像tee)到其他地方。

当然实际上,Logstash是用不同的线程来实现这些的。如果你运行top命令然

后按下H键,你就可以看到下面这样的输出:

PIDUSERPRNIVIRTRESSHRS%CPU%MEMTIME+COM

MAND

21401root1601249m303m10mS18.60.2866:25.46|wo

rker

21467root1501249m303m10mS3.70.2129:25.59>el

asticsearch.

21468root1501249m303m10mS3.70.2128:53.39>el

asticsearch.

21400root1501249m303m10mS2.70.2108:35.80<fi

le

21403root1501249m303m10mS1.30.249:31.89>ou

tput

21470root1501249m303m10mS1.00.256:24.24>el

asticsearch.

小贴士:logstash很温馨的给每个线程都取了名字,输入的叫xx,过滤的叫|xx

数据在线程之间以事件的形式流传。不要叫行,因为logstash可以处理多行事

件。

Logstash会给事件添加一些额外信息。最重要的就是@timestamp,用来标记事

件的发生时间。因为这个字段涉及到Logstash的内部流转,所以必须是一个joda

对象,如果你尝试自己给一个字符串字段重命名为@timestamp的话,Logstash

会直接报错。所以,请使用filters/date插件来管理这个特殊字段。

此外,大多数时候,还可以见到另外几个:

1. host标记事件发生在哪里。

2. type标记事件的唯一类型。

3. tags标记事件的某方面属性。这是一个数组,一个事件可以有多个标签。

你可以随意给事件添加字段或者从事件里删除字段。事实上事件就是一个Ruby对

象,或者更简单的理解为就是一个哈希也行。

helloworld

17

配置语法

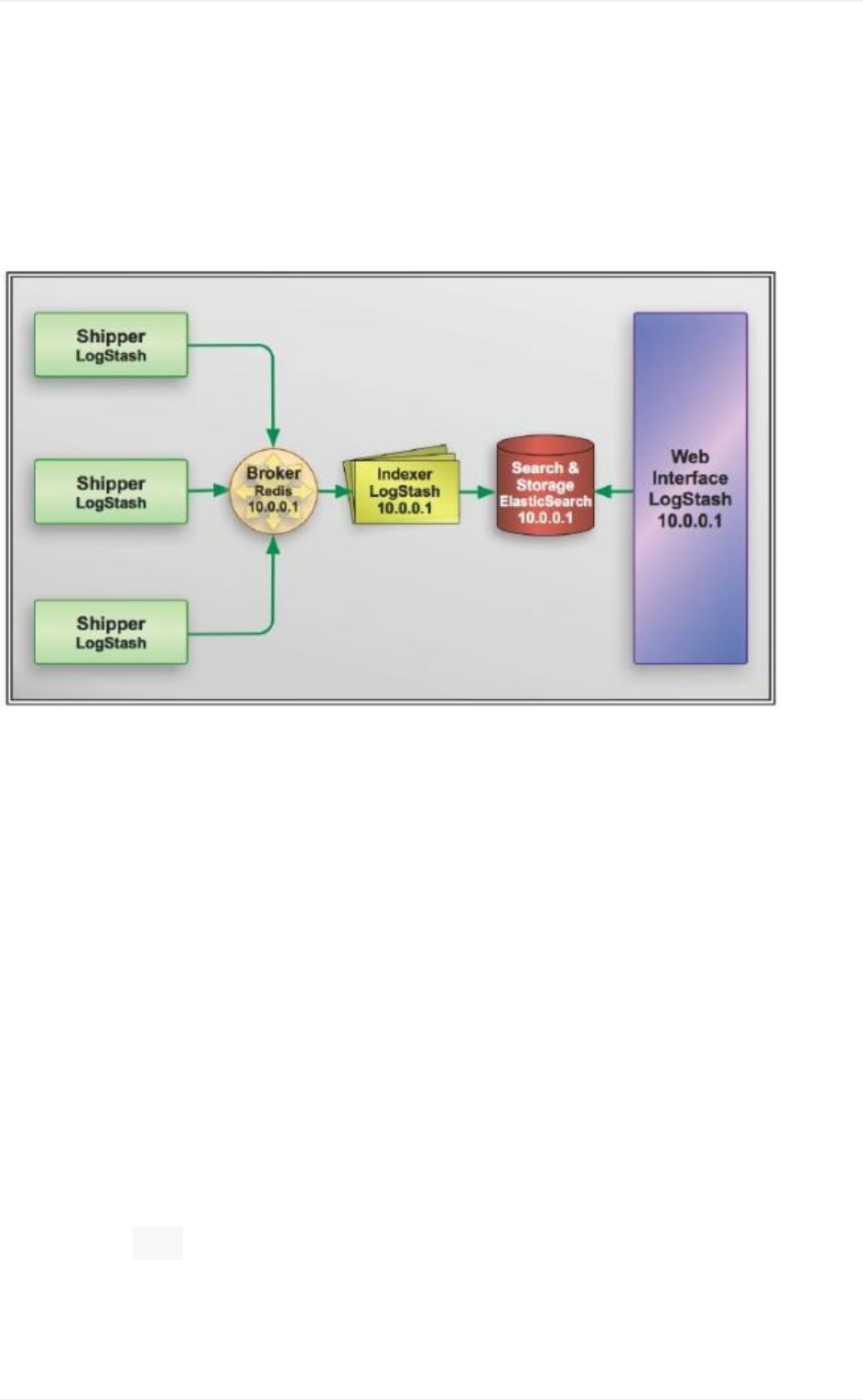

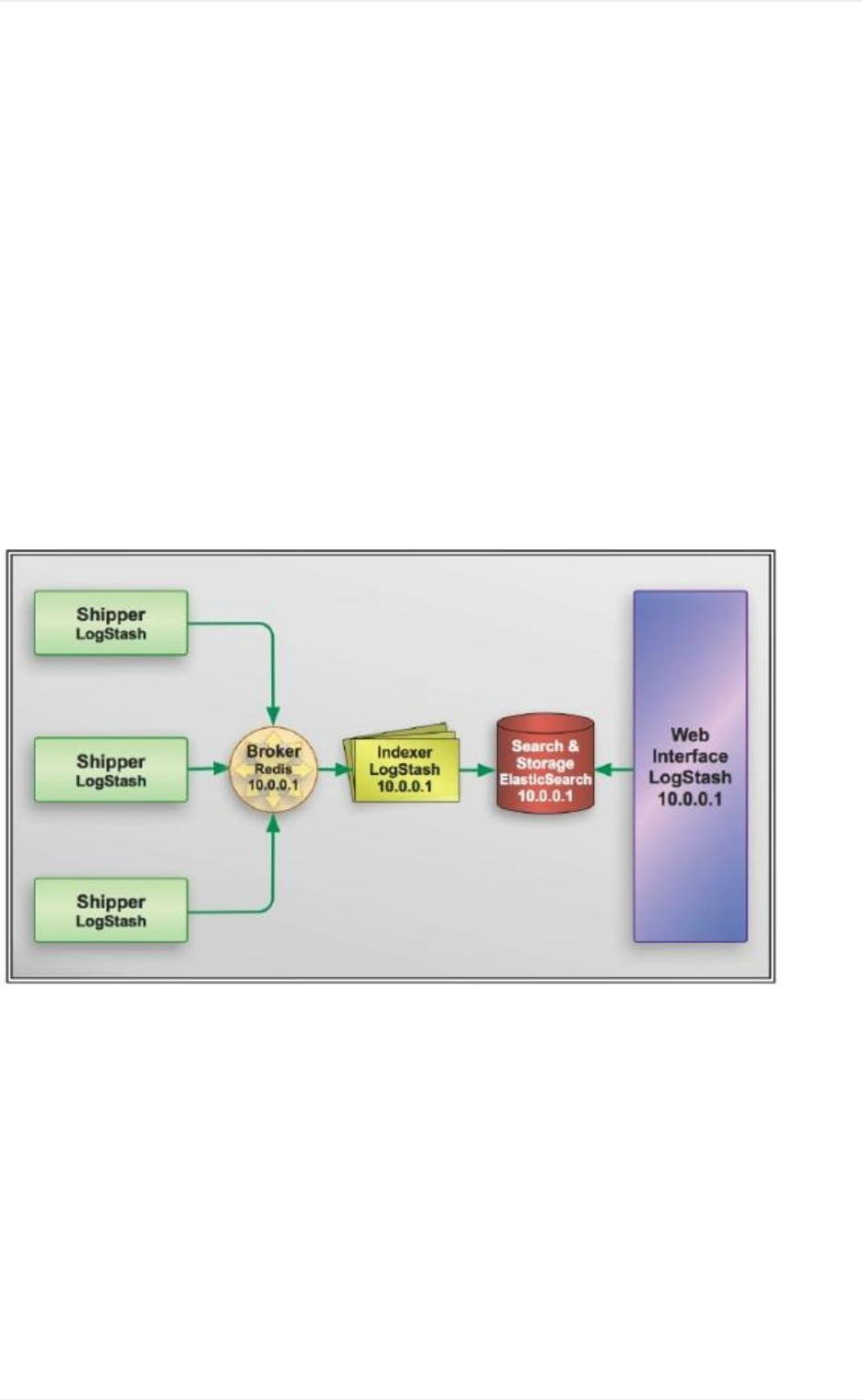

Logstash社区通常习惯用shipper,broker和indexer来描述数据流中不同进程各

自的角色。如下图:

不过我见过很多运用场景里都没有用logstash作为shipper,或者说没有用

elasticsearch作为数据存储也就是说也没有indexer。所以,我们其实不需要这些

概念。只需要学好怎么使用和配置logstash进程,然后把它运用到你的日志管理架

构中最合适它的位置就够了。

语法

Logstash设计了自己的DSL——有点像Puppet的DSL,或许因为都是用Ruby

语言写的吧——包括有区域,注释,数据类型(布尔值,字符串,数值,数组,哈

希),条件判断,字段引用等。

区段(section)

Logstash用{}来定义区域。区域内可以包括插件区域定义,你可以在一个区域

内定义多个插件。插件区域内则可以定义键值对设置。示例如下:

配置语法

19

input{

stdin{}

syslog{}

}

数据类型

Logstash支持少量的数据值类型:

bool

debug=>true

string

host=>"hostname"

number

port=>514

array

match=>["datetime","UNIX","ISO8601"]

hash

options=>{

key1=>"value1",

key2=>"value2"

}

注意:如果你用的版本低于1.2.0,哈希的语法跟数组是一样的,像下面这样写:

配置语法

20

match=>["field1","pattern1","field2","pattern2"]

字段引用(fieldreference)

字段是Logstash::Event对象的属性。我们之前提过事件就像一个哈希一样,

所以你可以想象字段就像一个键值对。

小贴士:我们叫它字段,因为Elasticsearch里是这么叫的。

如果你想在Logstash配置中使用字段的值,只需要把字段的名字写在中括号[]

里就行了,这就叫字段引用。

对于嵌套字段(也就是多维哈希表,或者叫哈希的哈希),每层的字段名都写在[]

里就可以了。比如,你可以从geoip里这样获取longitude值(是的,这是个笨办

法,实际上有单独的字段专门存这个数据的):

[geoip][location][0]

小贴士:logstash的数组也支持倒序下标,即[geoip][location][-1]可以获

取数组最后一个元素的值。

Logstash还支持变量内插,在字符串里使用字段引用的方法是这样:

"thelongitudeis%{[geoip][location][0]}"

条件判断(condition)

Logstash从1.3.0版开始支持条件判断和表达式。

表达式支持下面这些操作符:

==(等于), !=(不等于), <(小于), >(大于), <=(小于等于), >=(大于等

于)

=~(匹配正则), !~(不匹配正则)

in(包含), notin(不包含)

and(与), or(或),nand(非与),xor(非或)

()(复合表达式), !()(对复合表达式结果取反)

配置语法

21

通常来说,你都会在表达式里用到字段引用。为了尽量展示全面各种表达式,下面

虚拟一个示例:

if"_grokparsefailure"notin[tags]{

}elseif[status]!~/^2\d\d/or([url]=="/noc.gif"nand[ge

oip][city]!="beijing"){

}else{

}

命令行参数

Logstash提供了一个shell脚本叫logstash方便快速运行。它支持以下参数:

-e

意即执行。我们在"HelloWorld"的时候已经用过这个参数了。事实上你可以不写

任何具体配置,直接运行bin/logstash-e''达到相同效果。这个参数的默认

值是下面这样:

input{

stdin{}

}

output{

stdout{}

}

--config或-f

意即文件。真实运用中,我们会写很长的配置,甚至可能超过shell所能支持的

1024个字符长度。所以我们必把配置固化到文件里,然后通过bin/logstash-f

agent.conf这样的形式来运行。

此外,logstash还提供一个方便我们规划和书写配置的小功能。你可以直接用

bin/logstash-f/etc/logstash.d/来运行。logstash会自动读取

/etc/logstash.d/目录下所有*.conf的文本文件,然后在自己内存里拼接

成一个完整的大配置文件,再去执行。

注意:

配置语法

22

logstash列出目录下所有文件时,是字母排序的。而logstash配置段的filter和

output都是顺序执行,所以顺序非常重要。采用多文件管理的用户,推荐采用数字

编号方式命名配置文件,同时在配置中,严谨采用if判断限定不同日志的动

作。

--configtest或-t

意即测试。用来测试Logstash读取到的配置文件语法是否能正常解析。Logstash

配置语法是用grammar.treetop定义的。尤其是使用了上一条提到的读取目录方式

的读者,尤其要提前测试。

--log或-l

意即日志。Logstash默认输出日志到标准错误。生产环境下你可以通过

bin/logstash-llogs/logstash.log命令来统一存储日志。

--pipeline-workers或-w

运行filter和output的pipeline线程数量。默认是CPU核数。

--pipeline-batch-size或-b

每个Logstashpipeline线程,在执行具体的filter和output函数之前,最多能累积

的日志条数。默认是125条。越大性能越好,同样也会消耗越多的JVM内存。

--pipeline-batch-delay或-u

每个Logstashpipeline线程,在打包批量日志的时候,最多等待几毫秒。默认是5

ms。

--pluginpath或-P

可以写自己的插件,然后用bin/logstash--pluginpath

/path/to/own/plugins加载它们。

--verbose

输出一定的调试日志。

--debug

输出更多的调试日志。

配置语法

23

设置文件

从Logstash5.0开始,新增了$LS_HOME/config/logstash.yml文件,可以将

所有的命令行参数都通过YAML文件方式设置。同时为了反映命令行配置参数的层

级关系,参数也都改成用.而不是-了。

pipeline:

workers:24

batch:

size:125

delay:5

配置语法

24

plugin的安装

从logstash1.5.0版本开始,logstash将所有的插件都独立拆分成gem包。这样,

每个插件都可以独立更新,不用等待logstash自身做整体更新的时候才能使用了。

为了达到这个目标,logstash配置了专门的plugins管理命令。

plugin用法说明

Usage:

bin/logstash-plugin[OPTIONS]SUBCOMMAND[ARG]...

Parameters:

SUBCOMMANDsubcommand

[ARG]...subcommandarguments

Subcommands:

installInstallaplugin

uninstallUninstallaplugin

updateInstallaplugin

listListallinstalledplugins

Options:

-h,--helpprinthelp

示例

首先,你可以通过bin/logstash-pluginlist查看本机现在有多少插件可

用。(其实就在vendor/bundle/jruby/1.9/gems/目录下)

然后,假如你看到https://github.com/logstash-plugins/下新发布了一个

logstash-output-webhdfs模块(当然目前还没有)。打算试试,就只需要运行:

bin/logstash-plugininstalllogstash-output-webhdfs

plugin的安装

25

就可以了。

同样,假如是升级,只需要运行:

bin/logstash-pluginupdatelogstash-input-tcp

即可。

本地插件安装

bin/logstash-plugin不单可以通过rubygems平台安装插件,还可以读取本

地路径的gem文件。这对自定义插件或者无外接网络的环境都非常有效:

bin/logstash-plugininstall/path/to/logstash-filter-crash.gem

执行成功以后。你会发现,logstash-5.0.0目录下的Gemfile文件最后会多出一段

内容:

gem"logstash-filter-crash","1.1.0",:path=>"vendor/local_gem

s/d354312c/logstash-filter-mweibocrash-1.1.0"

同时Gemfile.jruby-1.9.lock文件开头也会多出一段内容:

PATH

remote:vendor/local_gems/d354312c/logstash-filter-crash-1.1.0

specs:

logstash-filter-crash(1.1.0)

logstash-core(>=1.4.0,<2.0.0)

plugin的安装

26

长期运行

完成上一节的初次运行后,你肯定会发现一点:一旦你按下Ctrl+C,停下标准输入

输出,logstash进程也就随之停止了。作为一个肯定要长期运行的程序,应该怎么

处理呢?

本章节问题对于一个运维来说应该属于基础知识,鉴于ELK用户很多其实不是运

维,添加这段内容。

办法有很多种,下面介绍四种最常用的办法:

标准的service方式

采用RPM、DEB发行包安装的读者,推荐采用这种方式。发行包内,都自带有

sysV或者systemd风格的启动程序/配置,你只需要直接使用即可。

以RPM为例, /etc/init.d/logstash脚本中,会加载

/etc/init.d/functions库文件,利用其中的daemon函数,将logstash进

程作为后台程序运行。

所以,你只需把自己写好的配置文件,统一放在/etc/logstash/conf.d目录下

(注意目录下所有配置文件都应该是.conf结尾,且不能有其他文本文件存在。因为

logstashagent启动的时候是读取全文件夹的),然后运行servicelogstash

start命令即可。

最基础的nohup方式

这是最简单的方式,也是linux新手们很容易搞混淆的一个经典问题:

长期运行

27

command

command>/dev/null

command>/dev/null2>&1

command&

command>/dev/null&

command>/dev/null2>&1&

command&>/dev/null

nohupcommand&>/dev/null

请回答以上命令的异同……

具体不一一解释了。直接说答案,想要维持一个长期后台运行的logstash,你需要

同时在命令前面加nohup,后面加&。

更优雅的SCREEN方式

screen算是linux运维一个中高级技巧。通过screen命令创建的环境下运行的终

端命令,其父进程不是sshd登录会话,而是screen。这样就可以即避免用户退出

进程消失的问题,又随时能重新接管回终端继续操作。

创建独立的screen命令如下:

screen-dmSelkscreen_1

接管连入创建的elkscreen_1命令如下:

screen-relkscreen_1

然后你可以看到一个一模一样的终端,运行logstash之后,不要按Ctrl+C,而是

按Ctrl+A+D键,断开环境。想重新接管,依然screen-relkscreen_1即

可。

如果创建了多个screen,查看列表命令如下:

screen-list

长期运行

28

最推荐的daemontools方式

不管是nohup还是screen,都不是可以很方便管理的方式,在运维管理一个ELK

集群的时候,必须寻找一种尽可能简洁的办法。所以,对于需要长期后台运行的大

量程序(注意大量,如果就一个进程,还是学习一下怎么写init脚本吧),推荐大家

使用一款daemontools工具。

daemontools是一个软件名称,不过配置略复杂。所以这里我其实是用其名称来指

代整个同类产品,包括但不限于python实现的supervisord,perl实现的ubic,

ruby实现的god等。

以supervisord为例,因为这个出来的比较早,可以直接通过EPEL仓库安装。

yum-yinstallsupervisord--enablerepo=epel

在/etc/supervisord.conf配置文件里添加内容,定义你要启动的程序:

[program:elkpro_1]

environment=LS_HEAP_SIZE=5000m

directory=/opt/logstash

command=/opt/logstash/bin/logstash-f/etc/logstash/pro1.conf-w

10-l/var/log/logstash/pro1.log

[program:elkpro_2]

environment=LS_HEAP_SIZE=5000m

directory=/opt/logstash

command=/opt/logstash/bin/logstash-f/etc/logstash/pro2.conf-w

10-l/var/log/logstash/pro2.log

然后启动servicesupervisordstart即可。

logstash会以supervisord子进程的身份运行,你还可以使用supervisorctl命

令,单独控制一系列logstash子进程中某一个进程的启停操作:

supervisorctlstopelkpro_2

长期运行

29

输入插件(Input)

在"HelloWorld"示例中,我们已经见到并介绍了logstash的运行流程和配置的基

础语法。从这章开始,我们就要逐一介绍logstash流程中比较常用的一些插件,并

在介绍中针对其主要适用的场景,推荐的配置,作一些说明。

限于篇幅,接下来内容中,配置示例不一定能贴完整。请记住一个原则:Logstash

配置一定要有一个input和一个output。在演示过程中,如果没有写明input,默认

就会使用"helloworld"里我们已经演示过的input/stdin,同理,没有写明的output

就是output/stdout。

以上请读者自明。

input配置

30

读取文件(File)

分析网站访问日志应该是一个运维工程师最常见的工作了。所以我们先学习一下怎

么用logstash来处理日志文件。

Logstash使用一个名叫FileWatch的RubyGem库来监听文件变化。这个库支持

glob展开文件路径,而且会记录一个叫.sincedb的数据库文件来跟踪被监听的日

志文件的当前读取位置。所以,不要担心logstash会漏过你的数据。

sincedb文件中记录了每个被监听的文件的inode,majornumber,minornumber和

pos。

配置示例

input{

file{

path=>["/var/log/*.log","/var/log/message"]

type=>"system"

start_position=>"beginning"

}

}

解释

有一些比较有用的配置项,可以用来指定FileWatch库的行为:

discover_interval

logstash每隔多久去检查一次被监听的path下是否有新文件。默认值是15

秒。

exclude

不想被监听的文件可以排除出去,这里跟path一样支持glob展开。

close_older

input配置

31

一个已经监听中的文件,如果超过这个值的时间内没有更新内容,就关闭监听它的

文件句柄。默认是3600秒,即一小时。

ignore_older

在每次检查文件列表的时候,如果一个文件的最后修改时间超过这个值,就忽略这

个文件。默认是86400秒,即一天。

sincedb_path

如果你不想用默认的$HOME/.sincedb(Windows平台上在

C:\Windows\System32\config\systemprofile\.sincedb),可以通过这个配

置定义sincedb文件到其他位置。

sincedb_write_interval

logstash每隔多久写一次sincedb文件,默认是15秒。

stat_interval

logstash每隔多久检查一次被监听文件状态(是否有更新),默认是1秒。

start_position

logstash从什么位置开始读取文件数据,默认是结束位置,也就是说logstash进程

会以类似tail-F的形式运行。如果你是要导入原有数据,把这个设定改成

"beginning",logstash进程就从头开始读取,类似less+F的形式运行。

注意

1. 通常你要导入原有数据进Elasticsearch的话,你还需要filter/date插件来修改

默认的"@timestamp"字段值。稍后会学习这方面的知识。

2. FileWatch只支持文件的绝对路径,而且会不自动递归目录。所以有需要的

话,请用数组方式都写明具体哪些文件。

3. LogStash::Inputs::File只是在进程运行的注册阶段初始化一个FileWatch对

象。所以它不能支持类似fluentd那样的path=>"/path/to/%

{+yyyy/MM/dd/hh}.log"写法。达到相同目的,你只能写成path=>

"/path/to/*/*/*/*.log"。FileWatch模块提供了一个稍微简单一点的写

法: /path/to/**/*.log,用**来缩写表示递归全部子目录。

4. start_position仅在该文件从未被监听过的时候起作用。如果sincedb文

input配置

32

标准输入(Stdin)

我们已经见过好几个示例使用stdin了。这也应该是logstash里最简单和基础

的插件了。

所以,在这段中,我们可以学到一些未来每个插件都会有的一些方法。

配置示例

input{

stdin{

add_field=>{"key"=>"value"}

codec=>"plain"

tags=>["add"]

type=>"std"

}

}

运行结果

用上面的新stdin设置重新运行一次最开始的helloworld示例。我建议大家把

整段配置都写入一个文本文件,然后运行命令: bin/logstash-f

stdin.conf。输入"helloworld"并回车后,你会在终端看到如下输出:

input配置

34

{

"message"=>"helloworld",

"@version"=>"1",

"@timestamp"=>"2014-08-08T06:48:47.789Z",

"type"=>"std",

"tags"=>[

[0]"add"

],

"key"=>"value",

"host"=>"raochenlindeMacBook-Air.local"

}

解释

type和tags是logstash事件中两个特殊的字段。通常来说我们会在输入区段中通

过type来标记事件类型——我们肯定是提前能知道这个事件属于什么类型的。而

tags则是在数据处理过程中,由具体的插件来添加或者删除的。

最常见的用法是像下面这样:

input配置

35

input{

stdin{

type=>"web"

}

}

filter{

if[type]=="web"{

grok{

match=>["message",%{COMBINEDAPACHELOG}]

}

}

}

output{

if"_grokparsefailure"in[tags]{

nagios_nsca{

nagios_status=>"1"

}

}else{

elasticsearch{

}

}

}

看起来蛮复杂的,对吧?

继续学习,你也可以写出来的。

input配置

36

读取Syslog数据

syslog可能是运维领域最流行的数据传输协议了。当你想从设备上收集系统日志的

时候,syslog应该会是你的第一选择。尤其是网络设备,比如思科——syslog几

乎是唯一可行的办法。

我们这里不解释如何配置你的syslog.conf, rsyslog.conf或者syslog-

ng.conf来发送数据,而只讲如何把logstash配置成一个syslog服务器来接收数

据。

有关rsyslog的用法,稍后的类型项目一节中,会有更详细的介绍。

配置示例

input{

syslog{

port=>"514"

}

}

运行结果

作为最简单的测试,我们先暂停一下本机的syslogd(或rsyslogd)进程,然

后启动logstash进程(这样就不会有端口冲突问题)。现在,本机的syslog就会

默认发送到logstash里了。我们可以用自带的logger命令行工具发送一条

"HelloWorld"信息到syslog里(即logstash里)。看到的logstash输出像下面这

样:

input配置

37

{

"message"=>"HelloWorld",

"@version"=>"1",

"@timestamp"=>"2014-08-08T09:01:15.911Z",

"host"=>"127.0.0.1",

"priority"=>31,

"timestamp"=>"Aug817:01:15",

"logsource"=>"raochenlindeMacBook-Air.local",

"program"=>"com.apple.metadata.mdflagwriter",

"pid"=>"381",

"severity"=>7,

"facility"=>3,

"facility_label"=>"system",

"severity_label"=>"Debug"

}

解释

Logstash是用UDPSocket, TCPServer和LogStash::Filters::Grok来实

现LogStash::Inputs::Syslog的。所以你其实可以直接用logstash配置实现

一样的效果:

input{

tcp{

port=>"8514"

}

}

filter{

grok{

match=>["message","%{SYSLOGLINE}"]

}

syslog_pri{}

}

最佳实践

input配置

38

建议在使用LogStash::Inputs::Syslog的时候走TCP协议来传输数据。

因为具体实现中,UDP监听器只用了一个线程,而TCP监听器会在接收每个连接

的时候都启动新的线程来处理后续步骤。

如果你已经在使用UDP监听器收集日志,用下行命令检查你的UDP接收队列大

小:

#netstat-plnu|awk'NR==1||$4~/:514$/{print$2}'

Recv-Q

228096

228096是UDP接收队列的默认最大大小,这时候linux内核开始丢弃数据包了!

强烈建议使用 LogStash::Inputs::TCP和LogStash::Filters::Grok配合实

现同样的syslog功能!

虽然LogStash::Inputs::Syslog在使用TCPServer的时候可以采用多线程处理数据

的接收,但是在同一个客户端数据的处理中,其grok和date是一直在该线程中完

成的,这会导致总体上的处理性能几何级的下降——经过测试,TCPServer每秒

可以接收50000条数据,而在同一线程中启用grok后每秒只能处理5000条,再

加上date只能达到500条!

才将这两步拆分到filters阶段后,logstash支持对该阶段插件单独设置多线程运

行,大大提高了总体处理性能。在相同环境下,logstash-ftcp.conf-w20

的测试中,总体处理性能可以达到每秒30000条数据!

注:测试采用logstash作者提供的yes"<44>May1918:30:17snackjls:

foobar32"|nclocalhost3000命令。出处

见:https://github.com/jordansissel/experiments/blob/master/ruby/jruby-

netty/syslog-server/Makefile

小贴士

如果你实在没法切换到TCP协议,你可以自己写程序,或者使用其他基于异步IO

框架(比如libev)的项目。下面是一个简单的异步IO实现UDP监听数据输入

Elasticsearch的示例:

https://gist.github.com/chenryn/7c922ac424324ee0d695

input配置

39

input配置

40

读取网络数据(TCP)

未来你可能会用Redis服务器或者其他的消息队列系统来作为logstashbroker的

角色。不过Logstash其实也有自己的TCP/UDP插件,在临时任务的时候,也算

能用,尤其是测试环境。

小贴士:虽然LogStash::Inputs::TCP用Ruby的Socket和OpenSSL库

实现了高级的SSL功能,但Logstash本身只能在SizedQueue中缓存20个事

件。这就是我们建议在生产环境中换用其他消息队列的原因。

配置示例

input{

tcp{

port=>8888

mode=>"server"

ssl_enable=>false

}

}

常见场景

目前来看, LogStash::Inputs::TCP最常见的用法就是配合nc命令导入旧数

据。在启动logstash进程后,在另一个终端运行如下命令即可导入数据:

#nc127.0.0.18888<olddata

这种做法比用LogStash::Inputs::File好,因为当nc命令结束,我们就知道

数据导入完毕了。而用input/file方式,logstash进程还会一直等待新数据输入被监

听的文件,不能直接看出是否任务完成了。

input配置

41

编码插件(Codec)

Codec是logstash从1.3.0版开始新引入的概念(Codec来自Coder/decoder两个

单词的首字母缩写)。

在此之前,logstash只支持纯文本形式输入,然后以过滤器处理它。但现在,我们

可以在输入期处理不同类型的数据,这全是因为有了codec设置。

所以,这里需要纠正之前的一个概念。Logstash不只是一个 input|filter|

output的数据流,而是一个input|decode|filter|encode|output

的数据流!codec就是用来decode、encode事件的。

codec的引入,使得logstash可以更好更方便的与其他有自定义数据格式的运维产

品共存,比如graphite、fluent、netflow、collectd,以及使用msgpack、json、

edn等通用数据格式的其他产品等。

事实上,我们在第一个"helloworld"用例中就已经用过codec了——rubydebug

就是一种codec!虽然它一般只会用在stdout插件中,作为配置测试或者调试的工

具。

小贴士:这个五段式的流程说明源自Perl版的Logstash(后来改名叫

Message::Passing模块)的设计。本书最后会对该模块稍作介绍。

codec配置

42

采用JSON编码

在早期的版本中,有一种降低logstash过滤器的CPU负载消耗的做法盛行于社区

(在当时的cookbook上有专门的一节介绍):直接输入预定义好的JSON数据,这

样就可以省略掉filter/grok配置!

这个建议依然有效,不过在当前版本中需要稍微做一点配置变动——因为现在有

专门的codec设置。

配置示例

社区常见的示例都是用的Apache的customlog。不过我觉得Nginx是一个比

Apache更常用的新型web服务器,所以我这里会用nginx.conf做示例:

logformatjson'{"@timestamp":"$time_iso8601",'

'"@version":"1",'

'"host":"$server_addr",'

'"client":"$remote_addr",'

'"size":$body_bytes_sent,'

'"responsetime":$request_time,'

'"domain":"$host",'

'"url":"$uri",'

'"status":"$status"}';

access_log/var/log/nginx/access.log_jsonjson;

注意:在$request_time和$body_bytes_sent变量两头没有双引号",

这两个数据在JSON里应该是数值类型!

重启nginx应用,然后修改你的input/file区段配置成下面这样:

input{

file{

path=>"/var/log/nginx/access.log_json"

codec=>"json"

}

}

codec配置

43

运行结果

下面访问一下你nginx发布的web页面,然后你会看到logstash进程输出类似下

面这样的内容:

{

"@timestamp"=>"2014-03-21T18:52:25.000+08:00",

"@version"=>"1",

"host"=>"raochenlindeMacBook-Air.local",

"client"=>"123.125.74.53",

"size"=>8096,

"responsetime"=>0.04,

"domain"=>"www.domain.com",

"url"=>"/path/to/file.suffix",

"status"=>"200"

}

小贴士

对于一个web服务器的访问日志,看起来已经可以很好的工作了。不过如果Nginx

是作为一个代理服务器运行的话,访问日志里有些变量,比如说

$upstream_response_time,可能不会一直是数字,它也可能是一个"-"字

符串!这会直接导致logstash对输入数据验证报异常。

有两个办法解决这个问题:

1. 用sed在输入之前先替换-成0。

运行logstash进程时不再读取文件而是标准输入,这样命令就成了下面这个样子:

tail-F/var/log/nginx/proxy_access.log_json\

|sed's/upstreamtime":-/upstreamtime":0/'\

|/usr/local/logstash/bin/logstash-f/usr/local/logstash/et

c/proxylog.conf

1. 日志格式中统一记录为字符串格式(即都带上双引号"),然后再在logstash

中用filter/mutate插件来变更应该是数值类型的字符字段的值类型。

codec配置

44

有关LogStash::Filters::Mutate的内容,本书稍后会有介绍。

codec配置

45

合并多行数据(Multiline)

有些时候,应用程序调试日志会包含非常丰富的内容,为一个事件打印出很多行内

容。这种日志通常都很难通过命令行解析的方式做分析。

而logstash正为此准备好了codec/multiline插件!

小贴士:multiline插件也可以用于其他类似的堆栈式信息,比如linux的内核日

志。

配置示例

input{

stdin{

codec=>multiline{

pattern=>"^\["

negate=>true

what=>"previous"

}

}

}

运行结果

运行logstash进程,然后在等待输入的终端中输入如下几行数据:

[Aug/08/0814:54:03]helloworld

[Aug/08/0914:54:04]hellologstash

hellobestpractice

helloraochenlin

[Aug/08/1014:54:05]theend

你会发现logstash输出下面这样的返回:

codec配置

46

{

"@timestamp"=>"2014-08-09T13:32:03.368Z",

"message"=>"[Aug/08/0814:54:03]helloworld\n",

"@version"=>"1",

"host"=>"raochenlindeMacBook-Air.local"

}

{

"@timestamp"=>"2014-08-09T13:32:24.359Z",

"message"=>"[Aug/08/0914:54:04]hellologstash\n\n

hellobestpractice\n\nhelloraochenlin\n",

"@version"=>"1",

"tags"=>[

[0]"multiline"

],

"host"=>"raochenlindeMacBook-Air.local"

}

你看,后面这个事件,在"message"字段里存储了三行数据!

小贴士:你可能注意到输出的事件中都没有最后的"theend"字符串。这是因为你最

后输入的回车符\n并不匹配设定的^\[正则表达式,logstash还得等下一行

数据直到匹配成功后才会输出这个事件。

解释

其实这个插件的原理很简单,就是把当前行的数据添加到前面一行后面,,直到新

进的当前行匹配^\[正则为止。

这个正则还可以用grok表达式,稍后你就会学习这方面的内容。

Log4J的另一种方案

说到应用程序日志,log4j肯定是第一个被大家想到的。使用codec/multiline

也确实是一个办法。

codec配置

47

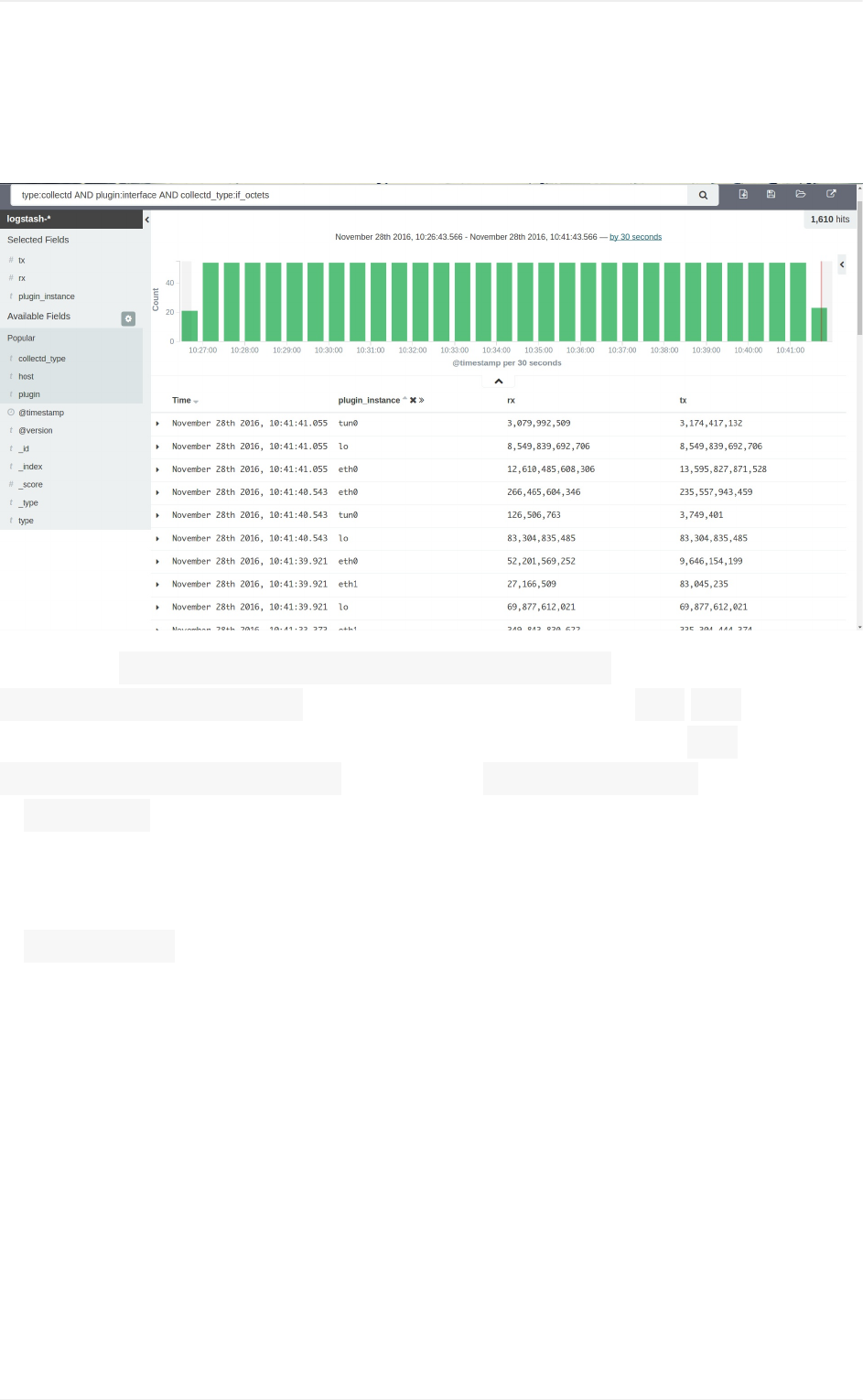

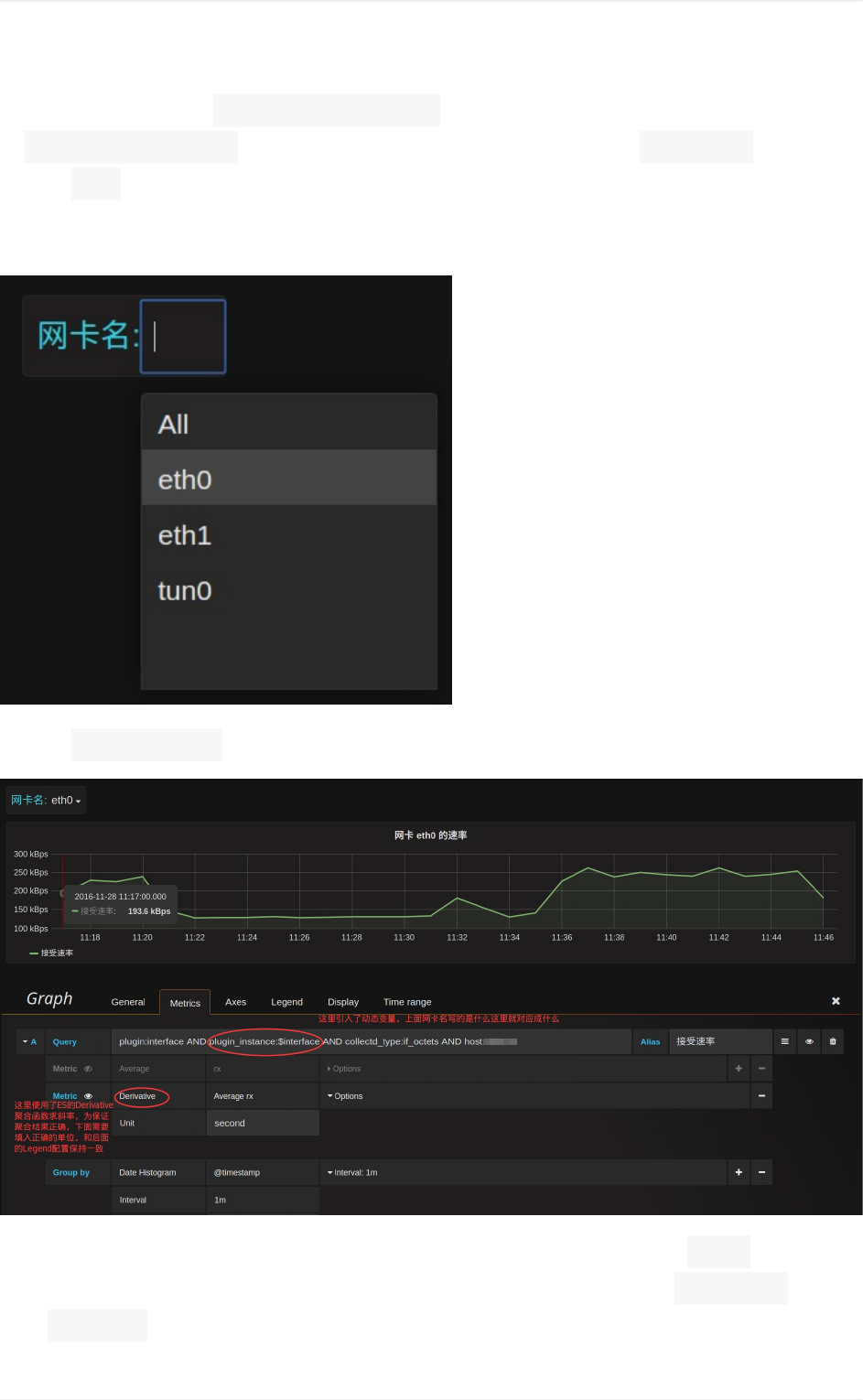

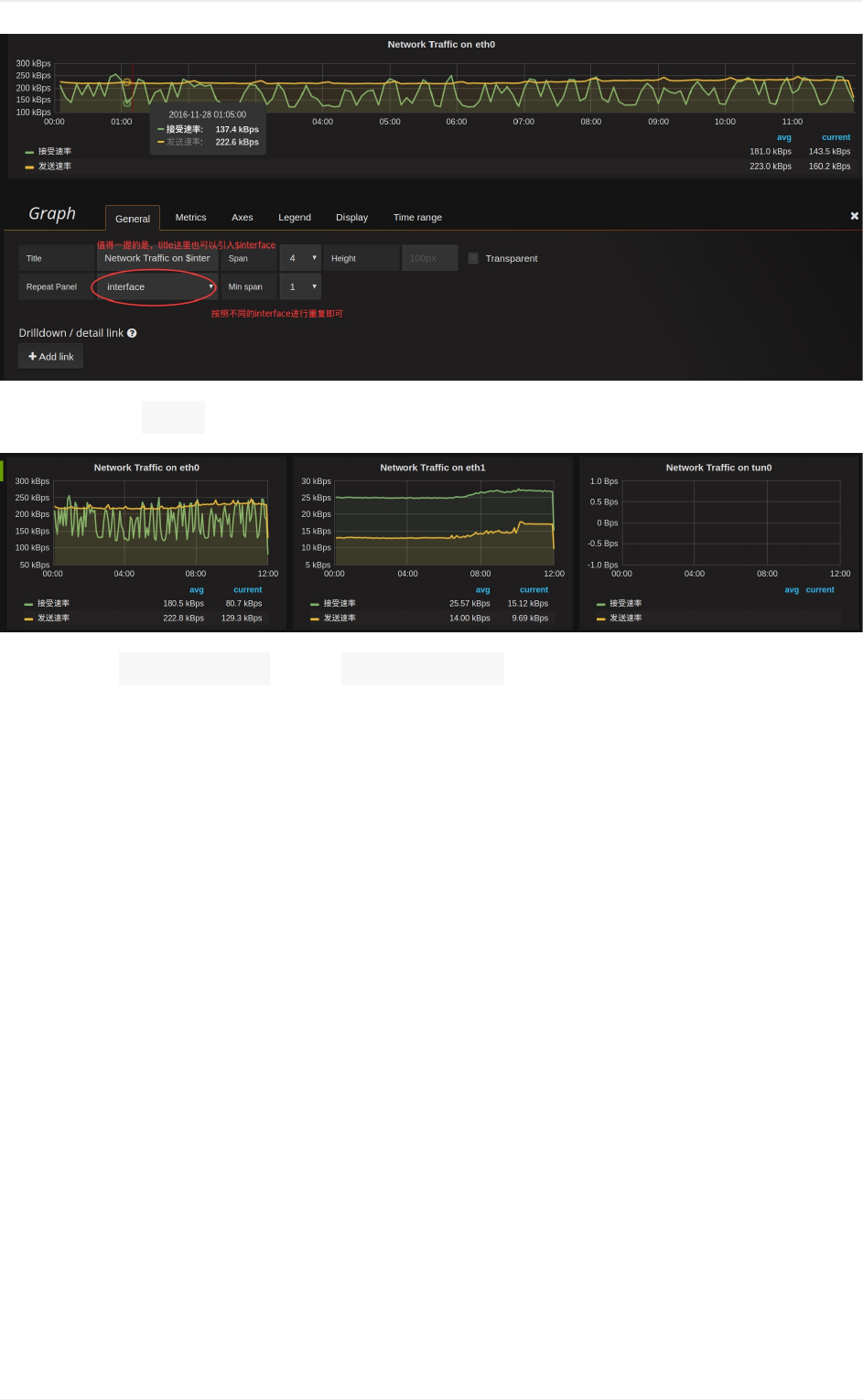

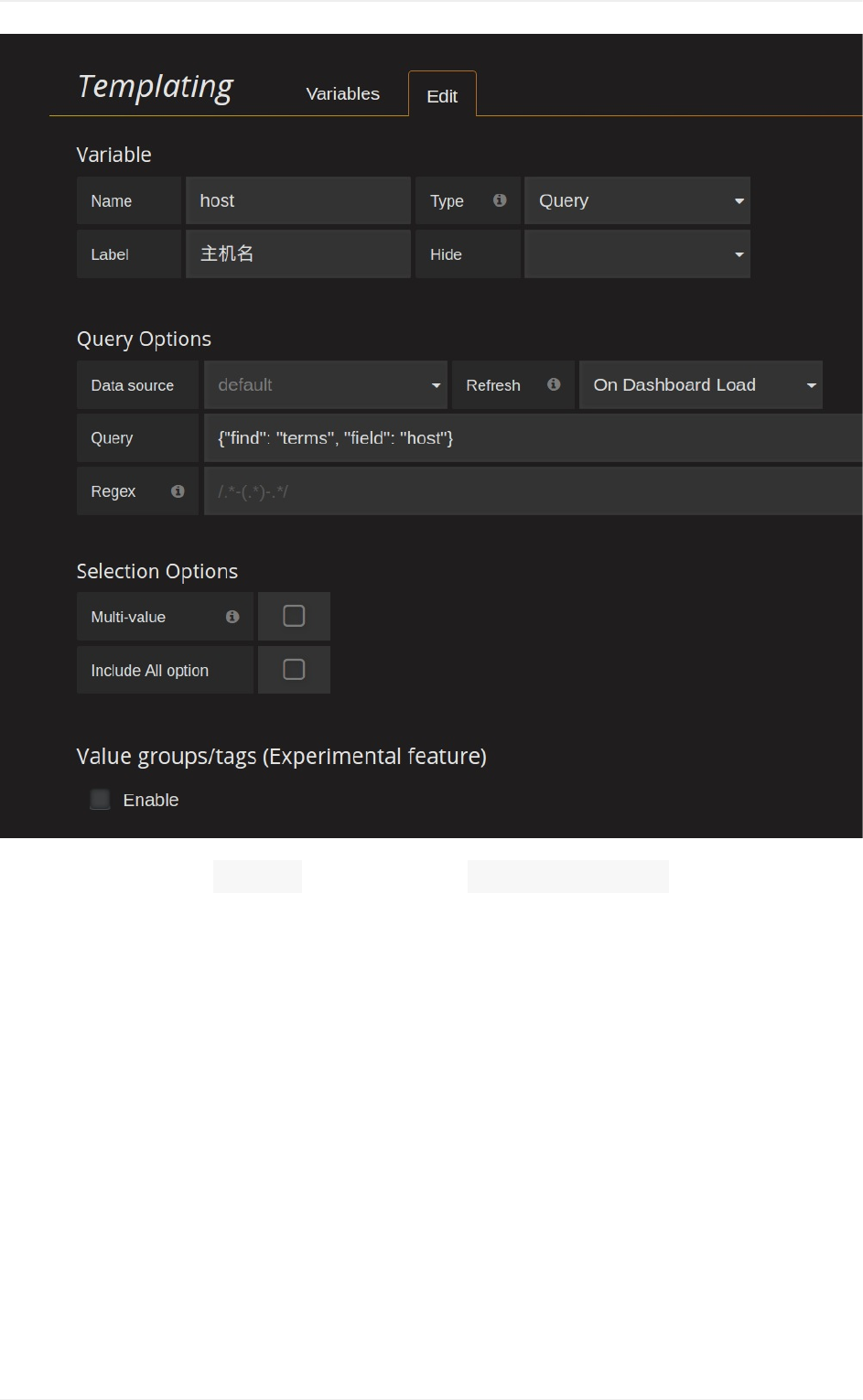

collectd简述

本节作者:crazw

collectd是一个守护(daemon)进程,用来收集系统性能和提供各种存储方式来存储

不同值的机制。它会在系统运行和存储信息时周期性的统计系统的相关统计信息。

利用这些信息有助于查找当前系统性能瓶颈(如作为性能分析performance

analysis)和预测系统未来的load(如能力部署 capacityplanning)等

下面简单介绍一下:collectd的部署以及与logstash对接的相关配置实例

collectd的安装

软件仓库安装(推荐)

collectd官方有一个的软件仓库:https://pkg.ci.collectd.org,构建

有RHEL/CentOS(rpm),Debian/Ubuntu(deb)的软件包,如果你使用的操作系

统属于上述,那么推荐使用软件仓库安装。

目前collectd官方维护3个版本: 5.4, 5.5, 5.6。根据需要选择合适的版本。

Debian/Ubuntu仓库安装(示例中使用 5.5版本):

echo"debhttp://pkg.ci.collectd.org/deb$(lsb_release-sc)coll

ectd-5.5"|sudotee/etc/apt/sources.list.d/collectd.list

curl-shttps://pkg.ci.collectd.org/pubkey.asc|sudoapt-keyad

d-

sudoapt-getupdate&&sudoapt-getinstall-ycollectd

NOTE:Debian/Ubuntu软件仓库自带有 collectd软件包,如果软件仓库自带

的版本足够你使用,那么可以不用添加仓库,直接通过 apt-getinstall

collectd即可。

RHEL/CentOS仓库安装(示例中使用 5.5版本):

codec配置

49

cat>/etc/yum.repos.d/collectd.repo<<EOF

[collectd-5.5]

name=collectd-5.5

baseurl=http://pkg.ci.collectd.org/rpm/collectd-5.5/epel-\$relea

sever-\$basearch/

gpgcheck=1

gpgkey=http://pkg.ci.collectd.org/pubkey.asc

EOF

yuminstall-ycollectd

#其他collectd插件需要安装对应的collectd-xxxx软件包

源码安装collectd

#collectd目前维护3个版本,5.4,5.5,5.6。根据自己需要选择版本

wgethttp://collectd.org/files/collectd-5.4.1.tar.gz

tarzxvfcollectd-5.4.1.tar.gz

cdcollectd-5.4.1

./configure--prefix=/usr--sysconfdir=/etc--localstatedir=/var

--libdir=/usr/lib--mandir=/usr/share/man--enable-all-plugins

make&&makeinstall

解决依赖(RH系列):

rpm-ivh"http://dl.fedoraproject.org/pub/epel/6/i386/epel-relea

se-6-8.noarch.rpm"

yum-yinstalllibcurllibcurl-develrrdtoolrrdtool-develperl-

rrdtoolrrdtool-perllibgcrypt-develgccmakegcc-c++libopingl

iboping-develperl-CPANnet-snmpnet-snmp-devel

安装启动脚本

cpcontrib/redhat/init.d-collectd/etc/init.d/collectd

chmod+x/etc/init.d/collectd

codec配置

50

启动collectd

servicecollectdstart

collectd的配置

以下配置可以实现对服务器基本的CPU、内存、网卡流量、磁盘IO以及磁盘空间

占用情况的监控:

Hostname"host.example.com"

LoadPlugininterface

LoadPlugincpu

LoadPluginmemory

LoadPluginnetwork

LoadPlugindf

LoadPlugindisk

<Plugininterface>

Interface"eth0"

IgnoreSelectedfalse

</Plugin>

<Pluginnetwork>

#logstash的IP地址和collectd的数据接收端口号>

#如果logstash和collectd在同一台主机上也可以用环回地址127.0.0.1

<Server"10.0.0.1""25826">

</Server>

</Plugin>

logstash的配置

以下配置实现通过logstash监听25826端口,接收从collectd发送过来的各项

检测数据。

logstash默认自带有 collectd的codec插件,详见官方文档:

https://www.elastic.co/guide/en/logstash/current/plugins-codecs-collectd.html

示例:

codec配置

51

input{

udp{

port=>25826

buffer_size=>1452

workers=>3#Defaultis2

queue_size=>30000#Defaultis2000

codec=>collectd{}

type=>"collectd"

}

}

运行结果

下面是简单的一个输出结果:

codec配置

52

{

"_index":"logstash-2014.12.11",

"_type":"collectd",

"_id":"dS6vVz4aRtK5xS86kwjZnw",

"_score":null,

"_source":{

"host":"host.example.com",

"@timestamp":"2014-12-11T06:28:52.118Z",

"plugin":"interface",

"plugin_instance":"eth0",

"collectd_type":"if_packets",

"rx":19147144,

"tx":3608629,

"@version":"1",

"type":"collectd",

"tags":[

"_grokparsefailure"

]

},

"sort":[

1418279332118

]

}

参考资料

collectd支持收集的数据类型:http://git.verplant.org/?

p=collectd.git;a=blob;hb=master;f=README

collectd收集各数据类型的配置参考资料:

http://collectd.org/documentation/manpages/collectd.conf.5.shtml

collectd简单配置文件示例:

https://gist.github.com/untergeek/ab85cb86a9bf39f1fc6d

codec配置

53

netflow

input{

udp{

port=>9995

codec=>netflow{

definitions=>"/home/administrator/logstash-1.4.2/lib/l

ogstash/codecs/netflow/netflow.yaml"

versions=>[5]

}

}

}

output{

stdout{codec=>rubydebug}

if([host]=~"10\.1\.1[12]\.1"){

elasticsearch{

index=>"logstash_netflow5-%{+YYYY.MM.dd}"

host=>"localhost"

}

}else{

elasticsearch{

index=>"logstash-%{+YYYY.MM.dd}"

host=>"localhost"

}

}

}

curl-XPUTlocalhost:9200/_template/logstash_netflow5-d'{

"template":"logstash_netflow5-*",

"settings":{

"index.refresh_interval":"5s"

},

"mappings":{

"_default_":{

"_all":{"enabled":false},

codec配置

54

"properties":{

"@version":{"index":"analyzed","type":"integer"}

,

"@timestamp":{"index":"analyzed","type":"date"},

"netflow":{

"dynamic":true,

"type":"object",

"properties":{

"version":{"index":"analyzed","type":"integer

"},

"flow_seq_num":{"index":"not_analyzed","type":

"long"},

"engine_type":{"index":"not_analyzed","type":

"integer"},

"engine_id":{"index":"not_analyzed","type":"i

nteger"},

"sampling_algorithm":{"index":"not_analyzed","

type":"integer"},

"sampling_interval":{"index":"not_analyzed","t

ype":"integer"},

"flow_records":{"index":"not_analyzed","type":

"integer"},

"ipv4_src_addr":{"index":"analyzed","type":"i

p"},

"ipv4_dst_addr":{"index":"analyzed","type":"i

p"},

"ipv4_next_hop":{"index":"analyzed","type":"i

p"},

"input_snmp":{"index":"not_analyzed","type":"

long"},

"output_snmp":{"index":"not_analyzed","type":

"long"},

"in_pkts":{"index":"analyzed","type":"long"}

,

"in_bytes":{"index":"analyzed","type":"long"

},

"first_switched":{"index":"not_analyzed","type

":"date"},

"last_switched":{"index":"not_analyzed","type"

:"date"},

codec配置

55

"l4_src_port":{"index":"analyzed","type":"lon

g"},

"l4_dst_port":{"index":"analyzed","type":"lon

g"},

"tcp_flags":{"index":"analyzed","type":"integ

er"},

"protocol":{"index":"analyzed","type":"intege

r"},

"src_tos":{"index":"analyzed","type":"integer

"},

"src_as":{"index":"analyzed","type":"integer"

},

"dst_as":{"index":"analyzed","type":"integer"

},

"src_mask":{"index":"analyzed","type":"intege

r"},

"dst_mask":{"index":"analyzed","type":"intege

r"}

}

}

}

}

}

}'

codec配置

56

过滤器插件(Filter)

丰富的过滤器插件的存在是logstash威力如此强大的重要因素。名为过滤器,其实

提供的不单单是过滤的功能。在本章我们就会重点介绍几个插件,它们扩展了进入

过滤器的原始数据,进行复杂的逻辑处理,甚至可以无中生有的添加新的logstash

事件到后续的流程中去!

filter配置

57

时间处理(Date)

之前章节已经提过,filters/date插件可以用来转换你的日志记录中的时间字符串,

变成LogStash::Timestamp对象,然后转存到@timestamp字段里。

注意:因为在稍后的outputs/elasticsearch中常用的%{+YYYY.MM.dd}这种写

法必须读取@timestamp数据,所以一定不要直接删掉这个字段保留自己的字

段,而是应该用filters/date转换后删除自己的字段!

这在导入旧数据的时候固然非常有用,而在实时数据处理的时候同样有效,因为一

般情况下数据流程中我们都会有缓冲区,导致最终的实际处理时间跟事件产生时间

略有偏差。

小贴士:个人强烈建议打开Nginx的access_log配置项的buffer参数,对极限响

应性能有极大提升!

配置示例

filters/date插件支持五种时间格式:

ISO8601

类似"2011-04-19T03:44:01.103Z"这样的格式。具体Z后面可以有"08:00"也可以

没有,".103"这个也可以没有。常用场景里来说,Nginx的log_format配置里就可

以使用$time_iso8601变量来记录请求时间成这种格式。

UNIX

UNIX时间戳格式,记录的是从1970年起始至今的总秒数。Squid的默认日志格式

中就使用了这种格式。

UNIX_MS

这个时间戳则是从1970年起始至今的总毫秒数。据我所知,JavaScript里经常使

用这个时间格式。

filter配置

58

TAI64N

TAI64N格式比较少见,是这个样子的: @4000000052f88ea32489532c。我目前

只知道常见应用中,qmail会用这个格式。

Joda-Time库

Logstash内部使用了Java的Joda时间库来作时间处理。所以我们可以使用Joda

库所支持的时间格式来作具体定义。Joda时间格式定义见下表:

时间格式

filter配置

59

Symbol Meaning Presentation Examples

G era text AD

C centuryofera(>=0) number 20

Y yearofera(>=0) year 1996

x weekyear year 1996

w weekofweekyear number 27

e dayofweek number 2

E dayofweek text Tuesday;Tue

y year year 1996

D dayofyear number 189

M monthofyear month July;Jul;07

d dayofmonth number 10

a halfdayofday text PM

Khourofhalfday

(0~11) number 0

hclockhourofhalfday

(1~12) number 12

H hourofday(0~23) number 0

kclockhourofday

(1~24) number 24

m minuteofhour number 30

s secondofminute number 55

S fractionofsecond number 978

z timezone text PacificStandardTime;

PST

Z timezoneoffset/id zone -0800;-08:00;

America/Los_Angeles

' escapefortext delimiter

'' singlequote literal '

http://joda-

time.sourceforge.net/apidocs/org/joda/time/format/DateTimeFormat.html

filter配置

60

下面我们写一个Joda时间格式的配置作为示例:

filter{

grok{

match=>["message","%{HTTPDATE:logdate}"]

}

date{

match=>["logdate","dd/MMM/yyyy:HH:mm:ssZ"]

}

}

注意:时区偏移量只需要用一个字母Z即可。

时区问题的解释

很多中国用户经常提一个问题:为什么@timestamp比我们晚了8个小时?怎么修

改成北京时间?

其实,Elasticsearch内部,对时间类型字段,是统一采用UTC时间,存成long

长整形数据的!对日志统一采用UTC时间存储,是国际安全/运维界的一个通识

——欧美公司的服务器普遍广泛分布在多个时区里——不像中国,地域横跨五个时

区却只用北京时间。

对于页面查看,ELK的解决方案是在Kibana上,读取浏览器的当前时区,然后在

页面上转换时间内容的显示。

所以,建议大家接受这种设定。否则,即便你用.getLocalTime修改,也还要

面临在Kibana上反过去修改,以及Elasticsearch原有的["now-1h"TO

"now"]这种方便的搜索语句无法正常使用的尴尬。

以上,请读者自行斟酌。

filter配置

61

Grok正则捕获

Grok是Logstash最重要的插件。你可以在grok里预定义好命名正则表达式,在

稍后(grok参数或者其他正则表达式里)引用它。

正则表达式语法

运维工程师多多少少都会一点正则。你可以在grok里写标准的正则,像下面这

样:

\s+(?<request_time>\d+(?:\.\d+)?)\s+

小贴士:这个正则表达式写法对于Perl或者Ruby程序员应该很熟悉了,Python

程序员可能更习惯写(?P<name>pattern),没办法,适应一下吧。

现在给我们的配置文件添加第一个过滤器区段配置。配置要添加在输入和输出区段

之间(logstash执行区段的时候并不依赖于次序,不过为了自己看得方便,还是按次

序书写吧):

input{stdin{}}

filter{

grok{

match=>{

"message"=>"\s+(?<request_time>\d+(?:\.\d+)?)\s+"

}

}

}

output{stdout{codec=>rubydebug}}

运行logstash进程然后输入"begin123.456end",你会看到类似下面这样的输

出:

filter配置

62

{

"message"=>"begin123.456end",

"@version"=>"1",

"@timestamp"=>"2014-08-09T11:55:38.186Z",

"host"=>"raochenlindeMacBook-Air.local",

"request_time"=>"123.456"

}

漂亮!不过数据类型好像不太满意……request_time应该是数值而不是字符串。

我们已经提过稍后会学习用LogStash::Filters::Mutate来转换字段值类型,

不过在grok里,其实有自己的魔法来实现这个功能!

Grok表达式语法

Grok支持把预定义的grok表达式写入到文件中,官方提供的预定义grok表达式

见:https://github.com/logstash-plugins/logstash-patterns-

core/tree/master/patterns。

注意:在新版本的logstash里面,pattern目录已经为空,最后一个commit提示

corepatterns将会由logstash-patterns-coregem来提供,该目录可供用户存放

自定义patterns

下面是从官方文件中摘抄的最简单但是足够说明用法的示例:

USERNAME[a-zA-Z0-9._-]+

USER%{USERNAME}

第一行,用普通的正则表达式来定义一个grok表达式;第二行,通过打印赋值格

式(sprintfformat),用前面定义好的grok表达式来定义另一个grok表达式。

grok表达式的打印赋值格式的完整语法是下面这样的:

%{PATTERN_NAME:capture_name:data_type}

小贴士:data_type目前只支持两个值: int和float。

filter配置

63

所以我们可以改进我们的配置成下面这样:

filter{

grok{

match=>{

"message"=>"%{WORD}%{NUMBER:request_time:float}%

{WORD}"

}

}

}

重新运行进程然后可以得到如下结果:

{

"message"=>"begin123.456end",

"@version"=>"1",

"@timestamp"=>"2014-08-09T12:23:36.634Z",

"host"=>"raochenlindeMacBook-Air.local",

"request_time"=>123.456

}

这次request_time变成数值类型了。

最佳实践

实际运用中,我们需要处理各种各样的日志文件,如果你都是在配置文件里各自写

一行自己的表达式,就完全不可管理了。所以,我们建议是把所有的grok表达式

统一写入到一个地方。然后用filter/grok的patterns_dir选项来指明。

如果你把"message"里所有的信息都grok到不同的字段了,数据实质上就相当于

是重复存储了两份。所以你可以用remove_field参数来删除掉message字

段,或者用overwrite参数来重写默认的message字段,只保留最重要的部

分。

重写参数的示例如下:

filter配置

64

filter{

grok{

patterns_dir=>["/path/to/your/own/patterns"]

match=>{

"message"=>"%{SYSLOGBASE}%{DATA:message}"

}

overwrite=>["message"]

}

}

更多有关grok正则性能的最佳实践(timeout_millis等),

见:https://www.elastic.co/blog/do-you-grok-grok

小贴士

多行匹配

在和codec/multiline搭配使用的时候,需要注意一个问题,grok正则和普通正则一

样,默认是不支持匹配回车换行的。就像你需要=~//m一样也需要单独指定,

具体写法是在表达式开始位置加(?m)标记。如下所示:

match=>{

"message"=>"(?m)\s+(?<request_time>\d+(?:\.\d+)?)\s+"

}

多项选择

有时候我们会碰上一个日志有多种可能格式的情况。这时候要写成单一正则就比较

困难,或者全用|隔开又比较丑陋。这时候,logstash的语法提供给我们一个有

趣的解决方式。

文档中,都说明logstash/filters/grok插件的match参数应该接受的是一个Hash

值。但是因为早期的logstash语法中Hash值也是用[]这种方式书写的,所以

其实现在传递Array值给match参数也完全没问题。所以,我们这里其实可以传

递多个正则来匹配同一个字段:

filter配置

65

dissect

grok作为Logstash最广为人知的插件,在性能和资源损耗方面同样也广为诟病。

为了应对这个情况,同时也考虑到大多数时候,日志格式并没有那么复杂,

Logstash开发团队在5.0版新添加了另一个解析字段的插件:dissect。

当日志格式有比较简明的分隔标志位,而且重复性较大的时候,我们可以使用

dissect插件更快的完成解析工作。下面是解析syslog的示例:

示例

filter{

dissect{

mapping=>{

"message"=>"%{ts}%{+ts}%{+ts}%{src}%{}%{prog}

[%{pid}]:%{msg}"

}

convert_datatype=>{

pid=>"int"

}

}

}

语法解释

我们看到上面使用了和Grok很类似的%{}语法来表示字段,这显然是基于习惯

延续的考虑。不过示例中%{+ts}的加号就不一般了。dissect除了字段外面的字

符串定位功能以外,还通过几个特殊符号来处理字段提取的规则:

%{+key}这个+表示,前面已经捕获到一个key字段了,而这次捕获的内

容,自动添补到之前key字段内容的后面。

%{+key/2}这个/2表示,在有多次捕获内容都填到key字段里的时候,拼

接字符串的顺序谁前谁后。 /2表示排第2位。

%{?string}这个?表示,这块只是一个占位,并不会实际生成捕获字段存到

Event里面。

filter配置

67

%{?string}%{&string}当同样捕获名称都是string,但是一个?一个&的

时候,表示这是一个键值对。

比如对http://rizhiyi.com/index.do?id=123写这么一段配置:

http://%{domain}/%{?url}?%{?arg1}=%{&arg1}

则最终生成的Event内容是这样的:

{

domain=>"rizhiyi.com",

id=>"123"

}

filter配置

68

GeoIP地址查询归类

GeoIP是最常见的免费IP地址归类查询库,同时也有收费版可以采购。GeoIP库

可以根据IP地址提供对应的地域信息,包括国别,省市,经纬度等,对于可视化

地图和区域统计非常有用。

配置示例

filter{

geoip{

source=>"message"

}

}

运行结果

filter配置

69

{

"message"=>"183.60.92.253",

"@version"=>"1",

"@timestamp"=>"2014-08-07T10:32:55.610Z",

"host"=>"raochenlindeMacBook-Air.local",

"geoip"=>{

"ip"=>"183.60.92.253",

"country_code2"=>"CN",

"country_code3"=>"CHN",

"country_name"=>"China",

"continent_code"=>"AS",

"region_name"=>"30",

"city_name"=>"Guangzhou",

"latitude"=>23.11670000000001,

"longitude"=>113.25,

"timezone"=>"Asia/Chongqing",

"real_region_name"=>"Guangdong",

"location"=>[

[0]113.25,

[1]23.11670000000001

]

}

}

配置说明

GeoIP库数据较多,如果你不需要这么多内容,可以通过fields选项指定自己

所需要的。下例为全部可选内容:

filter{

geoip{

fields=>["city_name","continent_code","country_code2

","country_code3","country_name","dma_code","ip","latitude"

,"longitude","postal_code","region_name","timezone"]

}

}

filter配置

70

需要注意的是: geoip.location是logstash通过latitude和longitude

额外生成的数据。所以,如果你是想要经纬度又不想重复数据的话,应该像下面这

样做:

filter{geoip{fields=>["city_name","country_code2","country_name","latitude",

"longitude","region_name"]remove_field=>["[geoip][latitude]","[geoip]

[longitude]"]}}```

小贴士

geoip插件的"source"字段可以是任一处理后的字段,比如"client_ip",但是字段

内容却需要小心!geoip库内只存有公共网络上的IP信息,查询不到结果的,会直

接返回null,而logstash的geoip插件对null结果的处理是:不生成对应的

geoip.字段。

所以读者在测试时,如果使用了诸如127.0.0.1,172.16.0.1,192.168.0.1,10.0.0.1

等内网地址,会发现没有对应输出!

filter配置

71

JSON编解码

在上一章,已经讲过在codec中使用JSON编码。但是,有些日志可能是一种复

合的数据结构,其中只是一部分记录是JSON格式的。这时候,我们依然需要在

filter阶段,单独启用JSON解码插件。

配置示例

filter{

json{

source=>"message"

target=>"jsoncontent"

}

}

运行结果

{

"@version":"1",

"@timestamp":"2014-11-18T08:11:33.000Z",

"host":"web121.mweibo.tc.sinanode.com",

"message":"{\"uid\":3081609001,\"type\":\"signal\"}",

"jsoncontent":{

"uid":3081609001,

"type":"signal"

}

}

小贴士

如果不打算使用多层结构的话,删掉target配置即可。新的结果如下:

filter配置

72

{

"@version":"1",

"@timestamp":"2014-11-18T08:11:33.000Z",

"host":"web121.mweibo.tc.sinanode.com",

"message":"{\"uid\":3081609001,\"type\":\"signal\"}",

"uid":3081609001,

"type":"signal"

}

filter配置

73

Key-Value切分

在很多情况下,日志内容本身都是一个类似于key-value的格式,但是格式具体的

样式却是多种多样的。logstash提供filters/kv插件,帮助处理不同样式的

key-value日志,变成实际的LogStash::Event数据。

配置示例

filter{

ruby{

init=>"@kname=['method','uri','verb']"

code=>"

new_event=LogStash::Event.new(Hash[@kname.zip(even

t.get('request').split('|'))])

new_event.remove('@timestamp')

event.append(new_event)

"

}

if[uri]{

ruby{

init=>"@kname=['url_path','url_args']"

code=>"

new_event=LogStash::Event.new(Hash[@kname.zip(

event.get('uri').split('?'))])

new_event.remove('@timestamp')

event.append(new_event)

"

}

kv{

prefix=>"url_"

source=>"url_args"

field_split=>"&"

remove_field=>["url_args","uri","request"]

}

}

}

filter配置

74

解释

Nginx访问日志中的$request,通过这段配置,可以详细切分成method,

url_path, verb, url_a, url_b...

进一步的,如果url_args中有过多字段,可能导致Elasticsearch集群因为频繁

updatemapping或者消耗太多内存在clusterstate上而宕机。所以,更优的选择,

是只保留明确有用的url_args内容,其他部分舍去。

kv{

prefix=>"url_"

source=>"url_args"

field_split=>"&"

include_keys=>["uid","cip"]

remove_field=>["url_args","uri","request"]

}

上例即表示,除了url_uid和url_cip两个字段以外,其他的url_*都不

保留。

filter配置

75

数值统计(Metrics)

filters/metrics插件是使用Ruby的Metriks模块来实现在内存里实时的计数和采样

分析。该模块支持两个类型的数值分析:meter和timer。下面分别举例说明:

Meter示例(速率阈值检测)

web访问日志的异常状态码频率是运维人员会非常关心的一个数据。通常我们的做

法,是通过logstash或者其他日志分析脚本,把计数发送到rrdtool或者graphite

里面。然后再通过check-graphite脚本之类的东西来检查异常并报警。

事实上这个事情可以直接在logstash内部就完成。比如如果最近一分钟504请求

的个数超过100个就报警:

filter{

metrics{

meter=>"error_%{status}"

add_tag=>"metric"

ignore_older_than=>10

}

if"metric"in[tags]{

ruby{

code=>"event.cancelif(event.get('[error_504][rat

e_1m]')*60>100)"

}

}

}

output{

if"metric"in[tags]{

exec{

command=>"echo\"Outofthreshold:%{[error_504][r

ate_1m]}\""

}

}

}

filter配置

76

这里需要注意*60的含义。

metriks模块生成的rate_1m/5m/15m意思是:最近1,5,15分钟的每秒速率!

Timer示例(boxandwhisker异常检测)

官版的filters/metrics插件只适用于metric事件的检查。由插件生成的新事件内部

不存有来自input区段的实际数据信息。所以,要完成我们的百分比分布箱体检

测,需要首先对代码稍微做几行变动,即在metric的timer事件里加一个属性,存

储最近一个实际事件的数

值:https://github.com/chenryn/logstash/commit/bc7bf34caf551d8a149605cf28e7

c5d33fae7458

有了这个last值,然后我们就可以用如下配置来探测异常数据了:

filter{

metrics{

timer=>{"rt"=>"%{request_time}"}

percentiles=>[25,75]

add_tag=>"percentile"

}

if"percentile"in[tags]{

ruby{

code=>"l=event.get('[rt][p75]')-event.get('[rt][p2

5]');event.set('[rt][low]',event.get('[rt][p25]')-l);event.set(

'[rt][high]',event.get('[rt][p75]')+l)"

}

}

}

output{

if"percentile"in[tags]and([rt][last]>[rt][high]or[r

t][last]<[rt][low]){

exec{

command=>"echo\"Anomaly:%{[rt][last]}\""

}

}

}

filter配置

77

小贴士:有关boxandshiskerplot内容和重要性,参见《数据之魅》一书。

filter配置

78

数据修改(Mutate)

filters/mutate插件是Logstash另一个重要插件。它提供了丰富的基础类型数据处

理能力。包括类型转换,字符串处理和字段处理等。

类型转换

类型转换是filters/mutate插件最初诞生时的唯一功能。其应用场景在之前

Codec/JSON小节已经提到。

可以设置的转换类型包括:"integer","float"和"string"。示例如下:

filter{

mutate{

convert=>["request_time","float"]

}

}

注意:mutate除了转换简单的字符值,还支持对数组类型的字段进行转换,即将

["1","2"]转换成[1,2]。但不支持对哈希类型的字段做类似处理。有这方面

需求的可以采用稍后讲述的filters/ruby插件完成。

字符串处理

gsub

仅对字符串类型字段有效

gsub=>["urlparams","[\\?#]","_"]

split

filter配置

79

filter{

mutate{

split=>["message","|"]

}

}

随意输入一串以 |分割的字符,比如"123|321|adfd|dfjld*=123",可以看到如下输

出:

{

"message"=>[

[0]"123",

[1]"321",

[2]"adfd",

[3]"dfjld*=123"

],

"@version"=>"1",

"@timestamp"=>"2014-08-20T15:58:23.120Z",

"host"=>"raochenlindeMacBook-Air.local"

}

join

仅对数组类型字段有效

我们在之前已经用split割切的基础再join回去。配置改成:

filter{

mutate{

split=>["message","|"]

}

mutate{

join=>["message",","]

}

}

filter区段之内,是顺序执行的。所以我们最后看到的输出结果是:

filter配置

80

{

"message"=>"123,321,adfd,dfjld*=123",

"@version"=>"1",

"@timestamp"=>"2014-08-20T16:01:33.972Z",

"host"=>"raochenlindeMacBook-Air.local"

}

merge

合并两个数组或者哈希字段。依然在之前split的基础上继续:

filter{

mutate{

split=>["message","|"]

}

mutate{

merge=>["message","message"]

}

}

我们会看到输出:

{

"message"=>[

[0]"123",

[1]"321",

[2]"adfd",

[3]"dfjld*=123",

[4]"123",

[5]"321",

[6]"adfd",

[7]"dfjld*=123"

],

"@version"=>"1",

"@timestamp"=>"2014-08-20T16:05:53.711Z",

"host"=>"raochenlindeMacBook-Air.local"

}

filter配置

81

如果src字段是字符串,会自动先转换成一个单元素的数组再合并。把上一示例中

的来源字段改成"host":

filter{

mutate{

split=>["message","|"]

}

mutate{

merge=>["message","host"]

}

}

结果变成:

{

"message"=>[

[0]"123",

[1]"321",

[2]"adfd",

[3]"dfjld*=123",

[4]"raochenlindeMacBook-Air.local"

],

"@version"=>"1",

"@timestamp"=>"2014-08-20T16:07:53.533Z",

"host"=>[

[0]"raochenlindeMacBook-Air.local"

]

}

看,目的字段"message"确实多了一个元素,但是来源字段"host"本身也由字符

串类型变成数组类型了!

下面你猜,如果来源位置写的不是字段名而是直接一个字符串,会产生什么奇特的

效果呢?

strip

lowercase

uppercase

filter配置

82

字段处理

rename

重命名某个字段,如果目的字段已经存在,会被覆盖掉:

filter{

mutate{

rename=>["syslog_host","host"]

}

}

update

更新某个字段的内容。如果字段不存在,不会新建。

replace

作用和update类似,但是当字段不存在的时候,它会起到add_field参数一样

的效果,自动添加新的字段。

执行次序

需要注意的是,filter/mutate内部是有执行次序的。其次序如下:

filter配置

83

rename(event)if@rename

update(event)if@update

replace(event)if@replace

convert(event)if@convert

gsub(event)if@gsub

uppercase(event)if@uppercase

lowercase(event)if@lowercase

strip(event)if@strip

remove(event)if@remove

split(event)if@split

join(event)if@join

merge(event)if@merge

filter_matched(event)

而filter_matched这个filters/base.rb里继承的方法也是有次序的。

@add_field.eachdo|field,value|

end

@remove_field.eachdo|field|

end

@add_tag.eachdo|tag|

end

@remove_tag.eachdo|tag|

end

filter配置

84

随心所欲的Ruby处理

如果你稍微懂那么一点点Ruby语法的话,filters/ruby插件将会是一个非常有用的

工具。

比如你需要稍微修改一下LogStash::Event对象,但是又不打算为此写一个完

整的插件,用filters/ruby插件绝对感觉良好。

配置示例

filter{

ruby{

init=>"@kname=['client','servername','url','status',

'time','size','upstream','upstreamstatus','upstreamtime','refere

r','xff','useragent']"

code=>"

new_event=LogStash::Event.new(Hash[@kname.zip(even

t.get('message').split('|'))])

new_event.remove('@timestamp')

event.append(new_event)"

}

}

官网示例是一个比较有趣但是没啥大用的做法——随机取消90%的事件。

所以上面我们给出了一个有用而且强大的实例。

解释

通常我们都是用filters/grok插件来捕获字段的,但是正则耗费大量的CPU资源,

很容易成为Logstash进程的瓶颈。

而实际上,很多流经Logstash的数据都是有自己预定义的特殊分隔符的,我们可

以很简单的直接切割成多个字段。

filter配置

85

filters/mutate插件里的"split"选项只能切成数组,后续很不方便使用和识别。而在

filters/ruby里,我们可以通过"init"参数预定义好由每个新字段的名字组成的数

组,然后在"code"参数指定的Ruby语句里通过两个数组的zip操作生成一个哈希

并添加进数组里。短短一行Ruby代码,可以减少50%以上的CPU使用率。

注1:从Logstash-2.3开始, LogStash::Event.append不再直接接受Hash对

象,而必须是LogStash::Event对象。所以示例变成要先初始化一个新event,

再把无用的@timestamp移除,再append进去。否则会把@timestamp变成

有两个时间的数组了!

注2:从Logstash-5.0开始, LogStash::Event改为Java实现,直接使用

event["parent"]["child"]形式获取的不是原事件的引用而是复制品。需要改

用event.get('[parent][child]')和event.set('[parent][child]',

'value')的方法。

filters/ruby插件用途远不止这一点,下一节你还会继续见到它的身影。

更多实例

2014年09年23日新增

filter{

date{

match=>["datetime","UNIX"]

}

ruby{

code=>"event.cancelif5*24*3600<(event['@timest

amp']-::Time.now).abs"

}

}

在实际运用中,我们几乎肯定会碰到出乎意料的输入数据。这都有可能导致

Elasticsearch集群出现问题。

当数据格式发生变化,比如UNIX时间格式变成UNIX_MS时间格式,会导致

logstash疯狂创建新索引,集群崩溃。

filter配置

86

或者误输入过老的数据时,因为一般我们会close几天之前的索引以节省内存,必

要时再打开。而直接尝试把数据写入被关闭的索引会导致内存问题。

这时候我们就需要提前校验数据的合法性。上面配置,就是用于过滤掉时间范围与

当前时间差距太大的非法数据的。

filter配置

87

split拆分事件

上一章我们通过multiline插件将多行数据合并进一个事件里,那么反过来,也可以

把一行数据,拆分成多个事件。这就是split插件。

配置示例

filter{

split{

field=>"message"

terminator=>"#"

}

}

运行结果

这个测试中,我们在intputs/stdin的终端中输入一行数据:"test1#test2",结果看

到输出两个事件:

{

"@version":"1",

"@timestamp":"2014-11-18T08:11:33.000Z",

"host":"web121.mweibo.tc.sinanode.com",

"message":"test1"

}

{

"@version":"1",

"@timestamp":"2014-11-18T08:11:33.000Z",

"host":"web121.mweibo.tc.sinanode.com",

"message":"test2"

}

重要提示

filter配置

88

split插件中使用的是yield功能,其结果是split出来的新事件,会直接结束其在

filter阶段的历程,也就是说写在split后面的其他filter插件都不起作用,进入到

output阶段。所以,一定要保证split配置写在全部filter配置的最后。

使用了类似功能的还有clone插件。

注:从logstash-1.5.0beta1版本以后修复该问题。

filter配置

89

elapsed

filter{

grok{

match=>["message","%{TIMESTAMP_ISO8601}STARTid:(?<task

_id>.*)"]

add_tag=>["taskStarted"]

}

grok{

match=>["message","%{TIMESTAMP_ISO8601}ENDid:(?<task_i

d>.*)"]

add_tag=>["taskTerminated"]

}

elapsed{

start_tag=>"taskStarted"

end_tag=>"taskTerminated"

unique_id_field=>"task_id"

}

}

filter配置

90

保存进Elasticsearch

Logstash可以使用不同的协议实现完成将数据写入Elasticsearch的工作。在不同

时期,也有不同的插件实现方式。本节以最新版为准,即主要介绍HTTP方式。同

时也附带一些原有的node和transport方式的介绍。

配置示例

output{

elasticsearch{

hosts=>["192.168.0.2:9200"]

index=>"logstash-%{type}-%{+YYYY.MM.dd}"

document_type=>"%{type}"

flush_size=>20000

idle_flush_time=>10

sniffing=>true

template_overwrite=>true

}

}

解释

批量发送

在过去的版本中,主要由本插件的flush_size和idle_flush_time两个参

数共同控制Logstash向Elasticsearch发送批量数据的行为。以上面示例来说:

Logstash会努力攒到20000条数据一次性发送出去,但是如果10秒钟内也没攒够

20000条,Logstash还是会以当前攒到的数据量发一次。

默认情况下, flush_size是500条, idle_flush_time是1秒。这也是很多

人改大了flush_size也没能提高写入ES性能的原因——Logstash还是1秒钟

发送一次。

filter配置

91

从5.0开始,这个行为有了另一个前提: flush_size的大小不能超过Logstash

运行时的命令行参数设置的batch_size,否则将以batch_size为批量发送

的大小。

索引名

写入的ES索引的名称,这里可以使用变量。为了更贴合日志场景,Logstash提供

了%{+YYYY.MM.dd}这种写法。在语法解析的时候,看到以+号开头的,就会自

动认为后面是时间格式,尝试用时间格式来解析后续字符串。所以,之前处理过程

中不要给自定义字段取个加号开头的名字……

此外,注意索引名中不能有大写字母,否则ES在日志中会报

InvalidIndexNameException,但是Logstash不会报错,这个错误比较隐晦,也容

易掉进这个坑中。

轮询

Logstash1.4.2在transport和http协议的情况下是固定连接指定host发送数据。

从1.5.0开始,host可以设置数组,它会从节点列表中选取不同的节点发送数据,

达到Round-Robin负载均衡的效果。

不同版本的协议沿革

1.4.0版本之前,有logstash-output-elasticsearch, logstash-output-

elasticsearch_http, logstash-output-elasticsearch_river三个插件。

1.4.0到2.0版本之间,配合Elasticsearch废弃river方法,只剩下logstash-

output-elasticsearch一个插件,同时实现了node、transport、http三种协

议。

2.0版本开始,为了兼容性和调试方便, logstash-output-elasticsearch改

为只支持http协议。想继续使用node或者transport协议的用户,需要单独安装

logstash-output-elasticsearch_java插件。

一个小集群里,使用node协议最方便了。Logstash以elasticsearch的client节点

身份(即不存数据不参加选举)运行。如果你运行下面这行命令,你就可以看到自己

的logstash进程名,对应的node.role值是c:

filter配置

92

#curl127.0.0.1:9200/_cat/nodes?v

hostipheap.percentram.percentloadnode.rolemaste

rname

local192.168.0.1027c-logstash-local-1036

-2012

local192.168.0.27d*Sunstreak

Logstash-1.5以后,也不再分发一个内嵌的elasticsearch服务器。如果你想变更

node协议下的这些配置,在$PWD/elasticsearch.yml文件里写自定义配置即

可,logstash会尝试自动加载这个文件。

对于拥有很多索引的大集群,你可以用transport协议。logstash进程会转发所有

数据到你指定的某台主机上。这种协议跟上面的node协议是不同的。node协议下

的进程是可以接收到整个Elasticsearch集群状态信息的,当进程收到一个事件

时,它就知道这个事件应该存在集群内哪个机器的分片里,所以它就会直接连接该

机器发送这条数据。而transport协议下的进程不会保存这个信息,在集群状态更

新(节点变化,索引变化都会发送全量更新)时,就不会对所有的logstash进程也发

送这种信息。更多Elasticsearch集群状态的细节,参阅本书后续章节。

小贴士

经常有同学问,为什么Logstash在有多个conf文件的情况下,进入ES的数

据会重复,几个conf数据就会重复几次。其实问题原因在之前启动参数章节

有提过,output段顺序执行,没有对日志type进行判断的各插件配置都会全

部执行一次。在output段对type进行判断的语法如下所示:

output{

if[type]=="nginxaccess"{

elasticsearch{}

}

}

模板

Elasticsearch支持给索引预定义设置和mapping(前提是你用的elasticsearch版本

支持这个API,不过估计应该都支持)。Logstash自带有一个优化好的模板,内容

如下:

filter配置

93

{

"template":"logstash-*",

"version":50001,

"settings":{

"index.refresh_interval":"5s"

},

"mappings":{

"_default_":{

"_all":{"enabled":true,"norms":false},

"dynamic_templates":[{

"message_field":{

"path_match":"message",

"match_mapping_type":"string",

"mapping":{

"type":"text",

"norms":false

}

}

},{

"string_fields":{

"match":"*",

"match_mapping_type":"string",

"mapping":{

"type":"text","norms":false,

"fields":{

"keyword":{"type":"keyword"}

}

}

}

}],

"properties":{

"@timestamp":{"type":"date","include_in_all"

:false},

"@version":{"type":"keyword","include_in_all"

:false},

"geoip":{

"dynamic":true,

"properties":{

"ip":{"type":"ip"},

filter配置

94

"location":{"type":"geo_point"},

"latitude":{"type":"half_float"},

"longitude":{"type":"half_float"}

}

}

}

}

}

}

这其中的关键设置包括:

templateforindex-pattern

只有匹配logstash-*的索引才会应用这个模板。有时候我们会变更Logstash

的默认索引名称,记住你也得通过PUT方法上传可以匹配你自定义索引名的模

板。当然,我更建议的做法是,把你自定义的名字放在"logstash-"后面,变成

index=>"logstash-custom-%{+yyyy.MM.dd}"这样。

refresh_intervalforindexing

Elasticsearch是一个近实时搜索引擎。它实际上是每1秒钟刷新一次数据。对于日

志分析应用,我们用不着这么实时,所以logstash自带的模板修改成了5秒钟。你

还可以根据需要继续放大这个刷新间隔以提高数据写入性能。

multi-fieldwithkeyword

Elasticsearch会自动使用自己的默认分词器(空格,点,斜线等分割)来分析字段。

分词器对于搜索和评分是非常重要的,但是大大降低了索引写入和聚合请求的性

能。所以logstash模板定义了一种叫"多字段"(multi-field)类型的字段。这种类型会

自动添加一个".keyword"结尾的字段,并给这个字段设置为不启用分词器。简单

说,你想获取url字段的聚合结果的时候,不要直接用"url",而是用"url.keyword"

作为字段名。当你还对分词字段发起聚合和排序请求的时候,直接提示无法构建

fielddata了!

在Logstash5.0中,同时还保留携带了针对Elasticsearch2.x的template文件,

在那里,通过旧版本的mapping配置,达到和新版本相同的行为效果:对应统计字

段明确设置"index":"not_analyzed","doc_values":true,以及对分词字段

加上对fielddata的{"format":"disabled"}。

filter配置

95

geo_point

Elasticsearch支持geo_point类型,geodistance聚合等等。比如说,你可以请求

某个geo_point点方圆10千米内数据点的总数。在Kibana的tilemap类型面板

里,就会用到这个类型的数据。

half_float

Elasticsearch5.0新引入了half_float类型。比标准的float类型占用更少的资源,

提供更好的性能。在明确自己数值范围较小的时候可用。刚巧,经纬度就是一个明

确的数值范围很小的数据。

其他模板配置建议

order

如果你有自己单独定制template的想法,很好。这时候有几种选择:

1. 在logstash/outputs/elasticsearch配置中开启manage_template=>false

选项,然后一切自己动手;

2. 在logstash/outputs/elasticsearch配置中开启template=>

"/path/to/your/tmpl.json"选项,让logstash来发送你自己写的

template文件;

3. 避免变更logstash里的配置,而是另外发送一个template,利用

elasticsearch的templatesorder功能。

这个order功能,就是elasticsearch在创建一个索引的时候,如果发现这个索引同

时匹配上了多个template,那么就会先应用order数值小的template设置,然后

再应用一遍order数值高的作为覆盖,最终达到一个merge的效果。

比如,对上面这个模板已经很满意,只想修改一下refresh_interval,那么只

需要新写一个:

{

"order":1,

"template":"logstash-*",

"settings":{

"index.refresh_interval":"20s"

}

}

filter配置

96

然后运行curl-XPUThttp://localhost:9200/_template/template_newid-

d'@/path/to/your/tmpl.json'即可。

logstash默认的模板,order是0,id是logstash,通过

logstash/outputs/elasticsearch的配置选项template_name修改。你的新模板就

不要跟这个名字冲突了。

filter配置

97

发送邮件(Email)

配置示例

output{

email{

to=>"admin@website.com,root@website.com"

cc=>"other@website.com"

via=>"smtp"

subject=>"Warning:%{title}"

options=>{

smtpIporHost=>"localhost",

port=>25,

domain=>'localhost.localdomain',

userName=>nil,

password=>nil,

authenticationType=>nil,#(plain,loginandcram_

md5)

starttls=>true

}

htmlbody=>""

body=>""

attachments=>["/path/to/filename"]

}

}

注意:以上示例适用于Logstash1.5,options=>的参数配置在

Logstash2.0之后的版本已被移除,(126邮箱发送到qq邮箱)示例如下:

filter配置

98

output{

email{

port=>"25"

address=>"smtp.126.com"

username=>"test@126.com"

password=>""

authentication=>"plain"

use_tls=>true

from=>"test@126.com"

subject=>"Warning:%{title}"

to=>"test@qq.com"

via=>"smtp"

body=>"%{message}"

}

}

解释

outputs/email插件支持SMTP协议和sendmail两种方式,通过via参数设置。

SMTP方式有较多的options参数可配置。sendmail只能利用本机上的sendmail

服务来完成——文档上描述了Mail库支持的sendmail配置参数,但实际代码中

没有相关处理,不要被迷惑了。。。

filter配置

99

调用命令执行(Exec)

outputs/exec插件的运用也非常简单,如下所示,将logstash切割成的内容作为参

数传递给命令。这样,在每个事件到达该插件的时候,都会触发这个命令的执行。

output{

exec{

command=>"sendsms.pl\"%{message}\"-t%{user}"

}

}

需要注意的是。这种方式是每次都重新开始执行一次命令并退出。本身是比较慢速

的处理方式(程序加载,网络建联等都有一定的时间消耗)。最好只用于少量的信息

处理场景,比如不适用nagios的其他报警方式。示例就是通过短信发送消息。

filter配置

100

保存成文件(File)

通过日志收集系统将分散在数百台服务器上的数据集中存储在某中心服务器上,这

是运维最原始的需求。早年的scribed,甚至直接就把输出的语法命名为

<store>。Logstash当然也能做到这点。

和LogStash::Inputs::File不同, LogStash::Outputs::File里可以使用

sprintfformat格式来自动定义输出到带日期命名的路径。

配置示例

output{

file{

path=>"/path/to/%{+yyyy}/%{+MM}/%{+dd}/%{host}.log.gz"

message_format=>"%{message}"

gzip=>true

}

}

解释

使用output/file插件首先需要注意的就是message_format参数。插件默认是输

出整个event的JSON形式数据的。这可能跟大多数情况下使用者的期望不符。大

家可能只是希望按照日志的原始格式保存就好了。所以需要定义为%

{message},当然,前提是在之前的filter插件中,你没有使用remove_field

或者update等参数删除或修改%{message}字段的内容。

另一个非常有用的参数是gzip。gzip格式是一个非常奇特而友好的格式。其格式包

括有:

10字节的头,包含幻数、版本号以及时间戳

可选的扩展头,如原文件名

文件体,包括DEFLATE压缩的数据

8字节的尾注,包括CRC-32校验和以及未压缩的原始数据长度

filter配置

101

这样gzip就可以一段一段的识别出来数据——反过来说,也就是可以一段一段压

缩了添加在后面!

这对于我们流式添加数据简直太棒了!

小贴士:你或许见过网络流传的parallel命令行工具并发处理数据的神奇文档,但

在自己用的时候总见不到效果。实际上就是因为:文档中处理的gzip文件,可以分

开处理然后再合并的。

注意

1. 按照Logstash标准,其实应该可以把数据格式的定义改在codec插件中完

成,但是logstash-output-file插件内部实现中跳过了@codec.decode这

步,所以codec设置无法生效!

2. 按照Logstash标准,配置参数的值可以使用eventsprintf格式。但是

logstash-output-file插件对event.sprintf(@path)的结果,还附加了一步

inside_file_root?校验(个人猜测是为了防止越权到其他路径),这个

file_root是通过直接对path参数分割/符号得到的。如果在sprintf格

式中带有/符号,那么被切分后的结果就无法正确解析了。

所以,如下所示配置,虽然看起来是正确的,实际效果却不对,正确写法应该是本

节之前的配置示例那样。

output{

file{

path=>"/path/to/%{+yyyy/MM/dd}/%{host}.log.gz"

codec=>line{

format=>"%{message}"

}

}

}

filter配置

102

报警到Nagios

Logstash中有两个output插件是nagios有关的。outputs/nagios插件发送数据给

本机的nagios.cmd管道命令文件,outputs/nagios_nsca插件则是调用

send_nsca命令以NSCA协议格式把数据发送给nagios服务器(远端或者本地皆

可)。

Nagios.Cmd

nagios.cmd是nagios服务器的核心组件。nagios事件处理和内外交互都是通过这

个管道文件来完成的。

使用CMD方式,需要自己保证发送的Logstash事件符合nagios事件的格式。即

必须在filter阶段预先准备好nagios_host和nagios_service字段;此外,

如果在filter阶段也准备好nagios_annotation和nagios_level字段,这里

也会自动转换成nagios事件信息。

filter{

if[message]=~/err/{

mutate{

add_tag=>"nagios"

rename=>["host","nagios_host"]

replace=>["nagios_service","logstash_check_%{type

}"]

}

}

}

output{

if"nagios"in[tags]{

nagios{}

}

}

如果不打算在filter阶段提供nagios_level,那么也可以在该插件中通过参数

配置。

filter配置

103

所谓nagios_level,即我们通过nagiosplugin检查数据时的返回值。其取值范

围和含义如下:

"0",代表"OK",服务正常;

"1",代表"WARNNING",服务警告,一般nagiosplugin命令中使用-w参

数设置该阈值;

"2",代表"CRITICAL",服务危急,一般nagiosplugin命令中使用-c参数

设置该阈值;

"3",代表"UNKNOWN",未知状态,一般会在timeout等情况下出现。

默认情况下,该插件会以"CRITICAL"等级发送报警给Nagios服务器。

nagios.cmd文件的具体位置,可以使用command_file参数设置。默认位置是

"/var/lib/nagios3/rw/nagios.cmd"。

关于和nagios.cmd交互的具体协议说明,有兴趣的读者请阅读Usingexternal

commandsinNagios一文,这是《LearningNagios3.0》书中内容节选。

NSCA

NSCA是一种标准的nagios分布式扩展协议。分布在各机器上的send_nsca进

程主动将监控数据推送给远端nagios服务器的NSCA进程。

当Logstash跟nagios服务器没有在同一个主机上运行的时候,就只能通过NSCA

方式来发送报警了——当然也必须在Logstash服务器上安装send_nsca命

令。

nagios事件所需要的几个属性在上一段中已经有过描述。不过在使用这个插件的时

候,不要求提前准备好,而是可以在该插件内部定义参数:

output{

nagios_nsca{

nagios_host=>"%{host}"

nagios_service=>"logstash_check_%{type}"

nagios_status=>"2"

message_format=>"%{@timestamp}:%{message}"

host=>"nagiosserver.domain.com"

}

}

filter配置

104

这里请注意, host和nagios_host两个参数,分别是用来设置nagios服务

器的地址,和报警信息中有问题的服务器地址。

关于NSCA原理,架构和配置说明,还不了解的读者请阅读官方网站Using

NSClient++fromnagioswithNSCA一节。

推荐阅读

除了nagios以外,logstash同样可以发送信息给其他常见监控系统。方式和

nagios大同小异:

outputs/ganglia插件通过UDP协议,发送gmetric型数据给本机/远端的

gmond或者gmetad

outputs/zabbix插件调用本机的zabbix_sender命令发送

filter配置

105

输出到Statsd

基础知识

Statsd最早是2008年Flickr公司用Perl写的针对Graphite、datadog等监控数据

后端存储开发的前端网络应用,2011年Etsy公司用node.js重构。用于接收(默认

UDP)、写入、读取和聚合时间序列数据,包括即时值和累积值等。

Graphite是用Python模仿RRDtools写的时间序列数据库套件。包括三个部分:

carbon:是一个Twisted守护进程,监听处理数据;

whisper:存储时间序列的数据库;

webapp:一个用Django框架实现的网页应用。

Graphite安装简介

通过如下几步安装Graphite:

1. 安装cairo和pycairo库

#yum-yinstallcairopycairo

1. pip安装

#yuminstallpython-develpython-pip

#pipinstalldjangodjango-taggingcarbonwhispergraphite-web

uwsgi

1. 配置Graphite

#cd/opt/graphite/webapp/graphite

#cplocal_settings.py.examplelocal_settings.py

#pythonmanage.pysyncdb

修改local_settings.py中的DATABASE为设置的db信息。

filter配置

106

1. 启动cabon

#cd/opt/graphite/conf/

#cpcarbon.conf.examplecarbon.conf

#cpstorage-schemas.conf.examplestorage-schemas.conf

#cd/opt/graphite/

#./bin/carbon-cache.pystart

statsd安装简介

1. Graphite地址设置

#cd/opt/

#gitclonegit://github.com/etsy/statsd.git

#cd/opt/statsd

#cpexampleConfig.jsConfig.js

根据Graphite服务器地址,修改Config.js中的配置如下:

{

graphitePort:2003,

graphiteHost:"10.10.10.124",

port:8125,

backends:["./backends/graphite"]

}

1. uwsgi配置

filter配置

107

cd/opt/graphite/webapp/graphite

cat>wsgi_graphite.xml<<EOF

<uwsgi>

<socket>0.0.0.0:8630</socket>

<workers>2</workers>

<processes>2</processes>

<listen>100</listen>

<chdir>/opt/graphite/webapp/graphite</chdir>

<pythonpath>..</pythonpath>

<module>wsgi</module>

<pidfile>graphite.pid</pidfile>

<master>true</master>

<enable-threads>true</enable-threads>

<logdate>true</logdate>

<daemonize>/var/log/uwsgi_graphite.log</daemonize>

</uwsgi>

EOF

cp/opt/graphite/conf/graphite.wsgi/opt/graphite/webapp/graphit

e/wsgi.py

1. nginx的uwsgi配置

filter配置

108

cat>/usr/local/nginx/conf/conf.d/graphite.conf<<EOF

server{

listen8081;

server_namegraphite;

access_log/opt/graphite/storage/log/webapp/access.log;

error_log/opt/graphite/storage/log/webapp/error.log;

location/{

uwsgi_pass0.0.0.0:8630;

includeuwsgi_params;

proxy_connect_timeout300;

proxy_send_timeout300;

proxy_read_timeout300;

}

}

EOF

1. 启动

#uwsgi-x/opt/graphite/webapp/graphite/wsgi_graphite.xml

#systemctlnginxreload

1. 数据测试

echo"test.logstash.num:100|c"|nc-w1-u$IP$port

如果安装配置是正常的,在graphite的左侧metrics->stats->test->logstash->num的

表,statsd里面多了numStats等数据。

配置示例

filter配置

109

output{

statsd{

host=>"statsdserver.domain.com"

namespace=>"logstash"

sender=>"%{host}"

increment=>["httpd.response.%{status}"]

}

}

解释

Graphite以树状结构存储监控数据,所以statsd也是如此。所以发送给statsd的

数据的key也一定得是"first.second.tree.four"这样的形式。而在logstash-output-

statsd插件中,就会以三个配置参数来拼接成这种形式:

namespace.sender.metric

其中namespace和sender都是直接设置的,而metric又分为好几个不同的参数

可以分别设置。statsd支持的metric类型如下:

metric类型

increment增量,一个计量周期内,某个数字接收了多少次,比如nginx的

status状态码。

示例语法: increment=>["nginx.status.%{status}"]

decrement

语法同increment。

count对数字的计数,比如,每秒接收一个数字,一个计量周期内,所有数字

的和,比如nginx的body_bytes_sent。

示例语法: count=>{"nginx.bytes"=>"%{bytes}"}

gauge

filter配置

110

语法同count。

set

语法同count。

timing时间范围内,某种数字的最大值,最小值,平均值,比如nginx的响应

时间request_time。

语法同count。

关于这些metric类型的详细说明,请阅读statsd文

档:https://github.com/etsy/statsd/blob/master/docs/metric_types.md。

推荐阅读

Etsy发布nodejs版本statsd的博客:MeasureAnything,Measure

Everything

Flickr发布statsd的博客:Counting&Timing

filter配置

111

标准输出(Stdout)

和之前inputs/stdin插件一样,outputs/stdout插件也是最基础和简单的输出插件。

同样在这里简单介绍一下,作为输出插件的一个共性了解。

配置示例

output{

stdout{

codec=>rubydebug

workers=>2

}

}

解释

输出插件统一具有一个参数是workers。Logstash为输出做了多线程的准备。

其次是codec设置。codec的作用在之前已经讲过。可能除了

codecs/multiline,其他codec插件本身并没有太多的设置项。所以一般省略

掉后面的配置区段。换句话说。上面配置示例的完全写法应该是:

output{

stdout{

codec=>rubydebug{

}

workers=>2

}

}

单就outputs/stdout插件来说,其最重要和常见的用途就是调试。所以在不太有效

的时候,加上命令行参数-vv运行,查看更多详细调试信息。

filter配置

112

filter配置

113

发送网络数据(TCP)

虽然之前我们已经提到过不建议直接使用LogStash::Inputs::TCP和

LogStash::Outputs::TCP做转发工作,不过在实际交流中,发现确实有不少朋友觉

得这种简单配置足够使用,因而不愿意多加一层消息队列的。所以,还是把

Logstash如何直接发送TCP数据也稍微提点一下。

配置示例

output{

tcp{

host=>"192.168.0.2"

port=>8888

codec=>json_lines

}

}

配置说明

在收集端采用tcp方式发送给远端的tcp端口。这里需要注意的是,默认的codec

选项是json。而远端的LogStash::Inputs::TCP的默认codec选项却是line!所

以不指定各自的codec,对接肯定是失败的。

另外,由于IOBUFFER的原因,即使是两端共同约定为json依然无法正常运行,

接收端会认为一行数据没结束,一直等待直至自己OutOfMemory!

所以,正确的做法是,发送端指定codec为json_lines,这样每条数据后面会加

上一个回车,接收端指定codec为json_lines或者json均可,这样才能正常处

理。包括在收集端已经切割好的字段,也可以直接带入收集端使用了。

filter配置

114

HDFS

https://github.com/dstore-dbap/logstash-webhdfs

ThispluginbasedonWebHDFSapiofHadoop,itjustPOSTdatatoWebHDFS

port.So,it'sanativeRubycode.

output{

hadoop_webhdfs{

workers=>2

server=>"your.nameno.de:14000"

user=>"flume"

path=>"/user/flume/logstash/dt=%{+Y}-%{+M}-%{+d}/logst

ash-%{+H}.log"

flush_size=>500

compress=>"snappy"

idle_flush_time=>10

retry_interval=>0.5

}

}

https://github.com/avishai-ish-shalom/logstash-hdfs

ThispluginbasedonHDFSapiofHadoop,itimportjavaclasseslike

org.apache.hadoop.fs.FileSystemetc.

Configuration

output{

hdfs{

path=>"/path/to/output_file.log"

enable_append=>true

}

}

filter配置

115

Howtorun

CLASSPATH=$(find/path/to/hadoop-name'*.jar'|tr'\n'':'):/e

tc/hadoop/conf:/path/to/logstash-1.1.7-monolithic.jarjavalogst

ash.runneragent-fconf/hdfs-output.conf-p/path/to/cloned/log

stash-hdfs

filter配置

116

场景示例

前面虽然介绍了几十个常用的Logstash插件的常见配置项。但是过多的选择下,

如何组合使用这些插件,依然是一部分用户的幸福难题。本节,列举一些最常见的

日志场景,演示一下针对性的组件搭配。希望能给读者带来一点启发。

场景示例

117

Nginx访问日志

grok

Logstash默认自带了apache标准日志的grok正则:

COMMONAPACHELOG%{IPORHOST:clientip}%{USER:ident}%{NOTSPACE:au

th}\[%{HTTPDATE:timestamp}\]"(?:%{WORD:verb}%{NOTSPACE:reques

t}(?:HTTP/%{NUMBER:httpversion})?|%{DATA:rawrequest})"%{NUMBER

:response}(?:%{NUMBER:bytes}|-)

COMBINEDAPACHELOG%{COMMONAPACHELOG}%{QS:referrer}%{QS:agent}

对于nginx标准日志格式,可以发现只是最后多了一个

$http_x_forwarded_for变量。所以nginx标准日志的grok正则定义是:

MAINNGINXLOG%{COMBINEDAPACHELOG}%{QS:x_forwarded_for}

自定义的日志格式,可以照此修改。

split

nginx日志因为部分变量中内含空格,所以很多时候只能使用%{QS}正则来做分

割,性能和细度都不太好。如果能自定义一个比较少见的字符作为分隔符,那么处

理起来就简单多了。假设定义的日志格式如下:

log_formatmain"$http_x_forwarded_for|$time_local|$request

|$status|$body_bytes_sent|"

"$request_body|$content_length|$http_referer

|$http_user_agent|$nuid|"

"$http_cookie|$remote_addr|$hostname|$upst

ream_addr|$upstream_response_time|$request_time";

实际日志如下:

nginx访问日志

118

117.136.9.248|08/Apr/2015:16:00:01+0800|POST/notice/newmessage?

sign=cba4f614e05db285850cadc696fcdad0&token=JAGQ92Mjs3--

gik_b_DsPIQHcyMKYGpD&did=4b749736ac70f12df700b18cd6d051d5&osn=

android&osv=4.0.4&appv=3.0.1&net=460-02-

2g&longitude=120.393006&latitude=36.178329&ch=360&lp=1&ver=1&ts=142

8479998151&im=869736012353958&sw=0&sh=0&la=zh-

CN&lm=weixin&dt=vivoS11tHTTP/1.1|200|132|abcd-sign-

v1://dd03c57f8cb6fcef919ab5df66f2903f:d51asq5yslwnyz5t/{\x22type\x22:4,\x

22uid\x22:7567306}|89|-|abcd/3.0.1,Android/4.0.4,vivoS11t|

nuid=0C0A0A0A01E02455EA7CF47E02FD072C1428480001.157|-|

10.10.10.13|bnx02.abcdprivate.com|10.10.10.22:9999|0.022|0.022

59.50.44.53|08/Apr/2015:16:00:01+0800|POST/feed/pubList?

appv=3.0.3&did=89da72550de488328e2aba5d97850e9f&dt=iPhone6%2C2&i

m=B48C21F3-487E-4071-9742-

DC6D61710888&la=cn&latitude=0.000000&lm=weixin&longitude=0.000000&l

p=-1.000000&net=0-0-

wifi&osn=iOS&osv=8.1.3&sh=568.000000&sw=320.000000&token=7NobA7a

sg3Jb6n9o4ETdPXyNNiHwMs4J&ts=1428480001275HTTP/1.1|200|983|

abcd-sign-

v1://b398870a0b25b29aae65cd553addc43d:72214ee85d7cca22/{\x22nextke

y\x22:\x22\x22,\x22uid\x22:\x2213062545\x22,\x22token\x22:\x227NobA7asg

3Jb6n9o4ETdPXyNNiHwMs4J\x22}|139|-|Shopping/3.0.3(iPhone;iOS

8.1.3;Scale/2.00)|

nuid=0C0A0A0A81DF2455017D548502E48E2E1428480001.154|

nuid=CgoKDFUk34GFVH0BLo7kAg==|10.10.10.11|bnx02.abcdprivate.com

|10.10.10.35:9999|0.025|0.026

然后还可以针对request做更细致的切分。比如URL参数部分。很明显,URL参

数中的字段,顺序是乱的,第一行,问号之后的第一个字段是sign,第二行问号之

后的第一个字段是appv,所以需要将字段进行切分,取出每个字段对应的值。官

方自带grok满足不了要求。最终采用的logstash配置如下:

filter{

ruby{

init=>"@kname=['http_x_forwarded_for','time_local','

request','status','body_bytes_sent','request_body','content_leng

th','http_referer','http_user_agent','nuid','http_cookie','remot

nginx访问日志

119

e_addr','hostname','upstream_addr','upstream_response_time','req

uest_time']"

code=>"

new_event=LogStash::Event.new(Hash[@kname.zip(even

t.get('message').split('|'))])

new_event.remove('@timestamp')

event.append(new_event)

"

}

if[request]{

ruby{

init=>"@kname=['method','uri','verb']"

code=>"

new_event=LogStash::Event.new(Hash[@kname.zip(

event.get('request').split(''))])

new_event.remove('@timestamp')

event.append(new_event)

"

}

if[uri]{

ruby{

init=>"@kname=['url_path','url_args']"

code=>"

new_event=LogStash::Event.new(Hash[@kname.

zip(event.get('uri').split('?'))])

new_event.remove('@timestamp')

event.append(new_event)

"

}

kv{

prefix=>"url_"

source=>"url_args"

field_split=>"&"

remove_field=>["url_args","uri","request"]

}

}

}

mutate{

convert=>[

"body_bytes_sent","integer",

nginx访问日志

120

"content_length","integer",

"upstream_response_time","float",

"request_time","float"

]

}

date{

match=>["time_local","dd/MMM/yyyy:hh:mm:ssZ"]

locale=>"en"

}

}

最终结果:

{

"message"=>"1.43.3.188|08/Apr/2015:16:00:

01+0800|POST/search/suggest?appv=3.0.3&did=dfd5629d705d40079

5f698055806f01d&dt=iPhone7%2C2&im=AC926907-27AA-4A10-9916-C5DC75

F29399&la=cn&latitude=-33.903867&lm=sina&longitude=151.208137&lp